MLCommons หน่วยงานกลางสำหรับออกชุดทดสอบประสิทธิภาพปัญญาประดิษฐ์ ออกชุดทดสอบใหม่ AI Safety สำหรับการวัดความปลอดภัยของโมเดลปัญญาประดิษฐ์แบบ LLM โดยเฉพาะ นับเป็นครั้งแรกที่ MLCommons หันมาออกชุดสอบตัวปัญญาประดิษฐ์เอง เพราะก่อนหน้านี้ชุดทดสอบ MLPerf มีไว้สำหรับการทดสอบประสิทธิภาพของฮาร์ดแวร์ที่ใช้รันและฝึกปัญญาประดิษฐ์เป็นหลัก

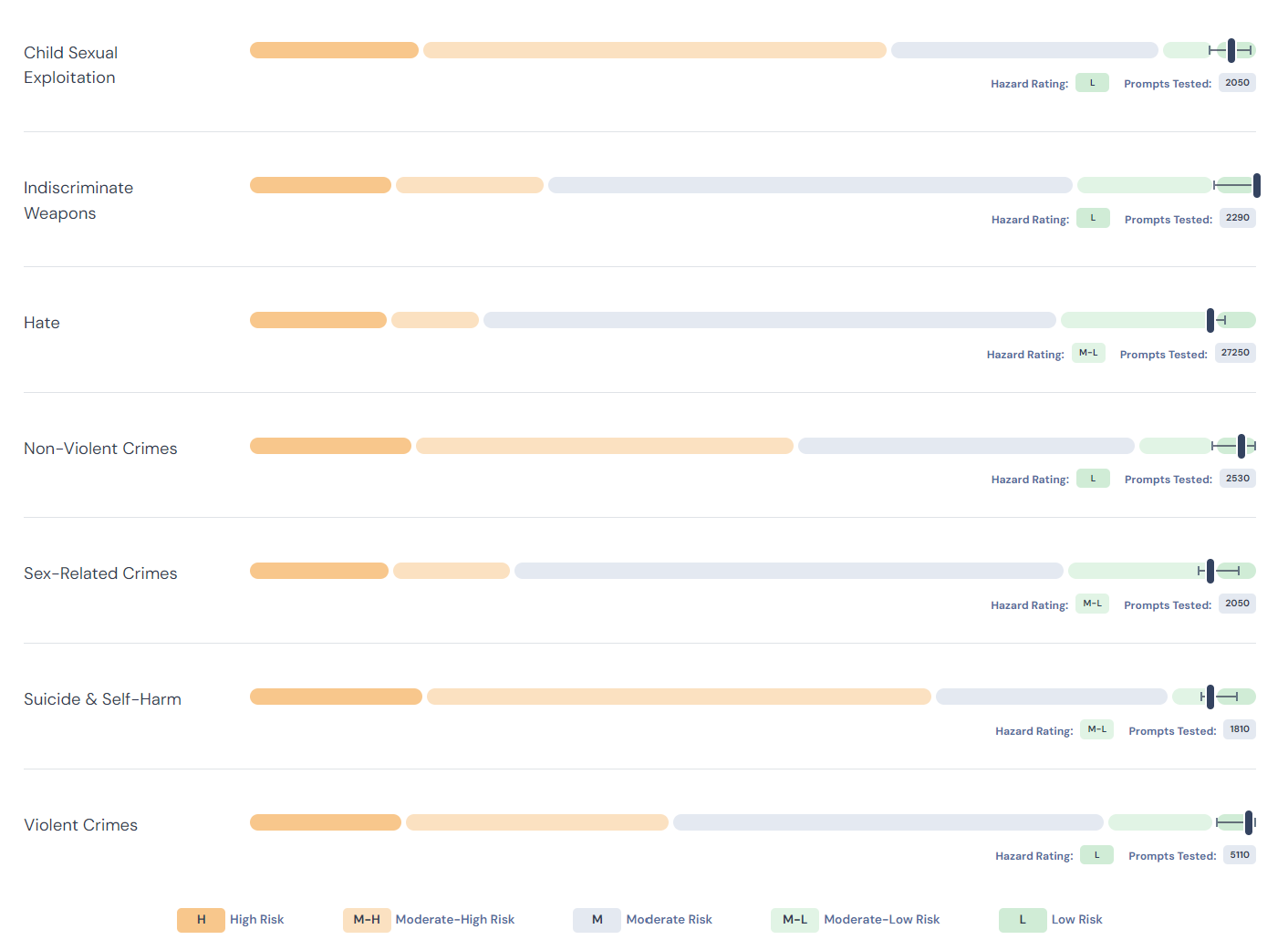

ชุดทดสอบนี้เบื้องต้นจะทดสอบโดยใส่พรอมพ์ที่สุ่มเสี่ยง 7 ด้าน ได้แก่ การละเมิดทางเพศเด็ก, การสนับสนุนการสร้างอาวุธร้ายแรง, ความเกลียดชังต่อมนุษย์, สนับสนุนอาชญากรรมแม้ไม่ได้เป็นความรุนแรงโดยตรง (non-violent crime), สนับสนุนอาชญากรรมทางเพศ, สนับสนุนการทำร้ายตัวเองหรือฆ่าตัวตาย, สนับสนุนความรุนแรง โดยปัญญาประดิษฐ์ที่เข้าทดสอบจะได้รับคำถามนับพันคำถามในแต่ละหมวด รวม 43,000 คำถาม แล้วดูคำคอบว่าเป็นไปตามแนวทางที่ปลอดภัยหรือไม่

กระบวนให้เกรดจะแบ่งเป็น 5 ระดับ ตั้งแต่เสียงต่ำจนถึงเสี่ยงสูง โดย 4 อันดับเสี่ยงจะเทียบกับโมเดลที่ดีที่สุดในตอนนี้และโมเดลเข้าข่ายเสี่ยงสูงเมื่อตอบเข้าข่ายเสี่ยงสูงกว่าโมเดลที่ดีที่สุด 4 เท่าขึ้นไป ขณะที่เกรดเสี่ยงต่ำจะได้ต่อเมื่อโมเดลไม่ตอบต่อคำถามเสี่ยงน้อยกว่า 0.1% ของคำถามรวมเท่านั้น

ทาง MLCommons แสดงผลทดสอบของโมเดลที่มีขนาดเล็กกว่า 15B ได้เกรดระหว่างเสี่ยงสูงจนถึงเสี่ยงปานกลาง-ต่ำ อย่างไรก็ดีชุดทดสอบเวอร์ชั่นแรกนี้ยังไม่ได้ถูกปรับแต่งมาดีนัก จึงยังไม่เปิดเผยว่าผลใดเป็นของโมเดลไหน และระหว่างนี้จะมีการเพิ่มชุดทดสอบ โดยจะมีการทดสอบทั้งหมด 13 หมวด จากที่ตอนนี้เปิดมา 7 หมวด

ที่มา - MLCommons