ท่ามกลางสงคราม AI ระหว่างบริษัทยักษ์ใหญ่ เช่น Google, Meta, Microsoft+OpenAI รวมถึงรายย่อยลงมาอย่าง Stable Diffusion ถึงแม้ยังไม่เห็นผลแพ้ชนะในเร็ววัน แต่ผู้ชนะตัวจริงอาจเป็น NVIDIA ผู้ขายจีพียูรุ่นท็อปสำหรับเทรนโมเดลขนาดใหญ่ ที่ทุกบริษัทต้องซื้อหามาใช้งาน

จีพียูยอดนิยมของวงการ AI คือ NVIDIA A100 ที่เปิดตัวในปี 2020 ราคาตัวละเกือบ 10,000 ดอลลาร์ เซิร์ฟเวอร์ทั้งชุด DGX A100 มีจีพียู 8 ตัว มีราคาขายราว 200,000 ดอลลาร์ คาดกันว่า NVIDIA ครองตลาดจีพียู AI ถึง 95% เรียกได้ว่าแทบไร้คู่แข่ง

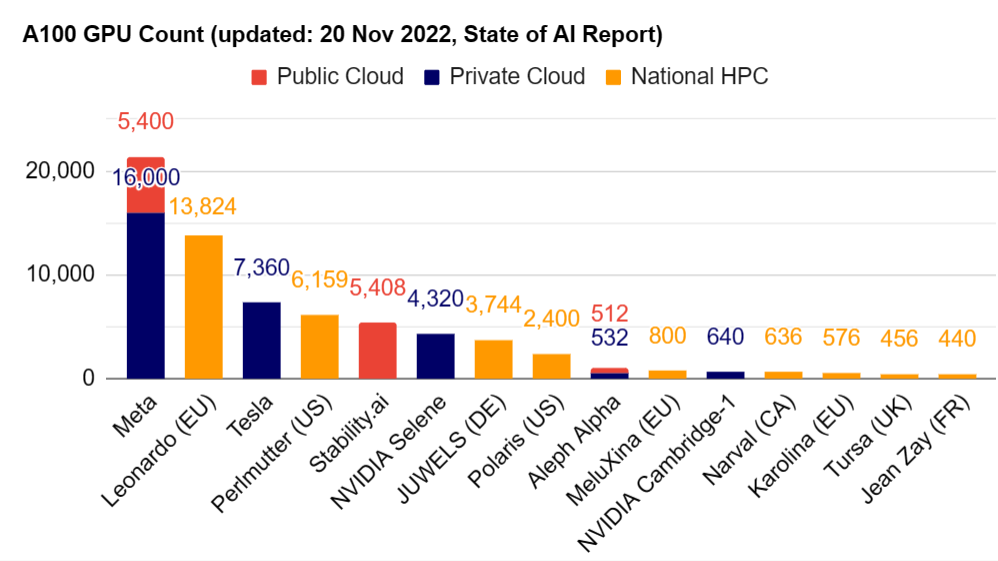

ตัวอย่างลูกค้าของ NVIDIA คือบริษัท Stability AI เจ้าของโมเดล Stable Diffusion ที่ซีอีโอ Emad Mostaque เคยโพสต์ในทวิตเตอร์ว่าปีที่แล้วมี A100 จำนวน 32 ตัว ตอนนี้กำลังสะสม A100 เพิ่มขึ้น (มีรายงานประเมินว่าตอนนี้มี 5,400 ตัวแล้ว แต่ยังไม่มีตัวเลขอย่างเป็นทางการ)

A year ago we had 32 A100s 👀Dream big and stack moar GPUs kids.Brrrr

— Emad (@EMostaque) January 17, 2023

ลูกค้ารายใหญ่ของ NVIDIA คือ Meta ที่มีจีพียูถึง 16,000 ตัว, ซูเปอร์คอมพิวเตอร์ Leonardo ของรัฐบาลอิตาลี 13,800 ตัว, Tesla 7,360 ตัว เป็นต้น ตัวเลขนี้ยังไม่นับรวมผู้ให้บริการคลาวด์อย่าง Microsoft, AWS, GCP ที่มีจีพียูให้เช่าอีกจำนวนมากด้วย

มีตัวเลขประเมินจาก New Street Research ว่าโมเดล ChatGPT ของ Bing จำเป็นต้องใช้จีพียู 8 ตัวในการประมวลผลต่อหนึ่งคำถาม และไมโครซอฟท์จำเป็นต้องใช้เซิร์ฟเวอร์จีพียูทั้งหมดราว 20,000 เครื่อง (เครื่องละ 8 จีพียู) เพื่อให้บริการ Bing กับผู้ใช้ทุกคน ต้นทุนแค่ค่าเครื่องอาจสูงถึง 4 พันล้านดอลลาร์

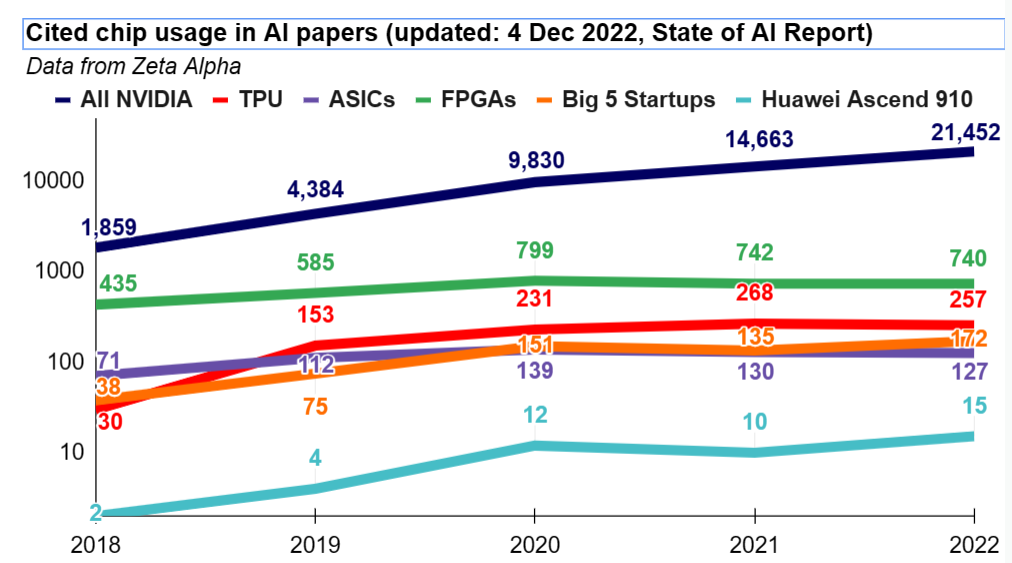

หากไม่ใช้จีพียู NVIDIA แล้วมีทางเลือกอื่นใดบ้าง คู่แข่งในตลาดที่ชัดเจนตอนนี้เป็นสายคลาวด์ เช่น กูเกิลที่ทำ TPU ใช้เอง, AWS มีชิปออกแบบเองชื่อ Inferentia ส่วนอินเทลและ AMD ถึงแม้มีชิปแบบเดียวกัน (เช่น Intel Habana)

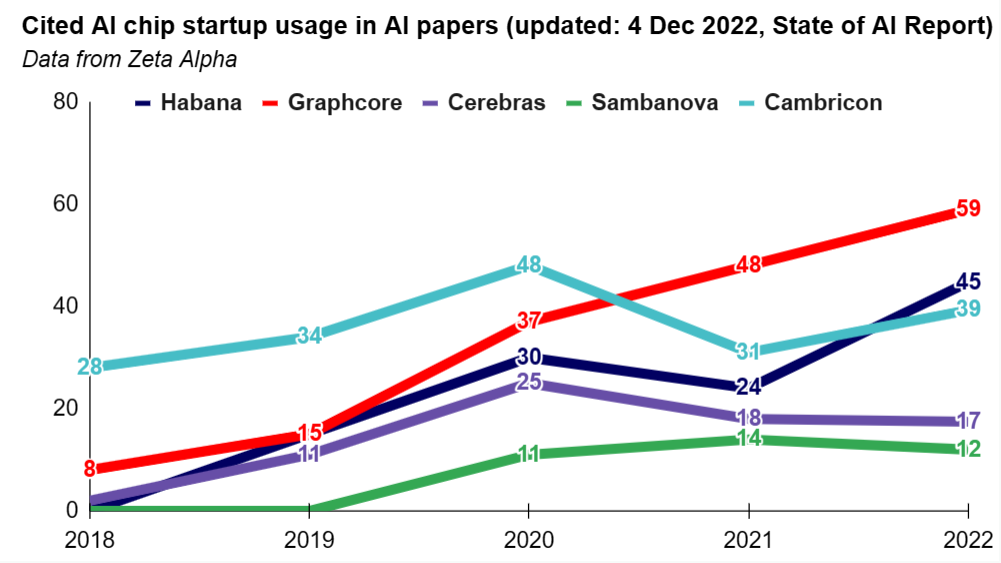

ในอีกทางยังมีสตาร์ตอัพที่พยายามทำชิป AI เฉพาะทาง เช่น Cerebras, Graphcore, Sambanova, Cambricon แต่ก็ยังไม่มีส่วนแบ่งตลาดมากนัก หากลองดูจากปริมาณเปเปอร์วิจัยด้าน AI ที่ระบุว่าใช้งานชิป NVIDIA มีรวมกันเกิน 21,000 ชิ้น ในขณะที่ใช้ชิปทางเลือกเพียงหลักสิบเท่านั้น

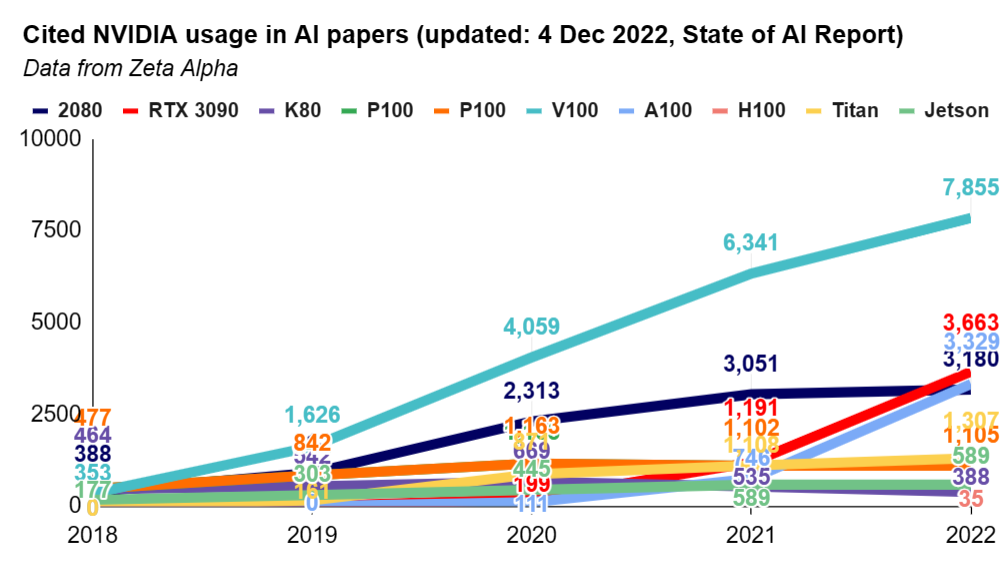

ระยะห่างในตลาดชิปอาจยิ่งกว้างไปอีก เพราะปีที่แล้ว 2022 NVIDIA เพิ่งเปิดตัวจีพียูเซิร์ฟเวอร์รุ่นใหม่ H100 สถาปัตยกรรม Hopper ที่จะเริ่มส่งมอบในปี 2023 และมีประกาศความร่วมมือกับทั้ง Meta และ Microsoft เพื่อสร้างซูเปอร์คอมพิวเตอร์สำหรับเทรน AI รุ่นใหม่ด้วย H100 และในปีนี้เราคงจะได้เห็นการใช้ชิป H100 เพิ่มขึ้นอีกมาก

ที่มา - State of AI, CNBC

Comments

แปลกใจที่ทำไมบ.อื่นถึงไม่มองตลาดนี้ หรือว่ามันเป็นความบังเอิญในช่วงแรกๆ ที่การ์ดเขียวมันสามารถเอาไปใช้งาน AI ได้ดี ค่ายก็เลยต่อยอด หรือพัฒนาไปในทาง AI ต่อ? เพราะเห็นแต่ค่ายเขียวเนี่ยที่ออกชิป AI มาแบบจริงจังในหลายปีที่ผ่านมา

The Dream hacker..

ก็ได้แต่คิดนั่นแหละ ในเมื่อเค้าไม่มีknow howพอจะทำแข่งได้

ค่ายเขียวนอกจากเป็นเจ้าตลาดGPUอยู่แล้ว

ยังเป็นเจ้าแรกที่ทำGPUที่มีการเร่งคำนวณAiอีก

เหมือนนำคนอื่นไปสองก้าว คนที่ตามมาทีหลังก็โดนทิ้งห่าง

ผมว่าก็มองแหละ แต่คงจะเข้าถึงยากล่ะหนึ่ง ตัว nVidia ก็ทำเรื่องนี้มานานมากตั้งแต่สมัย CUDA ทุกคนก็คงมองเห็นมาตั้งแต่ ANN เริ่มใช้งานได้จริง

อีกส่วนที่เห็นคือพวก บ. ที่สามารถออกแบบและผลิตขึ้นมาได้ด้วยตัวเองตอนนี้ก็มักเป็นผู้ให้บริการ Cloud จะเอาของตัวเองมาผลิตขายคนอื่นอย่างค่ายเขียวก็จะดูแปลกๆ สู้เอามาใส่ Cloud ตัวเองขายได้ Margin มากกว่า

การจะลงไปสู้กับ nVidia ก็ไม่ได้เกิดประโยชน์อะไรขึ้นมาในเมื่อตัวเองก็มีพื้นที่ทำมาหากินของตัวเองดีอยู่แล้ว เกิดเข้าไปสู้แล้วทำต้นทุนสู้ไม่ได้ลำบาก ตลาดที่ค่อมกันอยู่ ตราบใดที่ nVidia ยังสามารถรักษาระดับราคาเอาไว้ได้ดี ลูกค้าซื้อไปใช้แล้วคุ้มค่า ก็คงเป็นแบบนี้ต่อไปสักพักใหญ่ๆ

SPICYDOG's Blog

ค่ายอื่นก็พยายามมาตลอดครับ แต่การออกแบบ GPU และ ecosystem ของตัวระบบทั้งหมดให้ทำงานได้ดี เป็นเรื่องที่ท้าทายมากครับ (nVidia มีวิศวกรออกแบบ GPU ราวๆ 5,000 คน) อย่างในฝั่ง comsumer Intel ก็เริ่มมีส่วนแบ่งเพิ่มขึ้นในตลาด GPU ส่วน CPU Intel ที่เคยครองส่วนแบ่งในตลาด data center ยังถูก Epyc กินเข้ามาเรื่อยๆได้ มันก็จะค่อยๆมาแหละครับ แต่ตอนนี้ ของ nVidia เค้าดีจริงครับ

จะลงในหุ้น NVDA ตอนนี้ทันไหม หรือตกขบวนแล้ว :P

WE ARE THE 99%

ตกขบวนไประดับหนึ่งแล้วครับ

Gain ตอนนี้ upside น่าจะน้อยลงเยอะ ความเสี่ยงอาจสูงอยู่ครับถ้าเข้าตอนนี้ เพราะเพิ่งประกาศผลประกอบการ

ช้าไปนิดละครับ หุ้น NVDA เพิ่งลงไป 52-week low ที่ 108 USD เมื่อเดือนตุลา 2022 แล้วก็ค่อยๆกลับขึ้นมาจนมาเด้งทีเดียว 14% เมื่อวันก่อนตอนประกาศผลประกอบการดีกว่าที่คาดครับ ตอนนี้ 235 USD ก็ขึ้นจากต่ำสุดมาแค่ 235% เอง 😛

Pitawat's Blog :: บล็อกผมเองครับ

AMD MI200 สู้ไม่ได้เลยหรอ เห็นตอนเปิดตัวเอามาเทียบกับ A100 อยู่

ตอบในมุมคนที่ทำสายนี้คือ สู้ในเชิง Compute Performance ได้ครับ แต่ library, framework, ecosystem ฝั่ง nvidia ทำมาหลายปีแล้วตั้งแต่ training ยัน production

อยากรู้ว่า บ. ที่ซื้อไป train AI นี่พอจะมีโอกาส train ให้ reverse engineer พวก GPU blueprint แล้วผลิตเองได้ไหมครับ หรือถึงทำได้ก็ติด patent อยู่ดี

ผมเคยถามฝรั่งที่งานConf ว่าทำไมใช้ การ์จอ NVIDIA ในpaperนาย?

คำตอบคือ: paper อื่นๆ ทำตามๆกันมา แล้ว เปิดStackoverflow มันก็มีแต่คนที่ทำก่อนหน้าสำเร็จแล้วด้วยnvidia มันมีคำสั่งให้copyไปวางแล้วrunได้เลย มันก็เลยcopyๆต่อๆกันมา :)

นั่นแหล่ะครับข้อดีของการเป็นเจ้าแรก ดังนั้นแนวคิด startup ปัจจุบัน ก็เลยพยายามทุ่มเงินเพื่อให้เป็นเจ้าแรกที่ครองตลาดเบ็ดเสร็จ หลังจากนั้นก็เก็บเกี่ยวผลประโยชน์จากธรรมชาติของมนุษย์ที่จะเลือกสินค้าที่คุ้นเคยมากกว่าสินค้าที่ไม่รู้จัก

จะสร้าง Algorithm โดยใช้แนวคิดแบบ Crypto ได้มั้ยนะ คนขุดก็ได้เงิน คนไช้ก็จ่ายค่าพลังประมวลผล

ถ้าเมืองไทยนำเข้ามา หน่วยงานเกี่ยวข้องที่สนามบินจะตรวจสอบใช่มั้ยครับ เพราะอเมริกาต้องมีข้อบังคับ กับไทย ใช่มั้ยครับ บางอย่างอเมริกามีห้ามส่งรุ่นใหม่ถึงจีน แต่รุ่นเก่า หรือสเปกความสามารถต่ำ ส่งได้

สั่งกับ Vendor ในไทยก็ได้นะครับ