วันนี้สื่อไอทีเมืองนอกหลายราย เริ่มลงผลทดสอบ GeForce RTX 3090 Founder Edition การ์ดจอ Ampere ตัวแรงที่สุดของ NVIDIA ที่มีราคาสูงถึงประมาณสองเท่าของ RTX 3080 (สเปกคร่าวๆ คือ CUDA cores ถึง 10496 แกน และวีแรม GDDR6X ขนาด 24GB)

แม้ผลทดสอบที่ได้จะไม่ได้เพิ่มเป็นสองเท่าตามราคา แต่ GeForce RTX 3090 ก็ครองตำแหน่งเจ้าแห่งการ์ดจอเล่นเกมในตอนนี้ไปเรียบร้อย

สื่อหลายสำนักพูดตรงกันว่า GeForce RTX 3090 ถือเป็นการ์ดจอตระกูล Titan รุ่นใหม่ แม้ไม่มีคำว่า Titan ในชื่อรุ่นก็ตาม แต่เพราะเป็นการ์ดจอแสดงพลังขั้นสุดของ NVIDIA ในเจ็นนี้ โดยออกแบบมาสำหรับผู้ที่ต้องการการ์ดจอรุ่นที่แรงที่สุดโดยไม่เกี่ยงราคา และต้องการเล่นเกมแบบ 4K พร้อม ray-tracing ได้แบบเต็มที่ ซึ่งการ์ดจอรุ่นนี้ก็ทำได้แบบ 60fps แล้วในหลายๆ เกม

เห็นผลชัดเจนเมื่อเล่นที่ 4K

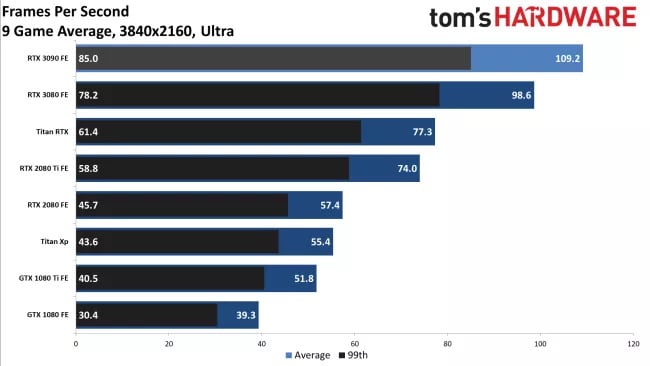

Tom’s Hardware ระบุว่าประสิทธิภาพของ RTX 3090 ชนะ 3080 ไปประมาณ 10-15% ในการเล่นเกมบนความละเอียด 4K แต่ไม่ถึง 10% บนการเล่นเกมแบบ 1440p จึงเห็นได้ชัดว่า RTX 3090 ถูกสร้างมาเพื่อโชว์พลังการเล่นเกมแบบ 4K หรือละเอียดกว่านั้น เพราะเป็นความละเอียดในระดับที่ใช้ประโยชน์จากวีแรมขนาดใหญ่ถึง 24GB ได้อย่างเต็มที่ และเป็นคำอธิบายว่าทำไมการเล่นเกมแบบ 1440p จึงไม่เห็นความแตกต่างมากนัก

เฟรมเรต เฉลี่ย 9 เกม บนความละเอียด 4K จาก Tom’s Hardware

เฟรมเรต เฉลี่ย 9 เกม บนความละเอียด 4K จาก Tom’s Hardware

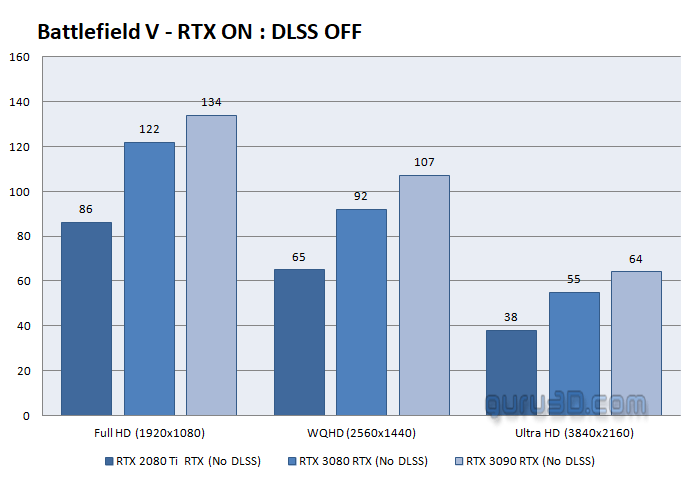

ส่วนเว็บ guru3d.com ทดสอบการเล่นเกม Battlefield V แบบเปิด ray-tracing ที่ความละเอียด 4K พบว่า GeForce RTX 3090 เป็นการ์ดจอใบเดียวเท่านั้นที่สามารถทำเฟรมเรตเฉลี่ยได้ถึง 60 เฟรมต่อวินาที ในขณะที่ระดับ RTX 3080 ทำได้ 55 เฟรมต่อวินาที และ RTX 2080 Ti ทำได้เพียง 38 เฟรมต่อวินาที

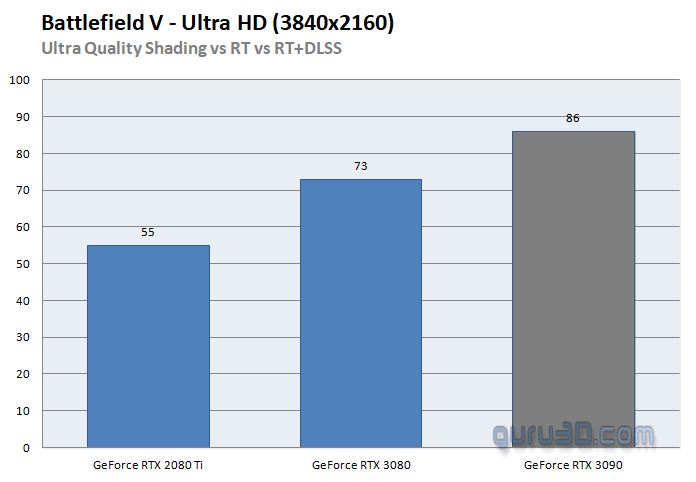

ปัญหาเฟรมเรตตก สามารถแก้ได้ด้วยการเปิด DLSS (เทคโนโลยีอัพสเกลภาพด้วย deep learning ของ NVIDIA) ซึ่งได้เฟรมเรตอยู่ที่ 55, 73 และ 86 เฟรมต่อวินาที (2080 Ti, 3080, 3090 ตามลำดับ)

Battlefield V แบบ 4K เปิด RT ไม่เปิด DLSS

Battlefield V แบบ 4K เปิด RT ไม่เปิด DLSS

Battlefield V แบบ 4k เปิด RT+DLSS

Battlefield V แบบ 4k เปิด RT+DLSS

ยังพิชิตโหมด Can It Run Crysis? ที่ 60fps ไม่ได้

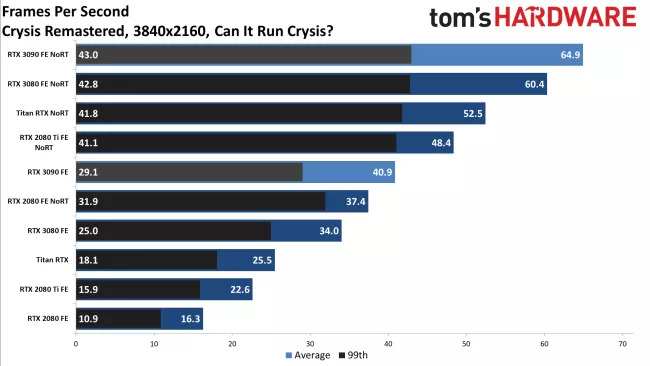

หาก GeForce RTX 3090 มีปัญหาอยู่บ้าง ก็คงเป็นการเล่นเกม Crysis: Rematered ในโหมด Can it run Crysis? ที่เว็บไซต์ Tom’s Hardware ลองทดสอบบนความละเอียดแบบ 4K แบบเปิด ray-tracing พบว่า RTX 3090 ยังทำเฟรมเรตได้เพียง 41 เฟรมต่อวินาทีเท่านั้น (เกมยังไม่รองรับ DLSS ทำให้ไม่มีตัวช่วย) แต่หากปิด ray-tracing ก็สามารถทำเฟรมเรตได้เฉลี่ย 64.9 เฟรมต่อวินาที

ผลทดสอบ Crysis:Remastered จาก Tom’s Hardware

ผลทดสอบ Crysis:Remastered จาก Tom’s Hardware

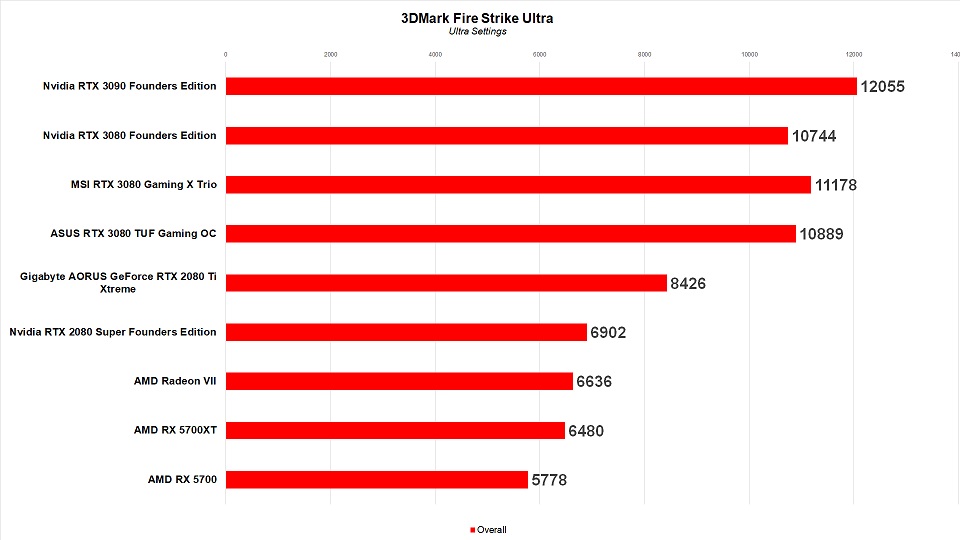

คะแนนจากการทดสอบแบบสังเคราะห์เช่น 3DMark Fire Strike Ultra ที่ IGN ทำการทดสอบ ทำได้ถึง 12055 คะแนน เทียบกับ RTX 3080 ที่ 10744 คะแนน เพิ่มขึ้นประมาณ 12.2%% และถ้าเทียบกับ RTX 2080 Ti ที่ได้ 8426 คะแนน ก็เพิ่มขึ้นมาถึงเกือบ 4000 คะแนน

ผลทดสอบจาก IGN

ผลทดสอบจาก IGN

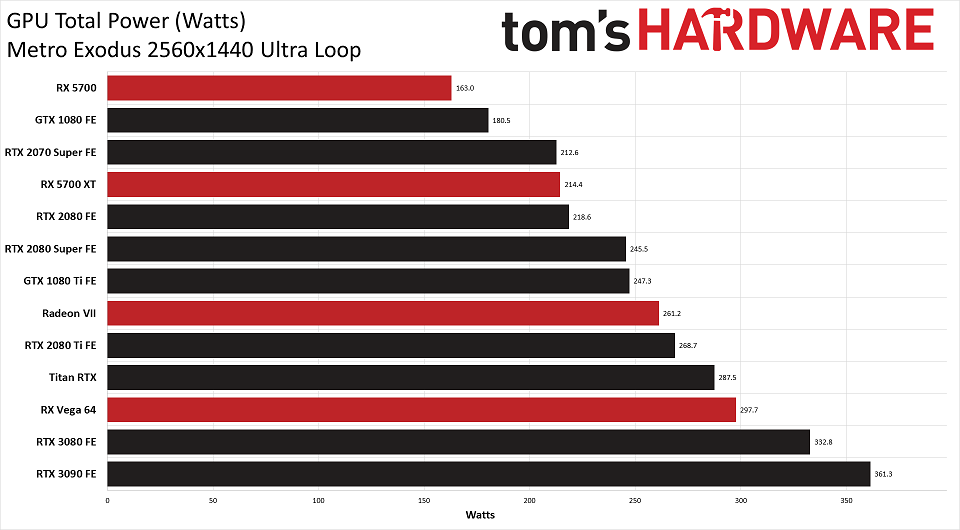

ไม่ร้อนมาก แต่กินไฟมาก

ในด้านพลังงานและความร้อน จากการทดสอบพบว่า RTX 3090 ระบายความร้อนได้ดีเยี่ยม ในการทดสอบเล่นเกม Metro Exodus บนความละเอียด 1440p อุณหภูมิเฉลี่ยอยู่ที่ 64.6 องศาสเซลเซียสเท่านั้น แต่ในด้านการใช้พลังงาน RTX 3090 กินไฟมากพอสมควร โดยต้องใช้ไฟถึง 361.3 วัตต์ในการทดสอบ Metro Exodus เทียบกับ Titan RTX ในรุ่นก่อน ที่ใช้ไฟ 287.5 วัตต์

ผลทดสอบด้านพลังงานจาก Tom’s Hardware

ผลทดสอบด้านพลังงานจาก Tom’s Hardware

พอเล่นเกม 8K ได้เป็นบางเกม

สำหรับการเล่นเกมที่ความละเอียดสูงระดับ 8K เว็บ Tehcspot ลองทดสอบการเล่นเกมแบบ 8K พบว่าพอจะรองรับการเล่นเกมแบบ 8K ได้บ้าง แต่ยังมีเพียงเกม Doom: Eternal เท่านั้น ที่เล่นได้บนความละเอียด 8K จริงๆ ที่เฟรมเรต 60fps ส่วนเกม Control ยังต้องใช้ DLSS ในการอัพสเกลจาก 1440p เพื่อให้ได้เฟรมเรตที่ 60fps อยู่ (และได้เพียง 5fps เมื่อไม่ใช้ DLSS เพราะต้องเรนเดอร์ 8K เต็มความละเอียด)

สรุป

NVIDIA Geforce RTX 3090 น่าจะเป็นการ์ดจอที่แรงที่สุดในตลาดปัจจุบัน แต่มีข้อเสียที่ขนาดใหญ่ ราคาแพง และค่อนข้างกินไฟ แต่ถ้าคุณเป็นผู้เล่นที่ไม่เกี่ยงเรื่องเงิน และต้องการการ์ดจอที่ดีที่สุดสำหรับการเล่นเกมแบบ 4K เปิด ray-tracing แบบจัดเต็ม ณ ตอนนี้ ไม่มีการ์ดจอตัวไหนเอาชนะ RTX 3090 ได้

ถ้าคุณมีเงินเหลือเฟือ และคิดว่าประสิทธิภาพที่มากขึ้นประมาณ 15% จาก RTX 3080 และการรองรับการเล่นเกมความละเอียดสูงในอนาคต คุ้มแล้วสำหรับราคาประมาณสองเท่า RTX 3090 ก็น่าจะเป็นพี่ใหญ่บิ๊กเบิ้มที่เหมาะกับคุณ

ที่มา - Tom’s Hardware, guru3d, TechSpot

Comments

ไม่มีใครลอง

flight sim 4k ปรับสุด

เลยหรือนี่

เหมือนมีคนลองแล้วไม่ถึง60fps น่าจะมีปัญหาที่เกม optimizeมาไม่ดี

เห็นชัดๆว่าวางราคา 3090 ไม่สมเหตุสมผลกับการใช้เล่นเกม เมื่อเทียบกับประสิทธิภาพและราคาที่จ่ายไป

แต่กับคนที่เอา geforce ไปทำงาน เหมือนซื้อ quadro ที่ไม่ใช่ quadro

แค่ได้ vram 24G สาย nn ai ก็น้ำตาไหลพี้อมจ่ายแล้วคับ ไม่ต้องไป quadro ที่ราคาไปไกลกว่านี้เยอะ

คนทำ ai พูดงี้ทุกคนเลยจริงๆ

titan

ถ้าทำงานออกแบบ 3D ใช้การ์ดจอ Quadro ดีกว่าพวก GTX/RTX ใช่มั้ย

ใช้ครับ

ไม่ใช่ กับ 3dsmax ครับ

มันขึ้นอยู่กับโปรแกรมด้วยครับ ถ้าอย่าง solidworks ใช้ Quadro ดีกว่าครับ

หลายๆรีวิว รายงานตรงกันว่า 3090 ใช้ไดรเวอร์คนละตัวกับ quadro

บางฟีเจอร์ที่ optimize สำหรับ professional โดยเฉพาะโปรแกรมเกี่ยวกับงาน CAD เลยไม่มี

Benchmark ในงานกลุ่มนี้จะแพ้ RTX Titan ตัวก่อน

คิดว่าคงออก quadro/Titan ampere มาอีกทีแหละ

ใช้ 3080 2 อัน ไม่คุ้มกว่าหรอ

ถึงรองรับ ก็ไม่ใช่ทุกเกมที่จะรองรับ

อ่อ เข้าใจแล้วครับ

ที่ลอง scaling 100 ได้ 60 นี่หมายถึง3080หรือ3090ครับ

ถ้าอยากได้ความหวังอันเลื่อนลอย ... รอแพทช์ DX12 ครับ อาจจะดีกขึ้น

"3DMark Fire Strike Ultra ที่ IGN ทำการทดสอบ ทำได้ถึง 12055 คะแนน เทียบกับ RTX 3080 ที่ 10744 คะแนน เพิ่มขึ้นประมาณ 20%"

เพิ่มขึ้นประมาณ12%นะครับ ถ้าเป๊ะๆหน่อยก็12.2%

ไม่ได้ตามข่าวการ์ดจอมานาน ภาพคงไม่แย่แบบสมัยก่อนแล้วมั้ง เฟรมเรทสูงแต่แบน สุดท้ายต้องย้ายไป ATI

แบนยังไงครับ

มีภาพแบนด้วยหรอคะ เคยได้ยินแต่ATIภาพสดกว่า

น่าจะนานมากเพราะเอ่ยถึง ATI แถมเจอศัพท์แบน น่าจะนานขึ้นไปอีก

ถ้าจำไม่ผิด มันไม่นานหรอกครับ ไม่ถึงหลัก 5ปีด้วยซ้ำ

วลี เฟรมสูงแต่ภาพแบน ของยูสหนึ่งใน overclockzone ที่พยายามเทียบเทคเจอร์พื้นหญ้าของเกมฟุตบอลเมื่อใช้การ์ดจอ geforce

Run 4K ระหว่างเปิดกับปิด AA จะเห็นความแตกต่างไหม

ตอนนี้มีประเด็นว่า 3080 ทำเครื่อง crash บ่อยขณะเล่นเกมด้วย เป็นเกือบทุกยี่ห้อเลย

รายงานบอกว่า เพราะแต่ละยี่ห้อทำการโอเวอร์คล็อกมาเลยแต่แรก ถ้าดาวน์คล็อกลงไปสัก 100 MHz ปัญหาก็ลดลง

แต่มีสำนักนึงบอกว่าเพราะใช้คาพาซิเตอร์ชนิดนึงเยอะเกิน (POSCAPS, ผมรู้ชื่อเต็ม แต่ไม่รู้ว่าลึกๆ ต่างกันไง (วะ)) ในขณะที่รุ่น FE ไม่ได้ใช้ชนิดนี้เยอะขนาดนี้

ทาง EVGA เองก็ดูเหมือนจะแบ่งรับแบ่งสู้กับเคสนี้ (จริงๆ ก็คือยอมรับแหละ) บอกว่านี่พยายามลดจำนวน POSCAPS แล้วเปลี่ยนไปใช้ MLCC แทนแล้วนะ

คือเป็น capacitor ไว้กรองไฟเวลาโหลดกระชาก ตัวที่เห็นชัดมีหกตัวหลังชิป ตามพิมพ์เขียว reference จะใช้แบบเซรามิค (MLCC) ตัวเล็กๆสิบตัวเรียงตรงกลาง แล้วใช้ตัว SP-CAP (หรือที่ในรายงานเรียก POSCAP) ห้าตัวเรียงรอบๆ

แต่บางเจ้าตัดเซรามิคตรงกลางที่แพงกว่าออกแล้วแทนที่ด้วย SP-CAP แทน รายงานเลยสันนิษฐานว่าเพราะโหลด 2000Mhz มันเกิน clock มาตรฐาน มันเลยค่อนข้าง sensitive และแครชง่ายในกรณีที่ใช้ capacitor คุณภาพไม่ดี

เอาจริงยังฟันธงไม่ได้ เพราะบอร์ด AIB แต่ละเจ้าก็ใช้ SP-CAP คนละระดับคุณภาพกัน (ถึงจะสีดำเหมือนๆกัน) แล้วมีรายงานว่าบอร์ดที่ใช้ MLCC ก็มีแครชเหมือนกัน

ขอบคุณสำหรับความรู้ครับ

ถ้าใช้ MLCC แล้วยังแครชอยู่ก็อาการหนักกว่าที่คิดอ่ะดิ

อีกคำถาม มันแพงกว่ากันมากเหรอครับ?

"เป็นเกือบทุกยี่ห้อเลย"

ถ้าFounderไม่เป็น..ก็ชัด ว่าเป็นที่ใคร

แต่ด้วยราคาFounderขนาดนี้

อยากทราบเหตุผลที่ต้องเสี่ยงไปซื้อยี่ห้ออื่นว่าสิ่งที่ได้เพิ่มมามันคุ้ม?

หลายประเทศดิสตรี้ไม่นำเข้าฟาวเดอร์ครับ (เช่นญี่ปุ่น)

และต่อให้เป็น AIB เอง บอร์ดที่ทำขายต้องโดน approve ก่อนฮะ (NVidia Greenlight)

ดังนั้นจะบอกว่ายี่ห้ออื่นทำมาเองเลยไม่เกี่ยวกับ NVidia ก้ไม่ได้ 100% หรอกครับ

ตัว reference design ดันออกแบบมาแบบให้ใช้ได้ทั้งสองแบบ สังเกตจากตรงข้างใต้ POSCAP มีแพดสำหรับ MLCC ด้วย เขาก็เลยใช้ตัวถูกกันน่ะสิครับ

ผมเดาว่า ... ตัว boost table ดันถูกแก้ให้ดันคล็อกไปสูงขึ้นหลังจาก reference design ปิดแล้วน่ะครับ

อยากให้มี ชิปรุ่นใหม่เกิดขึ้นมา Nvidia จะได้เลิกกัก สักที ราคาเท่านี้ ถ้าทำได้แค่นี้ ขอใช้ ออนบอร์ดต่อดีกว่า

ถ้าราคารอบนี้ยังไม่ถูกใจ คงต้องรอ Intel Xe ล่ะครับ

ทำไมถึงดัน ray tracing จัง

อ่านทฤษฎีดูรู้สึกว่า overhead มันเยอะมาก

สู้กำหนด environment ของแต่ละ Mesh ไปเลยเปลือง resource น้อยกว่า

ray tracing มันสามารถสร้าง output ที่สมจริงกว่า rasterizer ทำได้น่ะครับ

แต่คิดว่าหลายคนก็คงแยกไม่ออกในหลาย ๆ กรณี และถึงแยกออกบางทีก็ไม่สนใจด้วย เพราะว่าเทคนิค rasterization มันดีขึ้นมากครับ

อย่างตอนนี้ทีวีก็เริ่มเอา UE มาใช้กันแล้ว (และคิดว่าไม่ได้ใช้ RT) สาเหตุนึงก็เพราะ Rasterization มันดีขึ้นจนเราเริ่มแยกความจริงปลอม ๆ ไม่ออกกันละ