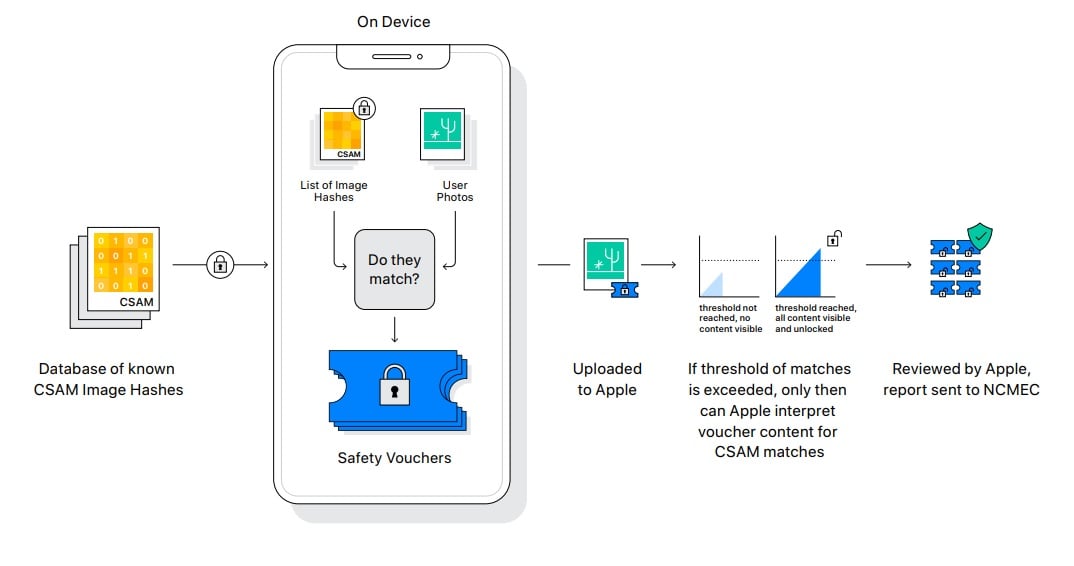

เดือนที่แล้ว แอปเปิลประกาศแนวทางสแกนภาพโป๊เด็ก หรือที่เรียกว่า child sexual abuse material - CSAM สร้างเสียงวิจารณ์ต่อบริษัทอย่างหนักในแง่ความเป็นส่วนตัว

ล่าสุดแอปเปิลประกาศเลื่อนการใช้งาน CSAM ไปก่อน แต่ยังไม่ระบุกรอบเวลาที่ชัดเจน โดยให้เหตุผลว่าต้องการเวลาเพิ่มเติมเพื่อรับฟังความเห็น และพัฒนาฟีเจอร์ให้ดีขึ้นก่อนใช้งานจริง

ที่มา - 9to5mac

Get latest news from Blognone

Follow @twitterapi

Comments

ผมว่าควรจะยกเลิกมากกว่าเลื่อนออกไปนะ เพราะมันสร้างปัญหามากกว่าป้องกันปัญหาเสียอีก

ความล้มเหลว คือจุดเริ่มต้นสู่ความหายนะ มีผลกระทบมากกว่าแค่เสียเงิน เวลา อนาคต และทรัพยากรที่เสียไป - จงอย่าล้มเหลว

จะแสกนก็แสกนบน iCloud ไม่ใช่มาใช้พลังมือถือแสกน

รอให้คนลืมก่อนค่อยแอบใส่สินะ

เลื่อนน่ะดีแล้ว ถ้าไม่เลื่อน เละกว่าเดิมแน่นอน

แค่มนุษย์คนนึงที่อยากรู้เกี่ยวกับวงการไอที

เฮ้ย เราต้องทำในสิ่งที่ถูกต้อง คนส่วนมากไม่รู้หรอกว่าตัวเองต้องการอะไร

ไม่เห็นต้องเลื่อนเลยครับ ทำตอนนี้ได้เลยก็ยังได้แค่สแกนบน cloud ให้เหมือนชาวบ้านเขาน่ะครับ ไม่ต้องพยายามจะ Think different มันทุกเรื่องได้ไหมครับ

จุดเริ่มต้นของการรุกล้ำข้อมูลภายในเครื่อง ถ้าผ่านมาได้ครั้งต่อไปมันก็รุกล้ำเข้ามาได้ไม่ยากละ

ขอเปิดตัว iPhone รุ่นใหม่ก่อน เดี๋ยวปลายปีค่อยแอบใส่มาใหม่

เลื่อนไปเปิดตัวพร้อม iPhone13

คราวนี้ apple ยอมถอยถึงจะไม่สุดซอยก็เถอะ

ด่าคนอื่นว่าเอาข้อมูลลูกค้าไปหากิน แต่ตัวเองใช้เครื่องและพลังงานลูกค้า สแกนภาพ ด้วยเหตุผลว่า ลูกค้าทุกคนอาจเป็นอาชญากร ไม่ทุเรศกว่าหรือ?

คนที่เสนอแนวคิดนี้ควรจะลาออกนะ

เห็นบางคนเดาว่าเพื่อแลกกับการที่ไม่ต้องโดนสอบเรื่องผูกขาด

ผมว่ามีความเป็นไปได้เหมือนกับที่รัฐบีบให้ใส่ไว้ก่อนเผื่อให้สแกนอย่างอื่นต่อไป

ที่คิดกันคือเพื่อลดแรงกดดันจากรัฐครับ ไม่น่าเป็นระดับบุคคล

+1

เลื่อนหรือทำให้แนบเนียนแอบอิงให้จับไม่ได้มากกว่าเดิม ?

คงกะเอามาเป็นจุดขายพร้อมเปิดตัว iPhone 13

แต่กระแสดันตีกลับ กลัวรุ่นใหม่จะขายไม่ออก เลยยอมถอยไปก่อน

ยอมถอยด้วย

แอปเปิ้ลบอกจะไม่ยอมสแกนเนื้อหาอย่างอื่นเพิ่ม แม้จะโดนรัฐบาลกดดัน

แต่ที่ระบบนี้เกิดมา เชื่อว่าหลักๆมาจากแรงกดดันของรัฐบาล

hmmm