กูเกิลจับมือกับบริษัท Sourcegraph ผู้พัฒนา AI ช่วยเขียนโค้ดชื่อ Cody ทดลองนำโมเดล Gemini 1.5 ที่รองรับอินพุตขนาดยาว 1 ล้านโทเคน ว่าช่วยให้คุณภาพของคำตอบดีขึ้นอย่างไร

Cody เป็นการนำ AI มาอ่านโค้ดภายในขององค์กรลูกค้า เพื่อช่วยให้ค้นหาและแนะนำการเขียนโค้ดใหม่ ใช้ร่วมกับ IDE ยอดนิยมทั้ง Visual Studio และตระกูล JetBrains ได้ โมเดลภาษาที่ Cody เลือกใช้งานเป็นโมเดลยอดนิยมหลายตัวในตลาด เช่น Claude 3/3.5, GPT-4o, Gemini, Mixtral (ลูกค้าเลือกเองโมเดลได้) โดยโมเดลที่ใช้งานในระดับโปรดักชันมีขนาด context window ยาว 10,000 โทเคน (10k)

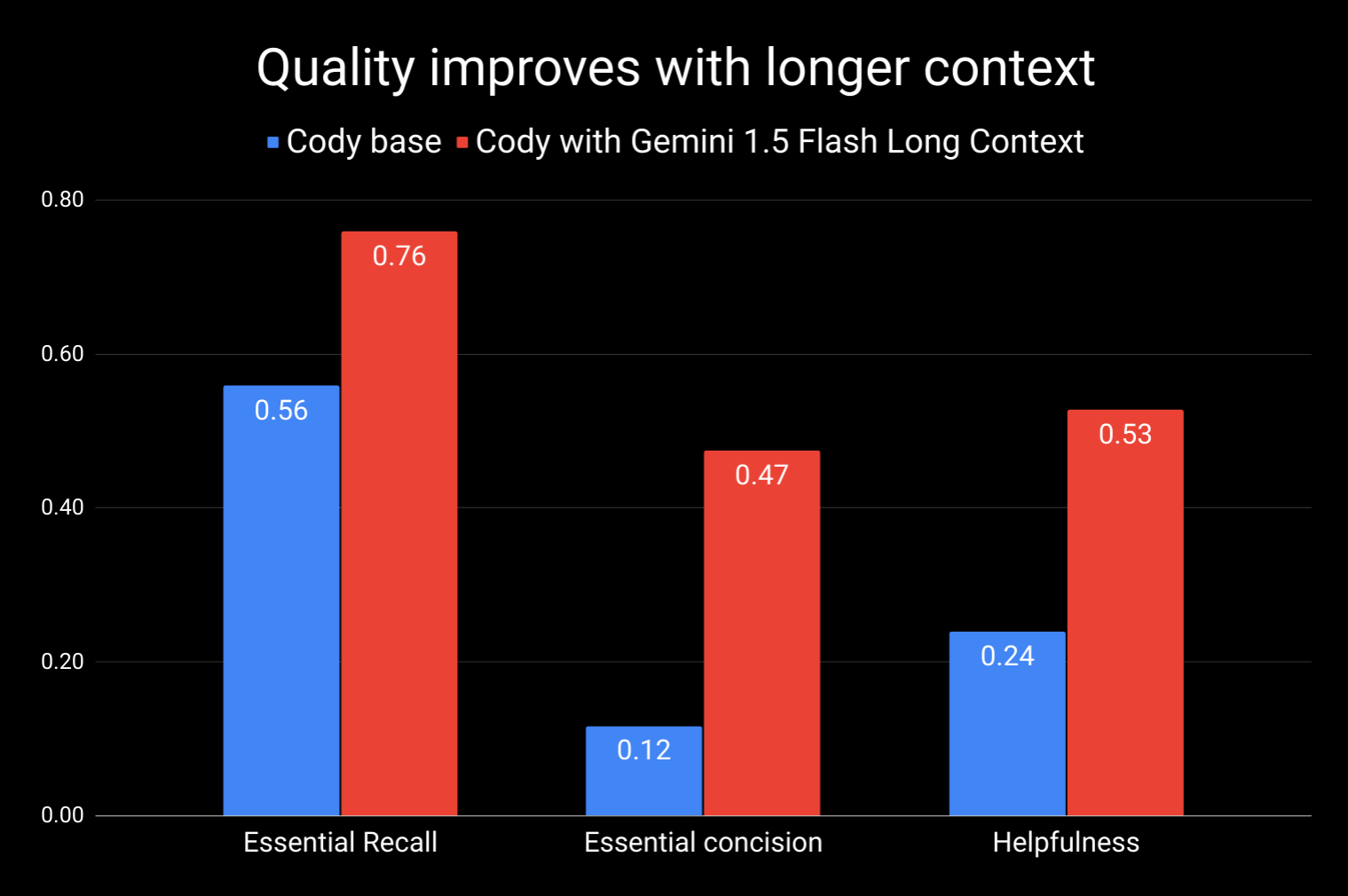

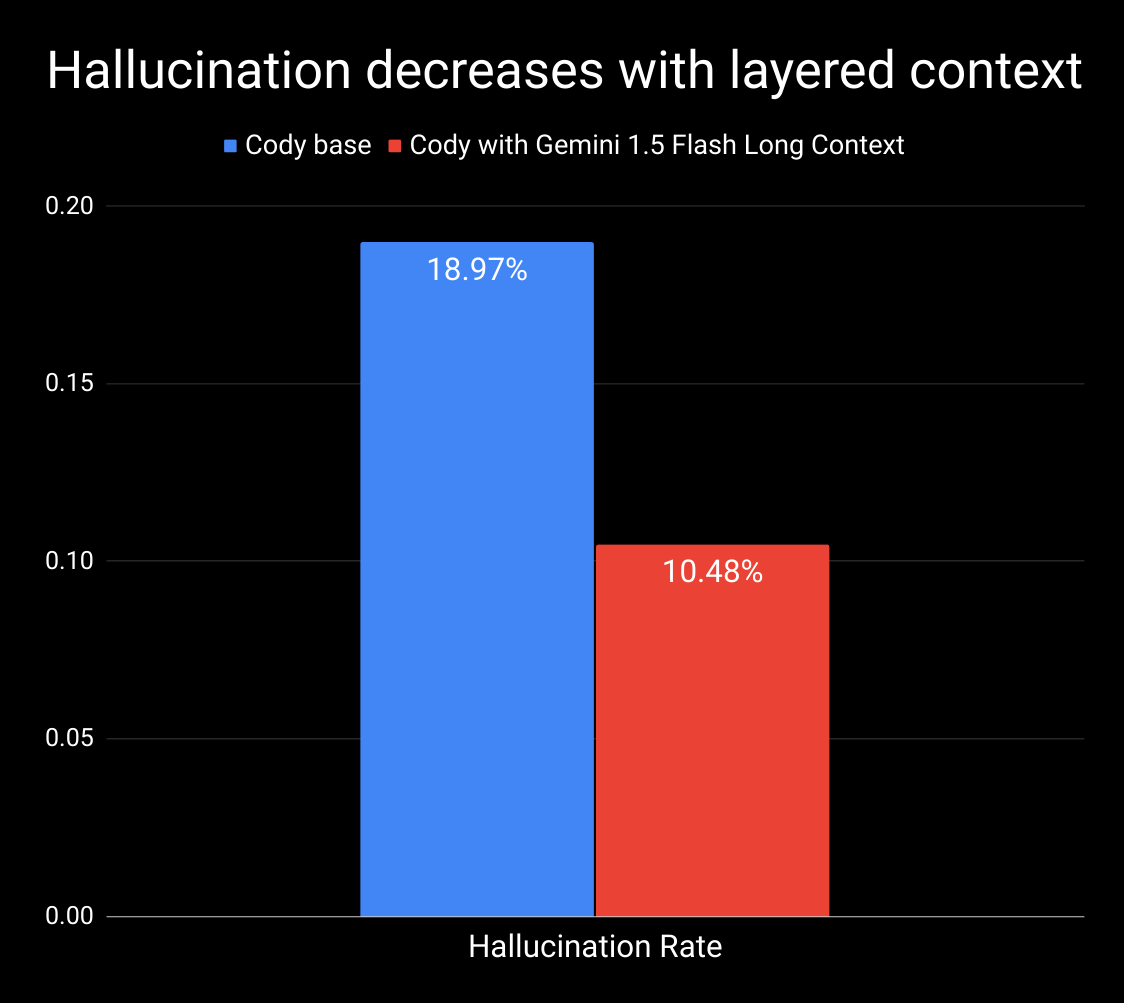

Sourcegraph ทดลองนำ Gemini 1.5 Flash ขนาด 1M context window สลับมาใช้งานแทน แล้วเปรียบเทียบผลลัพธ์ใน 4 มิติ ได้แก่ Essential Recall, Essential Concision, Helpfulness, Hallucination

คำตอบที่ได้จากการใช้โมเดลที่รองรับอินพุตยาวขึ้น พบว่าได้คำตอบผลลัพธ์ที่ละเอียด ครบถ้วนกว่าเดิม (more comprehensive, authoritative answer) ลดการเสริมเนื้อหาที่ไม่สำคัญหรือไม่เกี่ยวข้องเข้ามาในคำตอบ (less noise and irrelevant filler) เพราะโมเดลไม่จำเป็นต้องเพิ่มข้อมูลอื่นๆ มาเสริมคำตอบที่ตรงเป้าอยู่แล้ว (ดูตัวอย่างคำถามและคำตอบได้จากที่มา)

ข้อเสียของการใช้โมเดลที่อินพุตยาว 1M คือเพิ่มระยะเวลาในการรอคำตอบโทเคนแรก (time to first token) อย่างชัดเจน โดยระยะเวลาแปรผันตรงเป็นเชิงเส้นกับความยาวของอินพุตที่ใส่เข้าไป ซึ่ง Sourcegraph บอกว่าแก้ปัญหาด้วยการ prefetch ข้อมูลบางส่วนไปก่อนการรันโมเดล แล้วแคชเก็บไว้ ช่วยลดระยะเวลารอจาก 30-40 วินาทีลงมาเหลือ 5 วินาทีได้

ที่มา - Sourcegraph, Google Cloud