มีข่าวคราวของชิปจีพียูตระกูล "Polaris" ที่จะเป็นการ์ดรุ่น Radeon 400 ที่กำลังจะเปิดตัวในปีนี้ ประมาณการณ์กลางปี 2016 ด้วยคุณสมบัติและลูกเล่นชวนตื่นใจดีครับ ขอสรุปเป็นบุลเล็ตตามภาพพรีเซนเทชั่นที่เผยแพร่จากต้นทาง

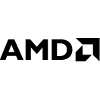

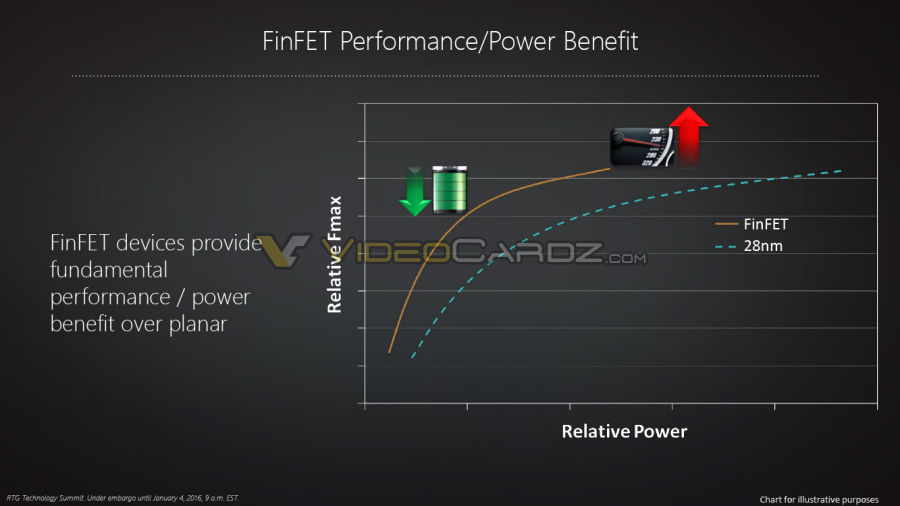

- GPU ชื่อ "Polaris" นี้นับเป็นชิป GCN (Graphics CoreNext Compute Unit) เวอร์ชั่นที่ 4 ต่อจาก Fiji และ Tonga ในปี 2015 เปลี่ยนขนาดการผลิตจาก 28nm เป็น 14nm FinFET เล็กลงกว่าเดิมเกือบหนึ่งในสี่

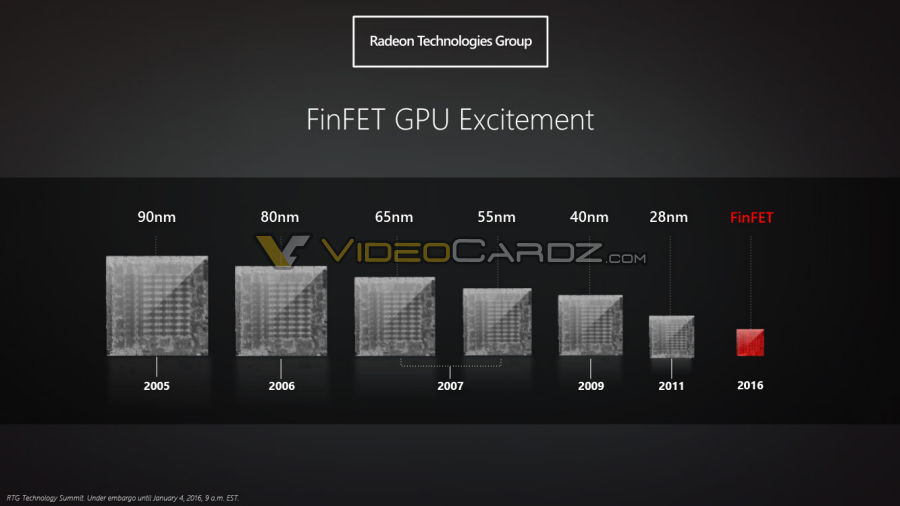

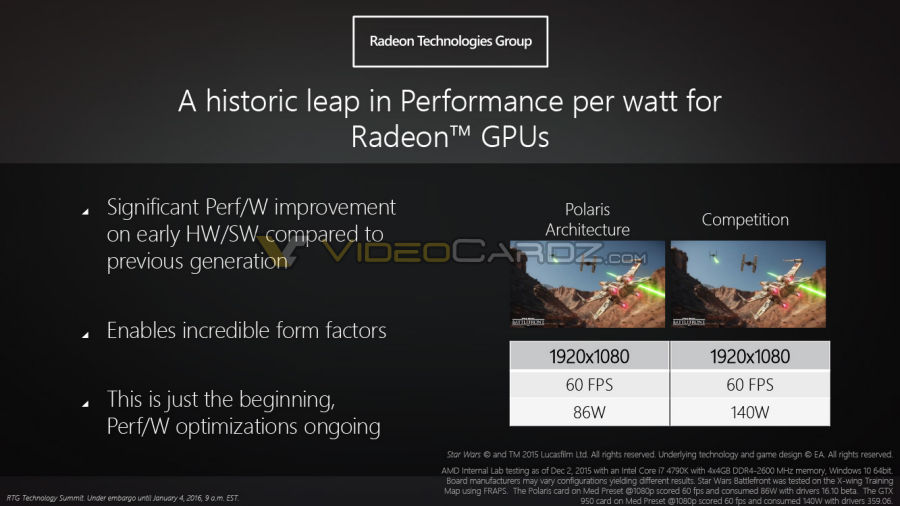

- ซึ่งบอกว่าสัดส่วนของประสิทธิภาพต่อการใช้พลังงานจะดีขึ้นแบบก้าวกระโดด ("historic leap in performance/Watt") ในเกมเดียวกัน ที่ความละเอียด 1080p 60FPS ใช้พลังงานเพียง 86 วัตต์

- รองรับการฝังแรมบนชิป เวอร์ชั่นสอง (High-Bandwidth-Memory 2; HBM2)

- รองรับ HDMI 2.0a, DisplayPort 1.3 เข้าและถอดรหัส h.265 4K ได้ในตัว

- AMD ตั้งเป้าว่าจะทำให้กลุ่มแล็ปท็อปและเครื่องขนาดบางให้มีประสิทธิภาพเทียบเท่าเครื่องเกมคอนโซล

ที่มา - VideoCardz

Get latest news from Blognone

Follow @twitterapi

Comments

สรุปว่าใช้ FinFET ของซัมซุง(14nm) หรือ TSMC(16nm)?

น่าจะ TSMC นะครับ

ปล. เพิ่งจะสั่งคอมไป ดีที่ยังไม่ซื้อการ์ดจอมาด้วย เพราะยังไม่อยากได้คอมที่ทำได้ทุกอย่าง แต่ไม่โดดเด่นซักด้านครับ

ที่สงสัยเพราะก่อนหน้านี้มีข่าวว่าจะจ้างซัมซุงผลิตน่ะครับ แต่ในข่าวเป็น 16nm ซึ่ง TSMC ผลิตอยู่

ถ้าเป็นที่ VideoCardz ระบุเอาไว้คือ

"Polaris is new codename for 14nm FinFET architecture"

ถ้าข้อมูลถูกต้องก็น่าจะซัมซุงนะยกเว้น TSMC จะข้ามมา 14nm เลย

ส่วนใหญ่จะระบุเอาไว้แค่ 14/16nm FinFET แค่นั้นยังไม่ระบุโรงงานจริงๆ ที่จะผลิตให้ครับ

Anand ลงไว้ว่า ที่ไม่ระบุว่าเป็นเจ้าไหน เพราะว่าจะกระจายไปผลิตตามโรงงานหลาย ๆ แห่ง RTG ยืนยันว่าจะผลิตที่ TSMC เหมือนเดิมด้วย และจะผลิตที่ GF ด้วยอีกเจ้า (ใช้เทคโนโลยีของซัมซุง)

จ้างทั้ง GF+ซัมซุง , TSMC , Hynix , UMC

ช่วยกันผลิตโดยแต่โรงงานก็มีหน้าที่ผลิตแต่ละโมดูลแยกกันไปเหมือนหั่นแยกชิป Fiji ออกเป็นส่วนๆ แบบนี้ใช่หรือเปล่าครับ แฮ่ๆ

ไม่ใช่ครับ :-)

แต่ละโรงงานจะได้พิมพ์เขียวของชิพทั้งตัวไป โดยที่แต่ละโรงงานก็จะไม่เหมือนกัน (ถ้าผมจำไม่ผิด วิธีการผลิตที่แตกต่างกันจะใช้แม่พิมพ์ที่ไม่เหมือนกันครับ)

อารมณ์เหมือนตัว Apple A9 ที่ผลิตสองโรงงาน (TSMC, ซัมซุง) นั่นล่ะครับ

น่าเสียดายเหมือนกันนะ ไหนๆ ก็มี Interposer ที่พร้อมผลิตจำนวนมากๆ ได้แล้ว

ก็น่าจะแยกส่วน Shader Engine ออกเป็นซัก 4 ชิป (GF และซัมซุงรับไป)

ส่วนที่เหลืออื่นๆ ไม่รวมแรมก็จับไปยัด ชิปอีก 1 ตัวให้หมด(TSMC รับงาน)ก็น่าจะทำได้ไม่ยากเท่าไหร่

ผลดีคือ Yield rates ไม่น่าจะหนีพวก SOC มือถือเท่าไหร่+แรงหูตูบเห็นๆ

แถมยังได้แอบทดสอบการใช้ Interposer สำหรับ SOC ที่มีความซํบซ้อนสูงมากๆ

อย่างเช่น APU สำหรับ HPC ในอนาคตไปด้วยในตัวครับ

มากกว่าครึ่ง?

เดี๋ยวนะครับ ครึ่งของ 28nm มันคือ 14nm แต่ในข่าวมันเป็น 16nm มันก็คือเกือบครึ่งหรือเปล่าครับ ขอตั้งสติแป๊บหนึ่งนะครับ

ที่ผมเข้าใจขนาด 16x16 เล็กกว่า 28x28 มากกว่าครึ่งครับ

Ton-Or

เอ ผมว่า 16nm มันไม่น่าใช่ ขนาดพื้นที่จัตุรัส แบบนั้นนะ

ผมเข้าใจว่าเป็นขนาดของ ทรานซิสเตอร์ ซึ่งเวลาวางมันวางอัดๆ ไปก็ต้องมีทั้งด้านกว้างด้านยาวหรือเปล่าครับ

มี ทรานซิสเตอร์ 100 ตัวแบบ 10x10

เทคโนโลยี 28 nm ก็ 280x280

อะไรแบบนี้เปล่าครับ

ผมก็สงสัยน่ะหน่วย nm นี่คือวัดแบบไหน วัดระยะห่างด้านเดียว หรือ ที่บอกๆ นี่คือคิดเป็น พื้นที่มาอยู่แล้ว

Ton-Or

ขอความรู้ด้วยคนครับ ;__;

คือผมก็ไม่แน่ใจนะ ตอนแรกๆ เข้าใจว่า เป็นความกว้างของ ลายทองแดง , หาๆ ดูตะกี้ มันบอกว่าคือ ความยาวของ gate ... รอข้อมูล จากผู้รู้ด้วย อีกคนแล้วกัน :D

nm มันคือขนาดของทรานซิสเตอร์ที่ทำจากซิลิคอนหนึ่งอัน ชิปหนึ่งตัวเช่น cpu หรือ gpu หนึ่งอันมีทรานซิสเตอร์เป็นพันๆ ล้านอันครับจะแตะหมื่นล้านตัวอยู่แล้ว

ขนาดของชิปทั้งตัวก็วัดเป็นพื้นที่ตาราง มม. ปกติครับ nm นี่เล็กกว่า mm เป็นล้านเท่านะครับ แล้วขนาดตาราง nm ตาไม่เห็นครับ เล็กกว่าไวรัสครับ นอกจากนี้ชิปตัวนึงมีหลายชั้นครับ ดังนั้นขนาดทรานซิสเตอร์ไม่ได้แปรผันอะไรกับขนาดชิปเลยครับ

คือมองแบบนี้ได้ไหมครับ ถ้าขนาด die หรือเวเฟอร์ (เรียกไม่ถูก) เท่ากัน จะยัดทรานซิสเตอร์ได้เยอะและหนาแน่นกว่ามากๆ ใช่ไหมครับ

เรื่องหน่วยเข้าใจครับ

ที่สงสัยคือ ตัวเลขที่เเจ้งมา จาก 28 เป็น 16 nm มันทำให้ อุปกรณ์เล็กลงเกินครึ่ง หรือเกือบครึ่งครับ

มุมมองผมผมเลยอธิบายไปแค่ 100 เพื่อให้เข้าใจตามที่ผมเข้าใจอยู่ ซึ่งไม่รู้ว่าถุกหรือผิดไงครับ

แต่ถ้าเป็นขนาด ทรานซิสเตอร์ หน่วย nm ที่บอกมา มันเป็นขนาดของความกว้าง หรือยาว อย่างเดียวหรือเปล่า

กรณี มองที่ จำนวนทรานซิสเตอร์ เท่าเดิม ซึ่งจริงๆ chip อาจจะขนานเท่าเดิม เพราะอัด ทรานซิสเตอร์ เข้าไปอีกก็อีกเรื่องนึงครับ

เทคโนโลยี ตามข่าว 28--->16 น่าจะทำให้ chip เล็กลงกว่าครึ่งไงครับ

Ton-Or

คือ ถ้ามันเป็นพิมพ์เขียวเดียวกัน แค่ย่อส่วนลดขนาดทรานซิสเตอร์ ก็ถูกครับ น่าจะลดลงได้เกือบ ๆ 3/4

แต่ต้องอย่าลืมว่าเขาไม่ได้ลดขนาดทรานซิสเตอร์อย่างเดียวครับ มีการเพิ่มวงจรใหม่ ๆ เข้าไปอีก ทำให้จำนวนทรานซิสเตอร์เพิ่มขึ้นด้วย ดังนั้นสุดท้ายแล้วตัวไดก็จะอาจจะมีขนาดที่ใหญ่กว่า 1/4 ที่ว่ามากเหมือนกัน

ตรงนี้ต้องดูที่ขนาดของไดเป็นหลักครับ ไม่ใช่ขนาดของทรานซิสเตอร์ ผมเข้าใจว่ามีปัจจัยอื่น ๆ ที่มีผลต่อขนาดของไดด้วย นอกจากขนาดของทรานซิสเตอร์อย่างเดียว (อาจจะมีเรื่องของกราวนด์หรืออะไรพวกนั้นด้วย อันนี้ผมก็ไม่ทราบเหมือนกัน 55)

แต่ ขนาดของทรานซิสเตอร์มีผลอย่างมากต่อขนาดของได เพราะว่ามันเป็นชิ้นส่วนหลักของตัว processor น่ะครับ

ผมเข้าใจแบบนี้ 28x28 ครึ่งนึงควรจะเป็น 28x14

14x14 คือเล็กลง 1 ใน 4

16x16 คือเล็กลงเกือบ 1 ใน 4 เชียวนะครับ

โอเค เข้าใจแล้วครับ งั้นผมใช้คำว่า "เล็กลงเกือบ 1 ใน 4" แล้วกันนะครับ

แต่ผมว่า เล็กลงเกือบครึ่งมันก็น่าจะถูกแล้วนะครับ เพราะว่าส่วนใหญ่ die เขาไม่เปลี่ยนขนาดไปตามการผลิตนะครับ มักจะคง die พื้นที่เท่าเดิมแล้วยัดทรานซิสเตอร์ลงไปเพิ่มขึ้นเพื่อเพิ่มประสิทธิภาพของการทำงาน ดูอย่าง CPU สิครับ die เท่าเดิมเกือบจะตลอดเลยทั้งที่กระบวนการผลิตเล็กลง แสดงว่าเขาไม่ได้ปรับพื้นที่ die ตามขนาดเทคโนโลยีในการผลิตนะครับ ไอ้พวกที่ปรับขนาด die มักจะเป็นรุ่นที่ต้องการการใช้พลังงานต่ำหรือประสิทธิภาพต่ำลงเพื่อให้ต้นทุนผลิตถูกลงตามราคาขายมากกว่า

ยิ่งถ้าเรามองว่าเราพูดถึงเทคโนโลยีการผลิตไม่ใช้ขนาดในการผลิตชิป การใช้คำว่าเล็กลงเกือบครึ่งยิ่งน่าจะเหมาะยิ่งขึ้นไปอีกนะครับ

AnandTech บอกว่าประมาณ 120x120 มม. ครับ

มี Press Release ออกมาแล้วนะครับ ใช้ 14nm

เข้าใจว่าเป็น 120 mm² นะครับ (~11mm x 11mm แต่ GPU core ส่วนมากไม่ได้เป็นจตุรัสครับ)

ส่วน GTX950(GM206) อยู่ที่ 228 mm² (~15mm x 15mm)

ถ้า GM206 die shrink โดยตรงๆโดยไม่เปลี่ยนอะไรเลยก็จะอยู่ที่ 15*16/28 = ~9mm x 9mm ที่ 16nm หรือ ~8mm x 8mm ที่ 14nm ครับ

Russia is just nazi who accuse the others for being nazi.

someone once said : ผมก็ด่าของผมอยู่นะ :)

Core หรือ Die ครับ

die ครับ TT

Russia is just nazi who accuse the others for being nazi.

someone once said : ผมก็ด่าของผมอยู่นะ :)

555 แอบงง จำได้ว่า Core GPU มันเป็นร้อยเป็นพันเลย อัดอยู่ในนั้น

แต่เพิ่งนึก จริงด้วย... มันไม่จตุรัส ตัวแล้วที่แกะมาโป๊ะ Thermal Paste ใหม่

16nm FinFET หรือ 3D ครับคือไม่ได้มีแค่แนวนอนมีแนวตั้งด้วย

GPU ยังไปได้เรื่อย ๆ

ในขณะที่ CPU ไม่ค่อยจะไปไหนแล้ว

CPU ก็น่าจะแรงพอตัวอยู่นะครับ ในปัจจุบัน

ผมว่าพอๆ กันนะครับ ก็เห้นอัพความเร็วแรง กันเป็นปกติ แต่ละเจ้า intel เออ ก็มีเทคโนโยลีใหม่ๆ ใส่เข้าไปบ้าง มีแค่ช่วง ก่อน Skylake ที่ติดๆ เลยออกช้า ข้าม gen มา

ตั้งแต่ Intel ซอยเท้ากลับไปชูโรงเรื่องประหยัดแบต (กับ ULV กากๆ) ยิ่งเป็นเซิฟเวอร์จับยัดการ์ดจอแล้วดัมพ์ราคาขึ้นอีก ผมว่ามันถึงทางตันแล้วแหละครับ

ผมว่าสำหรับ x86 single-threaded non-SIMD performance เกือบตันแล้วล่ะครับ (เท่าที่รู้ architecture หลังๆ เร่งความเร็วโดยการเพิ่ม reorder buffer กับพวก hardware เกี่ยวกับ ILP เอาหมดเลย ซึ่งก็คงเล่นได้อีกไม่นาน)

multi-threaded/SIMD performance บนซีพียูยังได้อีกไกล แต่ปัญหาคือไอ้งานนี้มันงานหลักของ GPU น่ะสิ 5555 (แปลกใจที่อินเทลไม่ใส่ AVX-512 มาใน non-xeon อยู่ดี)

Intel ทิ้งห่างอยู่ เลยไม่ค่อยอัพไรใหม่ ๆ :P

ต่อไป ARM คงเป็นคู่แข่งกับ Intel มากกว่า AMD ละมั้ง

เขียนโปรแกรมยังไง ไม่ให้กินสเปค ยังอีกนานมากเลยกว่าจะถึงวันนั้น วันที่ AI คำนวนแทน

หืม H265 H/W Decode? รองรับ 10BIt ด้วยหรือเปล่า ถ้าได้ก็ได้ย้ายจากค่ายเขียวครั้งแรกก็คราวนี้แหละ

เห็น Anandtech บอกว่ารองรับครับ

ขอบคุณสำหรับข้อมูลครับ

เล่นเขียวกับฟ้ามานาน ถ้า Zen ออกเมื่อไหร่คงได้จัดชุดแดงบ้างแล้ว

รูปหาย

เอามาใส่ใน rMBP รุ่นหน้าหน่อยยยยยย

( ; 0 ; )

ถ้าใส่มาคงไม่พ้นรุ่น Top ของ 15" เหมือนเดิมแหงๆ -__-"

นี่เกลียดมาก เมื่อก่อนยังมีใน 15 ตัวล่างให้อยู่ พอยุค rMBP

โหดเกิ๊นนนนนน.... T____T

ไม่มีอะไรใหม่ขึ้นเลยเหรอ TT TT แค่ย้าย node การผลิตทำให้กินพลังงานน้อยลง(ซึ่งปัจจุบัน NVIDIA กินน้อยกว่าเยอะอยู่แล้ว) กับ 4K H.265(ซึ่ง GM206 ก็มีอยู่แล้ว)

แบบนี้ถ้า Pascal มา จะเอาอะไรไปสู้เนี่ย

Russia is just nazi who accuse the others for being nazi.

someone once said : ผมก็ด่าของผมอยู่นะ :)

เห็นว่าตอนนี้พยายามเล่นตลาดระดับกลาง (ประมาณ GTX950) ก่อนนะครับ ปลายปีอาจจะมีอีกรอบ

ข่าวล่าสุดพี่แกบอกว่า ประสิทธิภาพต่อวัตต์จะมากขึ้น2.5 เท่าครับ

2.5 เท่านี่ไม่น่าใช่แล้วครับถ้ายังใช้ GCN-updated เหมือนเดิมอยู่ เพราะมันเกินหลักฟิสิกส์ไปครับ และในกรณีเดียวกันถ้า Pascal ออกมาซึ่งเป็น die shrink+uArch change มันก็ควรลดมากกว่า 2.5 เท่า ซึ่งยิ่งเป็นไปไม่ได้ใหญ่เลยครับ

ถ้าผมเข้าใจข้อความจริงๆมาแค่

ซึ่งยังไม่รู้เลยครับว่า 2.5x คืออะไร

Russia is just nazi who accuse the others for being nazi.

someone once said : ผมก็ด่าของผมอยู่นะ :)

เอาจริงๆ เค้าแค่บอกว่าดาวเหนือวันนี้สว่างกว่าเมื่อเกือบๆสองพันปีที่แล้ว 2.5เท่าเองครับ แต่ดันกลายเป็น 2.5X hype ไปซะนี่

The “2.5 times” can mean alot of things, but the ones within the realm of possibility and probability are few. It can mean that AMD is bringing a 250% increase increase in performance (at whatsoever power cost) or that Polaris gives 2.5x the performance per watt (power efficiency) as compared to the current generation of GCN.

Read more: http://wccftech.com/amd-polaris-2-5-times/#ixzz3wK3oxyVN

จริงๆ 2.5 เท่าในส่วนของประสิทธิภาพต่อวัตต์ยังเป็นไปได้ครับ

แล้วข่าวยืนยันว่าเป็น 14nm FinFET ครับ ไม่ได้ใช้ 16nm แบบ Nvidia ให้ทั้ง GF และ Samsung ผลิต

28nm ที่เราใช้อยู่ปัจจุบันไม่ใช่ FinFET ครับ

ลำพังลดnmการผลิตมันเพิ่มประสิทธิภาพต่อวัตต์อยู่แล้วครับ

การจะปรับปรุงสถาปัตยกรรมเล็กน้อยเพื่อให้ประสิทธิภาพต่อวัตต์อีก 5-10% ผมว่าเป็นไปได้ครับ

การจะเพิ่มความแรง 2.5 เท่าไม่น่าจะเป็นไปได้แต่เพิ่มประสิทธิภาพต่อวัตต์ 2.5 ผมว่าเป็นไปได้

ถ้าเคยดูรีวิวตัว Fury Nano ครับ

node shrink+FinFET(/Intel 3D Gate) มันไม่ได้ลด power consumption แบบ linear นะครับ มันแค่ลด operating voltage ลงบ้างนิดหน่อยครับ และฝั่งที่ได้ประโยชน์คือฝั่ง low frequency มากกว่า hi frequency ครับ อันนี้ให้ลองดู slide ของ Intel ดูครับอธิบายได้พอเข้าใจเลย

ส่วนตัว Fury Nano ที่ power consumption ลดจาก Fury X นี่ไม่เกี่ยวอะไรกับเรื่องสถาปัตยกรรมเท่าไหร่ครับแต่เป็นเรื่อง voltage-magic จากการที่ลด clock speed ลงไปมากครับ

ให้ดูหน้านี้ประกอบนะครับ

1. voltage ขึ้นกับความถี่ แต่ไม่ได้เป็นแบบ linear และ curve จะชันขึ้นเมื่อความถี่ยิ่งสูงขึ้น ซึ่งอันนี้เป็นกับทุก CPU/GPU/etc. ครับ สำหรับ R9 nano ให้ดูกราฟ Voltage/Frequency Curve ครับ

2. P=CxFxV² ครับ, wattage ขึ้นกับ voltage แบบ exponential การเพิ่ม frequency แค่จาก 900MHz > 1000MHz(+100) ใช้พลังงานต่างกันอย่างน้อย 1.2²/1.07² = 25% ครับ

3. การใช้พลังงานที่ต่างกันมากในแต่ละระดับ frequency ทำให้ Nano ต้อง aggressive มากใน frequency throttling ครับ จากที่เห็นในกราฟ Average Clock Speed ตัว Nano แทบจะไม่สามารถเข้าสู่ boost clock ได้เลย

4. ลองดู system power consumption ของ Nano ที่มี avg frequency ที่ 857MHz ในเกม Crysis 3 ครับ ลองคิดดูว่าถ้า avg frequency อยู่ที่ 1050MHz(+193) เท่ากับ R9 Fury X ที่เป็น core ตัวเดียวกัน(Fiji XT) จะใช้ power consumption ขนาดไหน

5. สรุปได้ว่าใน core เดียวกัน(Fiji XT) ที่เรียกใช้งาน transistor จำนวนเท่ากัน จะมี power consumption curve ที่เกือบเท่ากันครับ

อันนี้ความเห็นของผมนะครับ

1. Nano มี power efficiency ที่ดีจริง แต่ก็เป็น frequency/voltage magic ไม่ได้เกิดจาก power efficiency ของตัว core เองครับ ในกรณีเดียวกันสมมติว่า NVIDIA ลด frequency ของ GTX980 ลงมา 25% แต่มีจำนวน CUDA core เท่าเดิม แล้วขายเป็น GTX970v2 ผมก็ไม่ได้คิดว่า efficiency ของ GM204 core ดีขึ้นแต่อย่างใดครับ

2. การกระทำแบบนี้แทบไม่ได้เป็นการลดต้นทุนการผลิตเลยครับ(แถมราคาขายจริงตัว Nano กับตัว X ราคาเท่ากันด้วยซ้ำ) เพราะมันเป็นการเอา core ที่สมบูรณ์มาลด frequency ลง ต่างจากการ disable core/CUDA ที่เสียหายจากการผลิตแล้วเอามาขายในราคาที่ถูกกว่า เช่น Fury X-> Fury, GTX980-> GTX970 และทำงานที่ max performance/frequency ของตัว core เอง

3. จริงๆแล้วการทำแบบนี้เกิดขึ้นทั่วไปครับ ยกตัวอย่างเช่น Apple A9 ที่น่าจะวิ่งได้ถึง 2.0-2.1GHz กลับถูก config ให้วิ่งที่ 1.85GHz ทำให้ efficiency สูงขึ้นมากจาก voltage-magic ครับ

Russia is just nazi who accuse the others for being nazi.

someone once said : ผมก็ด่าของผมอยู่นะ :)

รอดูผลเทสละกันครับ

คงต้องรอให้ชนะ intel หลายยกติดๆ กันน่ะครับ ถึงจะแบ่งยอดขายมาได้บ้าง ไม่งั้น intel ก็นอนตีพุงขายแพงๆ ไปเรื่อยๆ

อันนี้ฝั่ง GPU นะครับ

กรำๆๆๆๆ

ผมดูผิดเองครับ

ใจนึกถึงแต่ cpu

Intel แทบไม่เคยชนะในด้าน GPU เลยนะครับ :-)

+64 เห็น AMD แล้วคิดว่า CPU ตลอด...

พูดถึง Intel HD ที่ออกมาใหม่เห็นว่าภูมิใจว่าล้ม APU ในส่วนของ GPU ได้แต่กลับไม่ได้ดูเลยว่า GPU ใน APU ปัจจุบันมันคือ GCN 1.0 ที่มีอายุ 3ปีนะครับ ถ้า Zen ออกมาใช้ Polaris นี่ถีบหัวส่ง Intel HD สบายๆ

เพราะตัวใหม่สุดของ intel ยังได้แค่สูสีเบียดกับ GCN 1.0 ตัว 512SP ที่ใช้เทคโนโลยีของ 3ปีก่อนเองครับ

ยังไม่รวมความห่วยแตกของ driver ที่ชอบมีปัญหากับเกมด้วย

จุดสำคัญของ Intel ที่จะเล่นคือ i3+HD530 มันแรงกว่า cpuตัวล่างๆของAMD+GPUตัวล่างๆ ที่รวมแล้วราคาเท่ากันมากกว่าครับ รวมไปถึงAPU ด้วย

ส่วนZen จะโม้ยังไงก็ได้ ตราบใดที่ยังไม่ออกมาขายจริง และราคาจะแรงแค่ไหนอีก

ผมพูดถึงGPU ครับและข่าวนี้คือข่าวของ GPU

ให้พูดแบบตรงๆ คือtech ของGPU Intel ยังตามไม่ทันทั้ง Nvidia และAMD

ที่สำคัญi3 มาจากไหนผมว่าในข่าวนี้ผมไม่ได้พูดถึง i3 เลย

ผมพูดภาพรวมของIntel HD และความน่ารำคาญของการsupport จากทาง Intel

เกมใหม่ออกทั้งNvidia AMD ออกdriver มาแก้ให้แต่ของIntel นี่เล่นได้ก็ดีไปเกมไหนมีปัญหาก็ภาวนาเอาว่าพี่แกจะแก้ตอนไหน

ส่วนนี้ก็ไม่ควรจะลืมครับ

เป็นไปได้ไม่ควรเอาสิ่งที่เคยถกจากที่นึงมาคุยกันในอีกที่นึงเพราะบางทีมันคนละประเด็นอยากให้ดูบริบทด้วยครับว่าผมพูดถึงอะไร

นอกจากนี้ในUS เองAPU ไม่ได้ตั้งราคาบ้าเลือดแบบในไทยครับ

เพราะราคาพี่แกพอๆกับPentium G เอง

ส่วนตลาดในไทยผมว่าตั้งราคาแบบไม่อยากขายก็ปล่อยให้มันเน่าไป

เห็นท่านพูดถึงAPU ก่อนนี่ครับ ผมก็แค่ยกว่า ตลาดนี้ Intel ไปเน้น cpu ตัวล่าง-กลางแล้วแถม iGPU ที่แรงปานกลาง ที่รวมแล้วแรงกว่าคุ้มราคามากว่า(รวมถึงประหยัดไฟกว่า) HD530 ใน i3 แรงพอๆกับ HD7750/R7-250 มันก็แรงพอสำหรับคนใช้งานและเล่นเกมทั่วไปแล้วล่ะนะ ซึ่งมันกลายเป็นว่า คนที่งบประมาณนี้ ไม่ต้องซื้อGPUเพิ่มเลยก็ยังได้ ถ้าอยากแรงหรืองบมากกว่านี้ คงไปเล่นi5 ขึ้นไปนู่น

ส่วนจะบอกว่าชนะtech เมื่อสามปีก่อนต้องรอดูของใหม่ ผมก็แค่บอกว่า ก็ไม่ออกของจริงมาสักที ใครจะพูดยังไงก็ได้ครับ เบื่อตอนFury ที่โม้ใน presentation มากมาย สุดท้ายออกมา...

อยากให้ออกมาเร็วๆ จะได้ซื้อใหม่เสียที

ก็ เอา Zen + GCN + HBM (8GB) แค่นี้ก็น่าจะทำได้ระดับคอนโซลแล้วนะ (เผลอ ๆ Sony อาจจะเปลี่ยนใจมาใช้ใน PS4 ตัวใหม่ด้วยนะ เอเอ็มดี :D)

ถ้าผมจำไม่ผิด ps4 ก็ใช้ apu amd jaguar อยู่แล้วนิครับ โดยสเปคสูงกว่าฝั่ง xbox อยู่นิดหน่อย

คิดว่า playstation รุ่นใหม่คง amd แน่นอน เห็นมีข่าวลือแว่วๆจากเอกสารทีอ้างว่าเป็นของ amd บอกเป็นนัยว่า xbox รุ่นใหม่จะใช้ polaris ทาง sony คงไม่ยอมพลาดด้วยแน่

จุดที่คอนโซลยังเหนือกว่า น่าจะเป็นเรื่องของ perf/price กับตัว memory bandwidth น่ะครับ

ถ้าทำได้นี่ Sony อาจมีงอนกันบ้าง 555

อีกข่าว ยืนยันไปแล้วครับ xbox update ใช้ Polaris เรียบร้อย

https://www.blognone.com/node/76363

จากัวร์บน PS4 นั้นเน้นประหยัดพลังงานครับ clock ต่ำมาก 1.8GHz เองมั้ง

แต่ Zen + GCN + HBM น่าจะออกใน Nintendo NX ก่อนมากกว่าครับ

เพราะตอนนี้ปู่นินทั้งรับสมัครวิศวกรที่ถนัด X86 CPU แล้วข่าวก็มาชัดว่า AMD ผลิตตัว custom ชิบที่ว่าให้ Nintendo แน่นอนและใช้เทคโนโลยีล่าสุดเพราะปู่นินต้องการดึงสาวก 3rd Party มาช่วยยอดขายมากขึ้น

ถ้า NX มี backward compatibility ให้เล่นเกม WiiU ได้นี่จบเลยครับ

ลูกค้าเลือกแน่ๆเพราะ Nintendo มีจอยที่เหมือนของ Xbox 360 คือ Pro controller อยู่แล้ว

ตอนนี้มีข่าวเรื่อง MS กับ Sony ต้องการใช้ชิบตัวใหม่ เช่นกันเพราถ้าปล่อยให้ปู่นินทำเจ้าเดียว สเปกเครื่องนินเทนโดจะก้าวกระโดดมากๆเลย