เรามักจะได้ยินข่าวคราวของการนำ AI ไปประยุกต์ใช้ในแวดวงต่างๆ แต่ล่าสุด Yuichi Yagi นักวิจัยและโปรแกรมเมอร์ชาวญี่ปุ่นได้ทดลองนำ AI ไปช่วยในการสร้างอนิเมชั่น โดยทำให้ตัวการ์ตูนในอนิเมชั่นเคลื่อนไหวได้ลื่นไหลกว่าเดิมถึง 4 เท่า

ในการสร้างอนิเมชั่นนั้น เราสามารถแบ่งตัวชิ้นงานด้านภาพออกมาได้เป็นสองแบบคือ Key Frame หรือ เฟรมหลักซึ่งเป็นฉากหลักของแต่ละช่วง และ In-between Frame หรือ เฟรมระหว่างกลาง ซึ่งเป็นเฟรมที่อยู่ตรงกลางระหว่าง Key Frame แต่ละเฟรม ทำหน้าที่แสดงการเคลื่อนไหวของตัวละครหรือฉากหลังต่างๆ

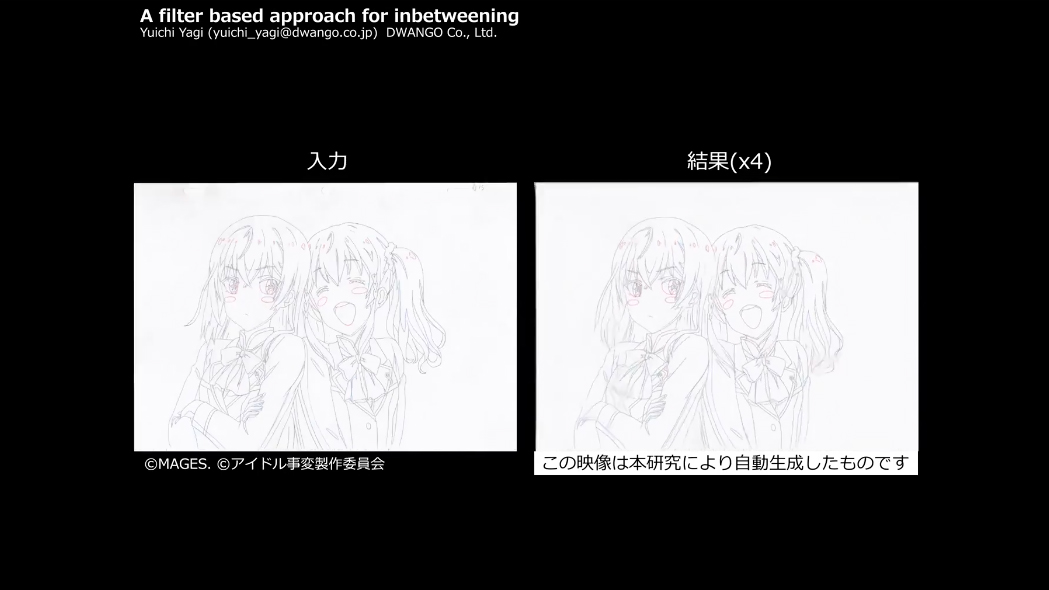

สำหรับโปรแกรมที่ Yagi พัฒนาขึ้นมาคือการให้ AI ช่วยสร้าง In-between Frame ขึ้นมาแบบอัตโนมัติ และ เมื่อมี In-Between Frame เยอะขึ้น การเคลื่อนไหวต่างๆ ก็จะดูลื่นไหลและเป็นธรรมชาติมากขึ้น

โปรเจคของ Yagi นี้เป็นการร่วมมือกันระหว่างเครือข่ายนิวรอน deep learning ของ Dwango บริษัทโทรคมนาคมของญี่ปุ่น และ Mages สตูดิโอผู้ผลิตอนิเมชั่น ซึ่ง Yagi ได้นำเอาบางช่วงบางตอนของอนิเมชั่น Idol Incidents มาป้อนให้กับตัวโปรแกรม และให้เครือข่ายนิวรอนเพิ่มจำนวน In-between Frame ขึ้น 4 เท่า ส่งผลให้อนิเมชั่นเคลื่อนไหวลื่นไหลขึ้น 4 เท่านั่นเอง

ผลลัพธ์ที่ออกมาถือว่าเป็นที่น่าพอใจ แต่ยังมีบางจุดที่ยังมีข้อผิดพลาดอยู่บ้าง สามารถรับชมคลิปผลการทดลองได้ที่ท้ายข่าว โดยต้นฉบับจะอยู่ทางซ้าย และ เวอร์ชั่นที่ถูกพัฒนาโดย AI จะอยู่ทางด้านขวา

ที่มา: Sora News 24

Comments

เพื่ม -> เพิ่ม

In-beteen => In-between

ญี่ปุ่น นี่มัน ญี่ปุ่นจริงๆ

ถ้า work ก็ไม่ต้อง sub งานไปที่ไทย กับ เกาหลี แล้วสินะ

In-between

Touch-up

2nd key animators

ก็เลิกบ่นเรื่อง งานหนัก ค่าแรงน้อยกันเสียที

เพราะจะตกงานไปเลย เหอะๆๆๆๆๆๆ

อีกหน่อยคงรวมงานใส่ cen เข้าไปด้วย เฮอะๆ

Uncensored ด้วยสิครับ

การเพิ่ม In-between Frame แบบนี้มันจะเหมือนการแทรกเฟรมที่อยู่ใน TV หรือเปล่าครับนี่

คงจะไม่เหมือนกันครับ ปกตินักเขียนเองลำพังงานมังงะรายสัปดาห์ก็น่าจะตึงมือมากอยู่แล้ว ไหนจะต้องคิดพล็อตเพื่อเข็นเรื่องออกมาให้ได้ 30 หน้าทุกสัปดาห์ ยึ่งต้องมาเจออนิเมะที่แค่ครึ่งชั่วโมง ต้องวาดรูปไม่ต่ำกว่า 43,000 เฟรม

ดังนั้นส่วนใหญ่อาจารย์นักเขียนเองน่าจะแค่วาดร่าง keyframe เพื่อกำหนดการเคลื่อนไหวตัวละคร มุมกล้อง แล้วโยนงานวาด in-between frame ให้กับกองทัพบรรดาผู้ช่วยครับ ที่เหมือนเป็น animator ในโลกอะนิเมะ

เอ๊ะ งานอนิเมะที่ทำจากมังงะปกตินี่นักวาดมังงะต้องมาช่วยวาดฝั่งอนิเมะด้วยเหรอครับ?

ไม่ต้องค่ะ สตูดิโอนิเมะซื้อลิขสิทธิ์ไปทำเองทั้งหมด คนวาดมังงะไม่มีส่วนเกี่ยวข้อง

ไม่จำเป็นครับ

ผมหมายถึงฟังก์ชั่นปั้ม frame rate ในทีวีหนะครับ

ที่พูดกันว่า 100Hz 200Hz

ระบบนั้นเท่าที่ผมจำได้ก็จะเอา frame หลักมาแล้วแทรก frame ตรงกลางเข้าไป โดยคำนวณเฉลี่ยมาจาก frame ก่อนแล้วหลังจากนั้น

อ่านแล้วนึกถึงโปรแกรม SVP เลย

ปกติเวลาเอาวิดีโอไปเปิดบนจอที่มี frame rate สูงกว่า จะมองเห็นเป็นภาพกระตุกๆ

ถ้าไม่อยากปรับ frame rate ของจอลดลง ก็ใช้โปรแกรมนี้แทรกเฟรมเข้าไปให้ดูลื่นไหลได้

แต่ก็ไม่ได้สมบูรณ์เป๊ะๆ ยังมีจุดที่ไม่เนียนอยู่บ้าง

ตัวอย่าง: https://www.youtube.com/watch?v=Wjb6CSe4708

ส่วนวิธีใช้ AI แบบในข่าวนี้ น่าจะเจ๋งกว่าเยอะ ดูล้ำ

ผมว่าฟังชันปั้มเฟรมพวกนั้นจะไม่ใช่การแทรกภาพที่เพิ่มรายละเอียดการเคลื่อนที่ของภาพในวิดีโอนะครับ แต่เป็นการก๊อปภาพเดิมซ้ำๆมาลงเฟรมตามรีเฟรชเรตของจอ เพื่อหลอกให้ตาเราเห็นภาพสมูทขึ้นไม่เกิดการกระตุกจากการที่รีเฟรชเรตของจอไม่เท่ากับเฟรมเรตของวิดีโอ ซึ่งต่างกับ AI ในข่าวนี้ เพราะมันสร้างภาพใหม่ขึ้นมาเลยจากการวิเคราะห์ Key Frame ที่ป้อนเข้าไป

https://en.wikipedia.org/wiki/Motion_interpolation

Interpolation เดี๋ยวนี้ส่วนใหญ่มีการคำนวณการเคลื่อนไหวของภาพระหว่างเฟรมที่แทรกด้วยเพื่อให้ได้ภาพที่ Smooth ขึ้น

พวกโปรแกรมตัดต่อเช่น Adobe Premiere กีมีฟังชั่นนี้ให้เลือกใช้ (เรียกว่า Optical Flow) สามารถเอาภาพวีดีโอธรรมดามาทำ Slow motion ได้คล้ายกล้อง slow motion ถ่าย แต่มันก็จะไม่สมบูรณ์แบบ มี artifact บ้าง ซึ่งก็เหมือนกะตัวอย่างการ์ตูนตัวอย่างข้างบน ผมก็เลยไม่แน่ใจว่าใช้ AI แล้วมันช่วยเรื่องนี้จริงๆ หรอ

http://www.144hzmonitors.com/knowledge-base/what-is-motion-interpolation-soap-opera-effect/

ถ้าก็อปภาพเดิมซ้ำๆ มาลงเฟรม มันก็ไม่ต่างจากดูที่เฟรมเรตเดิมนะครับ - -"

คือผมเข้าใจว่ามันเหมือน Vsync หรือของใหม่แบบ Freesync G-sync ในมอนิเตอร์น่ะครับคือแค่ช่วยให้ดูสมูทเฉยๆ เพราะอาการแลกของภาพส่วนนึงก็เกิดจากรีเฟรชจอไม่ตรงกับวินาทีของภาพที่แสดง เพราะผมว่าตัวโพรเซสเซอร์ในทีวีไม่น่าจะทำเรื่องแบบนั้นได้เพราะเทคนิคนี้มันก็เก่ามากราวๆ 10ปีได้แล้ว แต่ถ้าเป็นแบบข้างบนว่ามันมีการจำลอง between motion จริงๆ คือก็คงเป็นแบบนั้นละครับ คงเป็นความเข้าใจผิดของผมเกี่ยวกับเทคโนโลยีนี้เอง

ไม่เหมือนกันครับ พวกอัพเฟรมจะวาดเฟรมใหม่ขึ้นมาแทรกเลย ซึ่งถ้า Pause ดูมันจะค่อนข้างเบลอๆ เพราะมัน Interpolate มาแบบที่ข้างบนบอก ซึ่งเหมาะกับพวกภาพ Movie ที่ถ่ายมาจริงๆ มากกว่า เพราะการเคลื่อนไหวมันเป็นการเคลื่อนไหวของ Object จริงๆ ส่วนภาพ 2D มันมีการใส่เส้นสปีด ฯลฯ ให้ดูเหมือนมีการเคลื่อนไหวจริงๆ (เพราะวาดไม่ไหว) พอเอามาคำนวณสร้างเฟรมใหม่มันเลยดูเละๆ แบบภาพตอนสะบัดนิ้วในคลิป

ส่วนการทำก็มีทั้งที่ใช้ HW ทำแบบในทีวี กับแบบ SW อย่าง SVP ที่ข้างบนบอก หรือแบบเสียตังค์เช่น Splash ก็มีครับ

ผมยังไม่พอใจครับ ผมสาย screencap

ตอนยังไม่ลงสีก็เลยเห็นไม่ชัด แต่พอลงสีแล้วเห็นได้เลยว่าใช้งานจริงยังไม่ได้ ทุกอย่างที่ขยับเละหมดกลายเป็นก้อนๆอะไรก็ไม่รู้

อยากเห็นตอนเสร็จครับ งานแบบนี้ไม่ค่อยมีใครทำ หรือทำจนเข็น prototype มาได้ เพราะก้าวแรกมักจะยากเสมอ นี้ถือว่าผ่านก้าวแรกมาล่ะ

มันไม่ง่ายเลยที่จะทำ GIF ให้มีขนาดน้อยกว่า 20kB

ทำเสร็จแล้วต่อให้เนียนแค่ไหนจนดูไม่ออก ต้องห้ามเผยครับว่าใช้ ai ไม่งั้นแฟนโจมตีชัวร์ มันดูไม่เป็นธรรมชาติ!!! อะไรแบบนี้มาชัวร์ ฮา

จริงแล้วผมว่าอีกไม่นานคงไม่ใช่แค่ Prototype แล้วล่ะ ต่อไปคนเขียนการ์ตูนคงแค่ระบุ skeleton ของเนื้อเรื่อง กำหนดตัวละคร อาจไม่ใช่ทุกเฟรมด้วย อาจเป็นแค่เฟรมเริ่ม กับเฟรมสุดท้าย ของแต่ละฉาก แล้ว AI เขียนเฟรมที่หายไปให้ เพราะการเคลื่อนไหวพวกนี้มันคงตัวตามหลักสรีระศาสตร์อยู่แล้ว เพียงแต่อาจเพิ่มค่า Overacting ของแต่ละตัวละครได้ ระบบ Machine learning ก็เอาภาพจากฐานข้อมูล มา Map เข้ากับโครงเคลื่อนไหวที่กำหนดไว้ ถ้าทำได้มันพลิกวงการสร้างอนิเมะ ลดกระบวนการ ต้นทุนและคนได้บานเลย

ถ้าถึงเวลานั้นคงจะพ้นช่วงเวลาที่ดูคนที่พูดขยับแต่ตัวละครอื่นๆ หยุดนิ่งกันหมดทั้งจอล่ะนะครับ (เค้าไม่ให้ขยับเพื่อลดงานวาดใช่มั้ย? หรือจริงๆ คือเพื่อให้สนใจเฉพาะคนที่กำลังพูด?)

เพราะวาดไม่ไหวครับ ทำรายสัปดาห์แค่วาดเฉพาะที่ขยับก็มือหงิกแหล่ว

ผมว่ายังดูไม่เปนธรรมชาติ ยังขัดตาไงพิกลนะ

The Last Wizard Of Century.

เห็นเเหมือนผม over ไปนิดหน่อย

อยากเห็น ฉากต่อสู้ที่ตัวละครหายตัวแวบไปมา AI จะทำออกมาเป็นแบบไหน

นึกว่าสมัยนี้ไม่ต้องวาด Frame by Frame แล้วซะอีก

ฉากหลังในเมะ เริ่มใช้คอมแทนได้

เหลือแต่ตัวละครนี่แหละ

แนวโมเดล3D ก็ยังดูแปลกๆ