Josh Lovejoy ผู้ออกแบบ UX ของกูเกิล เขียนบล็อกอธิบายเบื้องหลังการทำงานของ Google Clips กล้อง AI ที่กูเกิลบอกว่าสามารถตัดสินใจบันทึกภาพช่วงเวลาสำคัญได้ด้วยตัวมันเอง ซึ่งมีรายละเอียดน่าสนใจหลายอย่าง

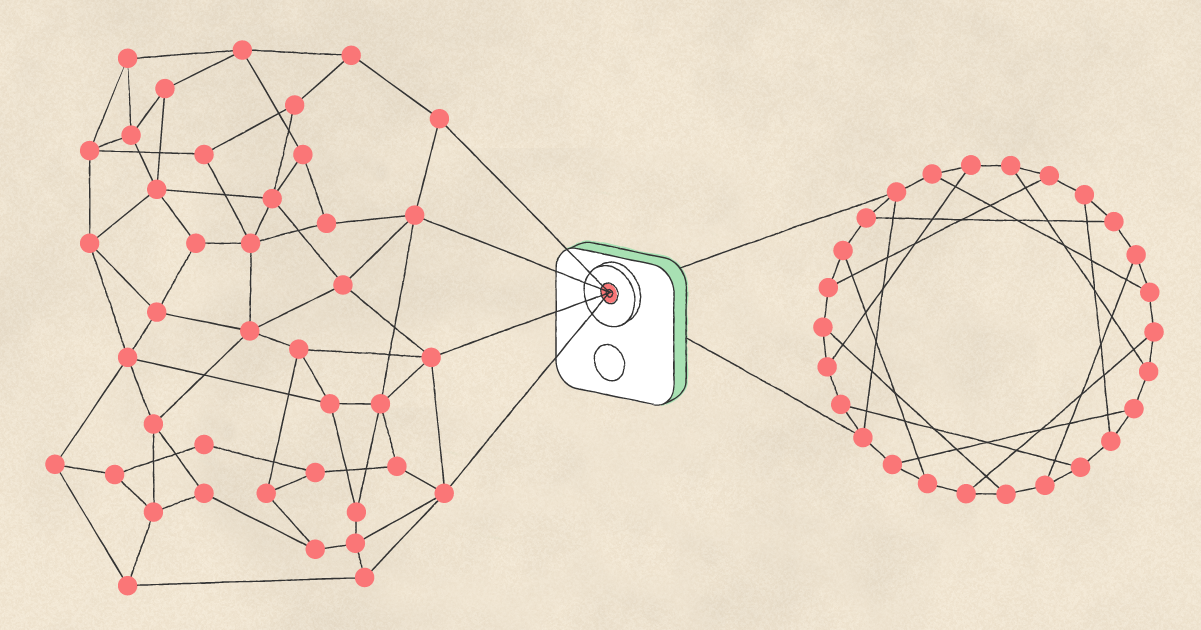

แนวทางออกแบบนั้นกูเกิลเรียกว่าเป็น Machine Learning แบบที่มีคนเป็นศูนย์กลาง โดยต้องทำให้แน่ใจว่าผลลัพธ์ที่ได้นั้นคนจะพึงพอใจด้วย ไม่ใช่พึ่งพาการตัดสินใจของ ML ฝ่ายเดียว กูเกิลจึงจ้างช่างภาพมืออาชีพในหลากหลายแนวมาช่วยเลือกว่าภาพแบบไหนที่เรียกว่าดี และดูมีความสำคัญ ตั้งแต่ช่างภาพสายนักข่าว, สายสารคดี ไปจนถึงแนวศิลปะ

ตัวอย่างที่กูเกิลยกมาคือภาพใบหน้าลูก ที่พ่อแม่มักเลือกถ่ายรัวต่อเนื่องเป็นจำนวนหลายภาพ แล้วหวังว่าจะไปเลือกภาพที่ดีที่สุดอีกที ซึ่ง Clips จะเทรนข้อมูลโดยเลือกช็อตดีที่สุดมาให้เลย ซึ่งกระบวนการนี้ต้องมีคนมาช่วยเทรนข้อมูลอีกที

นอกจากการเทรนข้อมูลว่าแบบไหนคือภาพที่ดี ยังต้องเทรนด้วยว่าภาพแบบไหนที่ไม่ดี ซึ่งทำให้ Clips เลือกไม่เก็บบันทึกภาพเหล่านั้นและประหยัดพลังงาน ตัวอย่างสองภาพนี้ที่ถูกนำไปเทรน โดยภาพซ้ายคือกล้องอยู่ในกระเป๋า ภาพมืดจึงไม่ต้องบันทึก ส่วนอีกภาพนิ้วเผลอบังเลนส์ ก็ไม่ต้องบันทึกไว้เช่นกัน

ตัวอย่างการเทรนข้อมูลถัดมาคือการให้กล้องวางตำแหน่งในภาพให้ดีที่สุด วิธีการหนึ่งคือจับใบหน้าคนให้อยู่ตรงกลางตลอดเวลา (ภาพซ้าย) ส่วนภาพขวาซึ่งเกิดการหลุดเฟรมให้ถือเป็นภาพที่ไม่ดี

สุดท้ายกูเกิลบอกว่า การทำให้กล้องสามารถถ่ายภาพที่ดีที่สุดของแต่ละคนได้เสมอนั้น เป็นเรื่องที่ไม่ง่าย มันมีการคาดเดาในทาง ML อยู่ด้วย โดยยอมรับว่าทุกอย่างย่อมมีข้อผิดพลาด ผลิตภัณฑ์นี้ไม่ได้สมบูรณ์แบบ แต่พยายามเรียนรู้จากผู้ใช้งาน แล้วนำมาพัฒนาปรับปรุงให้ได้มากที่สุด

ที่มา: Engadget และ Google Design