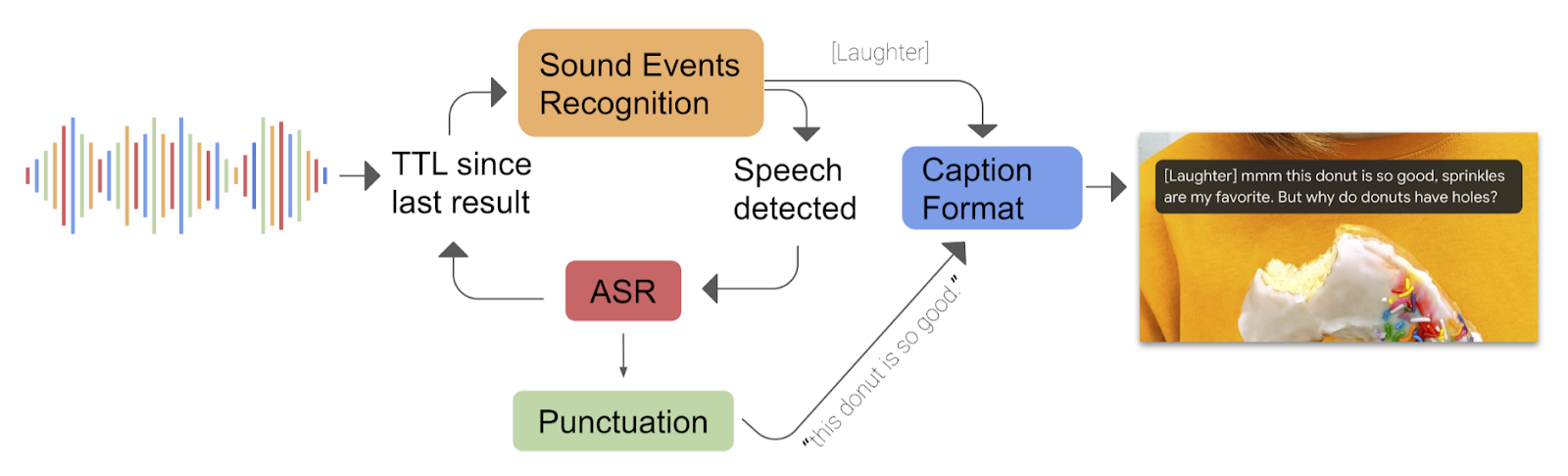

กูเกิลอธิบายถึงสถาปัตยกรรมของการใช้ deep learning ในฟีเจอร์ Live Caption ที่เป็นการทำคำบรรยายเสียงในจากโทรศัพท์ทั้งหมด โดยใช้โมเดล deep learning ทำหน้าที่ต่างกันถึง 3 ชุดในฟีเจอร์นี้

โมเดลแรกที่รันอยู่ตลอดเวลาที่ฟีเจอร์ทำงานคือโมเดลจัดหมวดหมู่เสียง (sound event recognition) โดยภายในเป็นโมเดลแบบ convolutional neural network (CNN) ทำหน้าที่จัดหมวดหมู่ว่าเสียงตอนนี้เป็นเหตุการณ์แบบใด เช่น เสียงหัวเราะ, เสียงดนตรี, หรือเป็นเสียงพูด

เมื่อพบเสียงพูด เสียงส่วนที่เป็นคำพูดจะส่งต่อไปยังโมเดลแปลงเสียงเป็นคำพูดที่สถาปัตยกรรมภายในเป็นแบบ recurrent neural network transducers (RNN-T) โดยโมเดลนี้จะทำงานเฉพาะเมื่อพบเสียงพูดเท่านั้นเพื่อประหยัดหน่วยความจำและพลังงาน โดยโมเดลนี้ย่อมาจากโมเดลเต็มด้วยเทคนิคต่างๆ เช่น การลดความเชื่อมโยงในโมเดล (neural connection pruning) ทำให้โมเดลมีขนาดลดลงครึ่งหนึ่งแต่ยังได้ประสิทธิภาพที่ดี

โมเดลสุดท้ายคือตัวใส่เครื่องหมายเว้นวรรค (punctuation) เพื่อสร้างรูปประโยคให้สมบูรณ์

ฟีเจอร์นี้เริ่มใช้งานได้แล้วใน Pixel 4 และรองรับเฉพาะภาษาอังกฤษ ส่วน Pixel 3 จะได้รับในปีนี้ และทีมงานเตรียมรองรับภาษาอื่นๆ ตลอดจนฟีเจอร์เพิ่มเติมเช่นการพูดหลายคน

ที่มา - Google AI Blog

Comments

หาไฟล์ apk ของแอปอัดเสียงมาลงมือถือพบว่าถอดได้แม่นมากๆ ชื่อเฉพาะหรืออะไรก็รู้จักหมด มีแยกประโยค รู้ว่ากลุ่มคำนั้นเป็น adjective ก็ใส่ขีดให้

เซอร์ไพรส์กับเทคนิคที่ลดลงมาให้ใช้งานจริงในมือถือได้นี่แหล่ะ

มือใหม่!! ใหม่จริงๆนะ

จริงๆแล้วอาจจะต้องบอกว่า มือถือก็"ใหญ่"ขึ้นนะครับ เดี๋ยวนี้ resources ไม่น้อยแล้ว

เห็นด้วยคับ ไม่ใช่ เมม 64kb แรม 1 mb แล้ว เดี๋ยวนี้ ในมือถือแรมปาไป 12GB แล้ว ^^