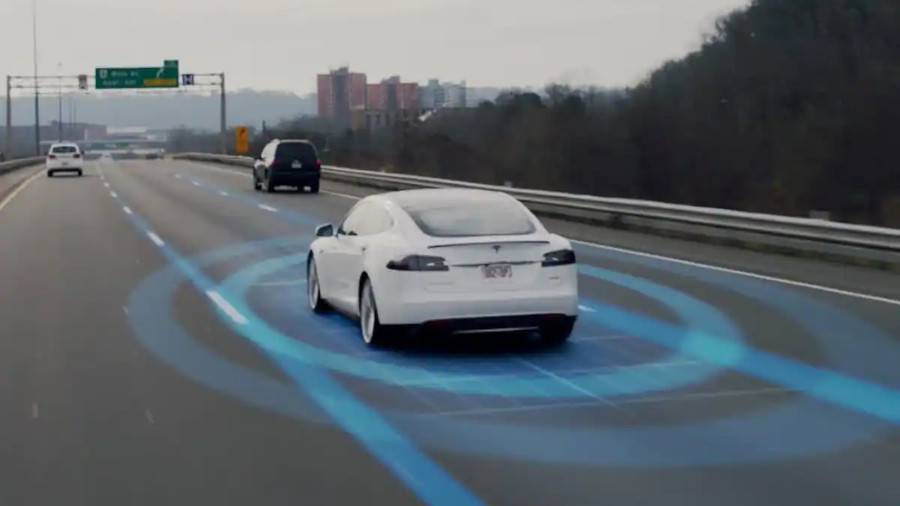

Tesla ออกประกาศว่าจะเลิกติดตั้งเซ็นเซอร์คลื่นอัลตร้าโซนิก (ultrasonic sensors หรือ USS) ในรถยนต์ของตัวเอง เพื่อเปลี่ยนผ่านมาสู่การใช้กล้องทั้งหมด (Tesla Vision) ตามแนวทางที่เคยประกาศไว้ก่อนหน้านี้

เดิมที ระบบ Autopilot/Full Self-Driving (FSD) ของ Tesla ใช้เซ็นเซอร์หลายอย่างร่วมกันวัดระยะห่างกับวัตถุรอบตัวรถ แต่หลังจากซอฟต์แวร์ FSD v9 เป็นต้นมา Tesla บอกว่าตัดสินใจใช้กล้องอย่างเดียว เพราะมั่นใจว่าให้ประสิทธิภาพในการตรวจจับดีกว่าเซ็นเซอร์ประเภทอื่น (ทั้งเรดาร์และอัลตร้าโซนิก)

การเปลี่ยนแปลงจะเริ่มจากรถยนต์รุ่น Model 3 และ Model Y ที่ผลิตใหม่ในเดือนตุลาคม 2022 จะตัดเซ็นเซอร์ USS ออกไป ส่วน Model S และ Model X จะเปลี่ยนตามในปี 2023

รถยนต์รุ่นใหม่ๆ ที่ไม่มีเซ็นเซอร์ USS จะยังใช้ซอฟต์แวร์เดิมในช่วงแรก ทำให้ฟีเจอร์บางอย่าง เช่น Park Assist, Autopark, Summon ใช้งานไม่ได้ แต่ Tesla จะอัพเดตเอนจินหลังบ้านเป็น vision-based occupancy network อิงตามภาพจากกล้องแทนเซ็นเซอร์ ให้กลับมาใช้งานได้ (มีเวลาเปลี่ยนผ่านสักระยะหนึ่งแต่ไม่บอกว่านานแค่ไหน บอกแค่ว่า short period of time) ส่วนฟีเจอร์ชูโรงอย่าง Autopilot และ FSD จะใช้งานได้ตั้งแต่แรก

ส่วนรถรุ่นเก่าที่ขายไปแล้ว มีเซ็นเซอร์ USS อยู่แล้ว จะไม่ได้รับผลกระทบใดๆ เพราะยังใช้ซอฟต์แวร์ตัวเดิมที่ออกแบบมาเพื่อ USS อยู่แล้ว และยังไม่มีแผนจะถอดซอฟต์แวร์ออก

ที่มา - Tesla, ภาพจาก Tesla

Comments

อย่างคาด

นึกไว้แล้วว่าถ้ารถเป็นร้อยคันใช้เซ็นเซอร์หมดมันจะแยกแยะยังไงทัน สัญญานคงกวนกันน่าดู

อีกหน่อยก็เหมือนคนใช้ตาเปล่าๆ ขับรถ มันจะพลาดเหมือนคนไหมนะ

เมื่อก่อนก็เข้าใจรถล้ำๆ มี sensor เยอะๆ หลายแบบช่วยกันทำงานกันข้อผิดพลาดจาก sensor บางตัว สมัยนี้ตัดออกกันหมด คงประหยัดได้เยอะ

โอกาสพลาดก็มีครับ แต่มันไม่กวนกับคันอื่นเพราะเป็นขารับอย่างเดียว ไม่ได้ส่งคลื่นอะไรออกไปจากเครื่องแบบ ultra sonic หรือ laser

พลาดน่าจะต่ำกว่าคนเพราะ

- กล้องมีหลายตัว มุมอับน้อยกว่ามุมมองคน

- กล้องทุกตัวเห็นภาพตลอดเวลา ไม่วอกแวก

เข้าใจว่าเดี๋ยวนี้เซ็นเชอร์บางอย่าง เช่น Collision Sensor ของ Subaru ก็ใช้กล้องอย่างเดียว (Eyesight)

แต่สิ่งที่ผมติดใจ คือการทำงานในที่มืดเนี่ยหล่ะครับ จะแม่นยำพอไหม

เพราะ Ultrasonic จะไม่มีปัญหาเรื่องนี้ แม้เจอรถไม่เปิดไฟขับมาใกล้ๆ ก็สามารถเตือนได้อย่างแม่นยำ เช่นระบบ BSM

หวังว่า AI ในรถคงมีความเป็นคนบ้าง แบบรถโดนน้ำสาดใส่ฝนตกหนัก บดบังกล้องงี้ แล้วรถชะลอตัวบ้างนะครับ หรือรถมึนจอดเลย อย่างคนตอนฝนตกหนักมากๆ เราก็ยังขับไปเรื่อยๆ ช้าๆ

ถ้ากล้องจับได้มากกว่าแค่แสงก็น่าจะดี ถ้าเอา IR ร่วมด้วยก็แจ่ม

IR ก็แสงนะครับ sensor กล้องปกติต้องกรองแสง IR ออกไปเสียด้วยซ้ำ ถ้าไม่ทำอะไรเลยจะถ้า IR ได้บางส่วนอยู่แล้ว

สัก 15 ปีที่แล้วผมเคยเอากล้อง webcam จีนตัวไม่กี่บาทมาแงะตัวกรอง IR ออกแล้วทำเป็นกล้องวงจรปิดที่กลางวันเห็นสีกลางคืนเห็น IR อยู่ครับ 😅

พวกกล้อง IR หรือ night vision ถ้ามืดจริงก็ไม่เห็นอะไรนะครับ ถ้าฉายแสง IR ช่วย ไม่รู้จะเจอเคสภาพหลอก AI มึนขับชนรถด้วยหรือเปล่าถ้าไม่ได้มีระบบสำรองช่วยเช็คอีกที

ว่าเหตุผลหนึ่งที่อีลอนเอา Lidar ออกน่าจะเป็นเรื่องความสวยงามนะ 555 ถ้าว่าตามตรงตลาดของรถประเภทส่วนตัวนี้ที่พยายามจะพัฒนาไปให้ถึง FSD ถ้าไม่นับ Waymo ได้ก็ไม่มีใครกล้าใส่ Lidar เลยสักแบรนด์ ตัวผมตอนนี้พอได้เล่นโปรแกรมวาดภาพ AI ก็เริ่มเข้าใจข้อจำกัดของระบบ"CV" แล้ว หลักการของมันว่ามันเป็นเรื่องของการทำแท็กและแยกแยะภาพ ที่ปัญหาที่มันแยกไม่ออกมันเป็นไปได้อยู่แล้วที่จะเจอเคส ที่โมเดลมันไม่รู้จักเหมือนข่าวที่รถมันมองเห็นคนโหนท้ายรถสองแถวแล้วเบรคตัวโก่งน่ะแหละ