จุดขายสำคัญของเฮดเซต Vision Pro ของแอปเปิล คือการควบคุมสั่งการโดยไม่ต้องใช้อุปกรณ์เพิ่มเติม แต่ใช้การตรวจจับตำแหน่งดวงตา และการออกท่าทางของมือ (Gesture) ซึ่งในเซสชันสำหรับนักพัฒนา แอปเปิลก็ได้ลงรายละเอียดที่มากขึ้นของส่วนติดต่อผู้ใช้งานนี้

โดยรูปแบบการออกท่าทางมือพื้นฐาน มีทั้งหมด 6 รูปแบบได้แก่

- Tap ทำท่าจีบนิ้ว โดยนิ้วชี้และนิ้วโป้งแตะกัน เป็นการเลือกวัตถุนั้น เหมือนการแตะจอใน iPhone

- Double Tap แตะนิ้วชี้และนิ้วโป้งต่อเนื่องสองครั้ง

- Pinch and Hold เหมือนการแตะค้างใน iPhone เช่น การเลือกไฮไลท์ข้อความ

- Pinch and Drag ใช้เลื่อน-ลากวัตถุ

- Zoom เป็นท่าที่ต้องใช้สองมือ แตะนิ้วพร้อมกันแล้วทำท่าลากเพื่อซูมเข้าออก

- Rotate เป็นอีกท่าที่ใช้สองมือ สำหรับการหมุนดูวัตถุที่เลือก

ท่าทางของมือจะทำงานร่วมกับระบบตรวจจับตำแหน่งดวงตา เพื่อให้การกดเลือกวัตถุแม่นยำถูกต้อง ตัวอย่างเช่น หากมีไอคอนแอปหลายแอป หรือปุ่มคีย์บอร์ดเสมือน ดวงตาจะทำหน้าที่เล็งตำแหน่ง และท่าทางของมือจะยืนยันว่าต้องการออก action กับตำแหน่งนั้น ในการออกท่าทางของมือนั้น แขนและมือสามารถวางอยู่ที่หน้าตักได้ ซึ่งลดอาการเมื่อยหากใช้งานนาน ๆ

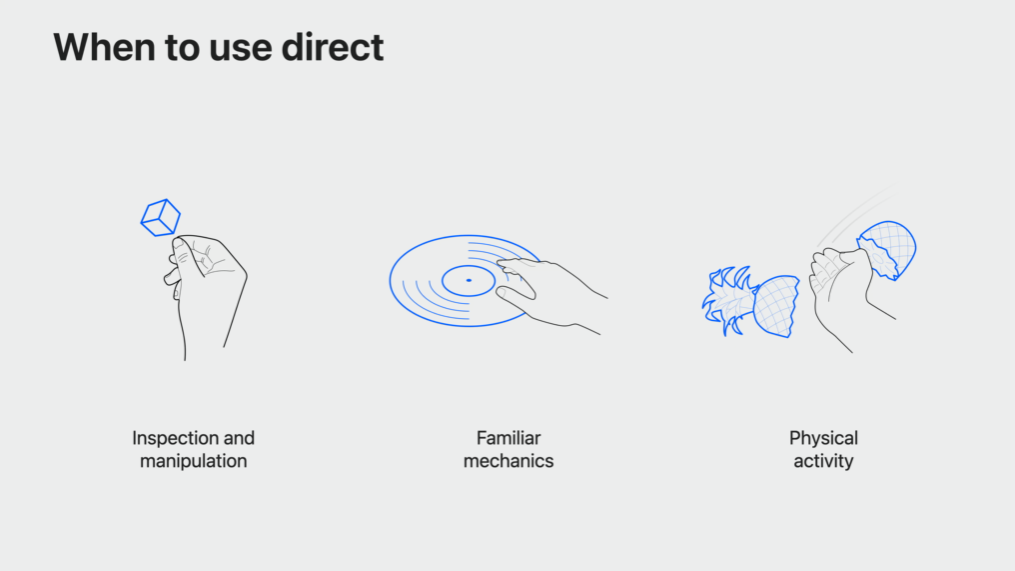

นักพัฒนายังสามารถสร้างท่าทาง Gesture เพิ่มเติมได้อีก โดยมีคำแนะนำให้เลี่ยงท่าทางที่คนอาจเผลอทำเป็นปกติ และหลีกเลี่ยงท่าทางที่อาจทำให้เกิดการล้าได้ง่ายหากทำต่อเนื่อง

สามารถดูเซสชั่นของนักพัฒนาได้ที่นี่

ที่มา: MacRumors

Comments

ดุดีนะ

นึกถึง fruit ninja 555

อยากรู้เรื่องความแม่นยำเลย ว่าถ้าหากมีปัจจัยภายนอกมากระทำ หรืออยู่ติดแนวขอบกล้องมันจะตอบสนองอย่างไร เพราะจริงแล้วการทำ Computer Vision เพื่อตรวจจับการทำ Gesture ค่อนข้างยากเนื่องจากต้องใช้ศาสตร์หลายอย่างผสมกัน

เจ้าใจว่า lidar มีช่วยในเรื่่องนี้ด้วยหรือเปล่านะ

มือใหม่!! ใหม่จริงๆนะ

เห็นของ Hololens ทำมาก็ดูเวิร์คนะ ของฝั่ง meta เหมือนจะทำได้แต่ยังไม่เคยดูคลิปตอนใช้แฮะ

ตามนี้ครับ

quest 2 ทำได้แค่จีบเพื่อคลิก แต่จับท่าทางมือได้แม่นเหมือนเห็นมือตัวเองเลย

เหมือน Gestureในหนัง Minority report ที่tom cruise ปัดๆ

จริง

รำกันสนุก ประสานอินกันเพลินเลยทีนี้

อย่าถึงขั้นรำมวยไทยเก๊กก็พอ xD

รอดูคนใช้บนรถไฟฟ้า

ซูมด้วยมือเดียวจะตามมาไหมนะ?

จากที่เคยลองใช้งาน hololens 2 มา ก็คือใช้ท่าทางเดียวกัน คิดว่าน่าจะเป็นท่ามาตรฐานในการสั่งการด้วยมือแบบนี้แหละ ซึ่งของ hololens จะมีท่าหงายฝ่ามือจิ้มไอคอนวินโดตรงข้อมือเพื่อเปิด start menu ไม่รู้ว่าของ apple จะเหมือนกันไหมเวลาอยากกลับหน้า home

พิมพ์สัมผัสจะแม่นมั้ย

อยากได้ถุงมือที่มี haptic touch

อยากได้ แต่ราคาเกินเอื้อมจริง ๆ

รอรุ่น SE

ผ้าเช็ดจะมาก่อน

อาจจะมีรุ่น Ultra Max มาแทนก็ได้นะครับ

เค้าอาจจะหมายถึง SE = Specially Expensive ก็ได้นะครับ