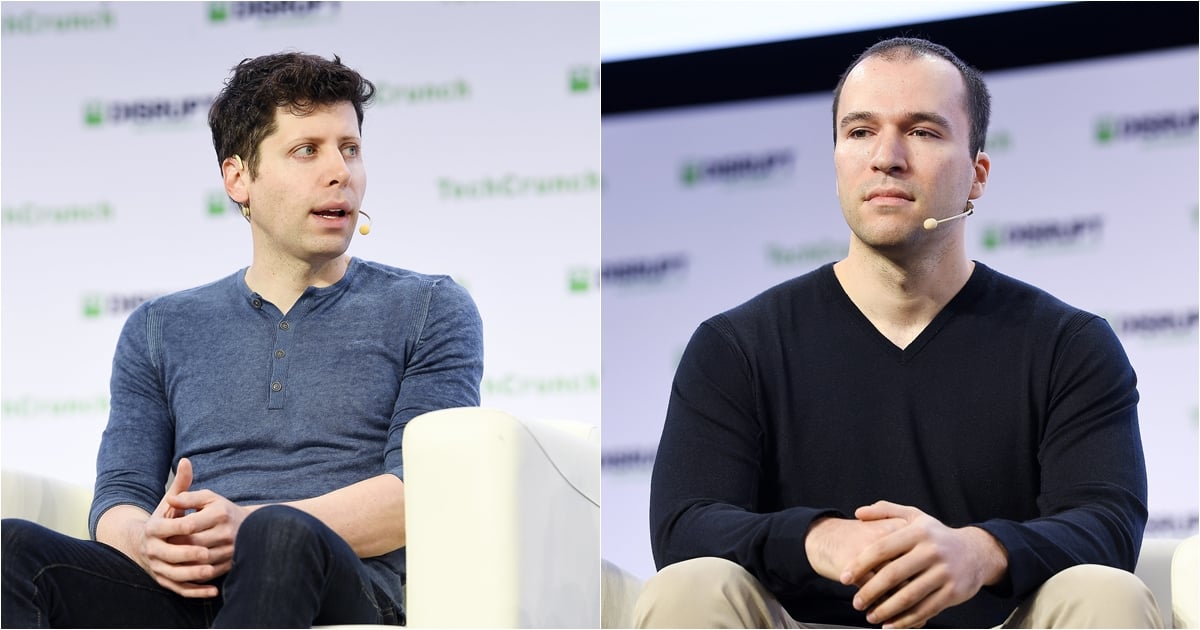

Sam Altman ซีอีโอ OpenAI และ Greg Brockman ประธาน OpenAI ออกมาโพสต์ชี้แจงใน X เกี่ยวกับประเด็นฝ่าย Superalignment ที่มีภารกิจดูแลรับมือความปลอดภัยของ AI ที่อาจมีความสามารถมากขึ้น หลังจาก Ilya Sutskever หัวหน้าทีมได้ลาออก และ Jan Leike หัวหน้าทีมร่วมที่ลาออกเช่นกัน ออกมาเปิดเผยว่า OpenAI ลดความสำคัญของการทำงานฝ่ายนี้ ทั้งที่ AI มีแนวโน้มอันตรายมากขึ้น

Altman บอกว่าเขาขอบคุณในทุกสิ่งที่ Leike ทำขณะอยู่ที่ OpenAI ทั้งการวิจัยพัฒนาสร้าง AI ที่ปลอดภัย และเขาพูดถูกต้องว่า OpenAI ยังมีอะไรต้องทำอีกมาก และยืนยันว่า OpenAI จะต้องทำสิ่งเหล่านั้น

i'm super appreciative of @janleike's contributions to openai's alignment research and safety culture, and very sad to see him leave. he's right we have a lot more to do; we are committed to doing it. i'll have a longer post in the next couple of days.🧡 https://t.co/t2yexKtQEk

— Sam Altman (@sama) May 17, 2024

ด้าน Brockman ชี้แจงเกี่ยวกับแผนกลยุทธ์ในการกำกับดูแล AI ที่ปลอดภัยของ OpenAI เป็นข้อ ๆ ดังนี้

- OpenAI ได้สร้างการตระหนักรับรู้ถึงโอกาสและความเสี่ยงของ AGI เพื่อให้โลกเตรียมรับมือ รวมทั้งทำงานกับรัฐบาลทั่วโลกเพื่อหาวิธีกำกับดูแล พัฒนาเครื่องมือในการประเมินความเสี่ยง

- OpenAI ได้ออกระเบียบพื้นฐาน ก่อนการดีพลอยโมเดล AI ใหม่สู่สาธารณะให้ปลอดภัย ซึ่งเห็นได้จาก GPT-4 สิ่งนี้ไม่ใช่เรื่องง่ายเลยในการพัฒนาช่วงแรก

- อนาคตจะยากและซับซ้อนกว่าปัจจุบัน การพัฒนาเฟรมเวิร์กกำกับดูแลต้องปรับปรุงอยู่ตลอด

สิ่งที่ OpenAI ทำคือการสร้างเครื่องมือตรวจสอบ เพื่อรองรับโมเดลในอนาคตที่มีแนวโน้มปรับปรุงให้เข้ากับงานแต่ละประเภทมากขึ้น ความท้าทายคือการสเกลให้รองรับทุกงาน มองไปข้างหน้าเห็นรูปแบบความปลอดภัยที่จำเป็น OpenAI ยอมรับว่าตอนนี้ก็ไม่แน่ใจว่าระดับความปลอดภัยที่มีอยู่เพียงพอหรือไม่ แต่หากพบว่ายังไม่พอก็พร้อมที่จะเลื่อนการเผยแพร่โมเดลต่อสาธารณะ

We’re really grateful to Jan for everything he's done for OpenAI, and we know he'll continue to contribute to the mission from outside. In light of the questions his departure has raised, we wanted to explain a bit about how we think about our overall strategy.First, we have… https://t.co/djlcqEiLLN

— Greg Brockman (@gdb) May 18, 2024

สุดท้าย Brockman บอกว่าวันนี้โลกยังไม่มีสูตรสำเร็จในการกำกับดูแล AGI ภาพในอนาคตตอนนี้ก็ยังไม่มีใครจินตนาการถึงได้ สิ่งที่ทำได้คือการพิจารณา ตรวจสอบ ทำซ้ำในทุกขั้นตอน ร่วมมือกับภาคส่วนต่าง ๆ อย่างรอบคอบ เพื่อให้แน่ใจว่า AI ที่ออกมามีความปลอดภัย

ที่มา: Business Insider ภาพ Flickr TechCrunch [1], [2]

Comments

อัพ vit เยอะๆก็ได้ถ้าไม่มี agi

OpenAI เองก็มีคู่แข่ง ดูอย่าง Google ถ้าสนใจศีลธรรม ไม่แสดงภาพโป๊เลย

คู่แข่งก็จะโตได้อีกมาก I