เมื่อเดือนเมษายนที่ผ่านมาทีมวิจัยรวมระหว่าง Massachusetts Institute of Technology, California Institute of Technology, และ Northeastern University นำเสนอรายงานถึงสถาปัตยกรรม Kolmogorov Arnold Networks (KANs) ที่ได้รับแรงบันดาลใจจาก Kolmogorov–Arnold representation theorem โดย KAN อาจจะเป็นแนวทางใหม่ในการสร้าง neural network ที่ขนาดเล็กลงแต่ประสิทธิภาพคงเดิม และทำความเข้าใจโมเดลปัญญาประดิษฐ์ได้ง่ายขึ้นเทียบกับโมเดลที่พารามิเตอร์มหาศาลทุกวันนี้

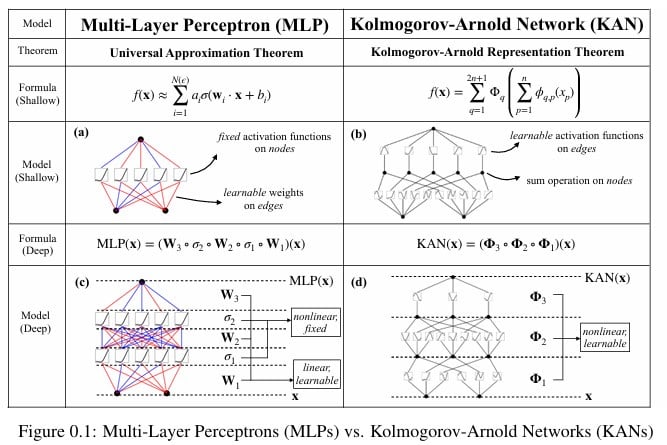

KAN เปลี่ยนแนวทางการออกแบบ neural network จากเดิมที่มอง activation function อยู่บน node และได้รับอินพุตจาก node ในชั้นก่อนหน้าขึ้นมาเป็นชั้นๆ เรียกว่า MLP (Multi-Layer Perceptrons) มาเป็นการวาง activation function บน edge ของกราฟแทน และ node ต่างๆ จะกลายเป็นการรวมค่าตรงๆ (sum)

ทีมงานสาธิตระบุว่า KAN ช่วยให้สามารถออกแบบโมเดลทำนายค่าต่างๆ ได้ความแม่นยำใกล้เคียงโมเดลเดิมๆ แต่ขนาดโมเดลเล็กลงมาก เช่น โมเดลทำนายตัวเลข MNIST โมเดล KAN สามารถทำนายได้ 98.90% ด้วยพารามิเตอร์ 94,875 พารามิเตอร์เท่านั้น เทียบกับ CNN เดิมที่ใช้ 157,000 พารามิเตอร์แล้วได้ความแม่นยำ 99.12%

ตอนนี้เริ่มมีงานวิจัยทดลองสถาปัตยกรรม KAN ออกมาเรื่อยๆ บางโมเดลสามารถทำความแม่นยำเทียบเท่าโมเดล deep learning แบบเดิมๆ ได้โดยใช้พารามิเตอร์น้อยกว่าเดิมนับพันเท่า แต่บางปัญหาก็ลดพารามิเตอร์ได้ประมาณครึ่งเดียวเท่านั้น แต่โดยรวมแล้วยังมีรายงานใหม่ๆ ถึงสถาปัตยกรรม KAN แสดงประสิทธิภาพสูงกว่าได้เรื่อยๆ

งานเหล่านี้ยังอยู่ในระดับวิจัยเท่านั้น ในความเป็นจริงการฝึกและรันโมเดล KAN จริงๆ นั้นช้ากว่าโมเดล deep learning เดิมๆ มากเพราะซอฟต์แวร์ต่างๆ ไม่ได้ออปติไมซ์สำหรับการรันบนชิปกราฟิก แต่หากในอนาคตสถาปัตยกรรมแสดงให้เห็นว่าทำงานได้เหนือกว่าจริงๆ เราก็น่าจะได้เห็นซอฟต์แวร์ต่างๆ ออปติไมซ์รองรับกันมากขึ้น

ที่มา - IEEE Spectrum

Comments

แนวคิดน่าสนใจ และลด params ลงไปได้ก็ดีเลย

มือใหม่!! ใหม่จริงๆนะ