Sakana AI บริษัทวิจัยปัญญาประดิษฐ์จากญี่ปุ่นที่มีผลงานด้าน LLM ต่อเนื่อง นำเสนองานวิจัยใหม่ ที่ฝึกให้โมเดลปัญญาประดิษฐ์เลือกจำแต่ช่วงเวลาดีๆข้อความสำคัญที่เกี่ยวข้องกับการประมวลผล และลืมข้อความที่ทำร้ายจิตใจไม่เกี่ยวข้องกับงานออกไป ทำให้การประมวลผลเร็วขึ้น แม่นยำขึ้น

แนวทางของ Sakana เสนอสถาปัตยกรรม Neural Attention Memory Models (NAMMs) ที่จริงๆ ก็เป็นโมเดลปัญญาประดิษฐ์ที่มาเลือกข้อความส่วนที่ควรลืมและควรจำ ช่วยให้โมเดล LLM หลักประมวลผลเฉพาะข้อความที่สำคัญได้

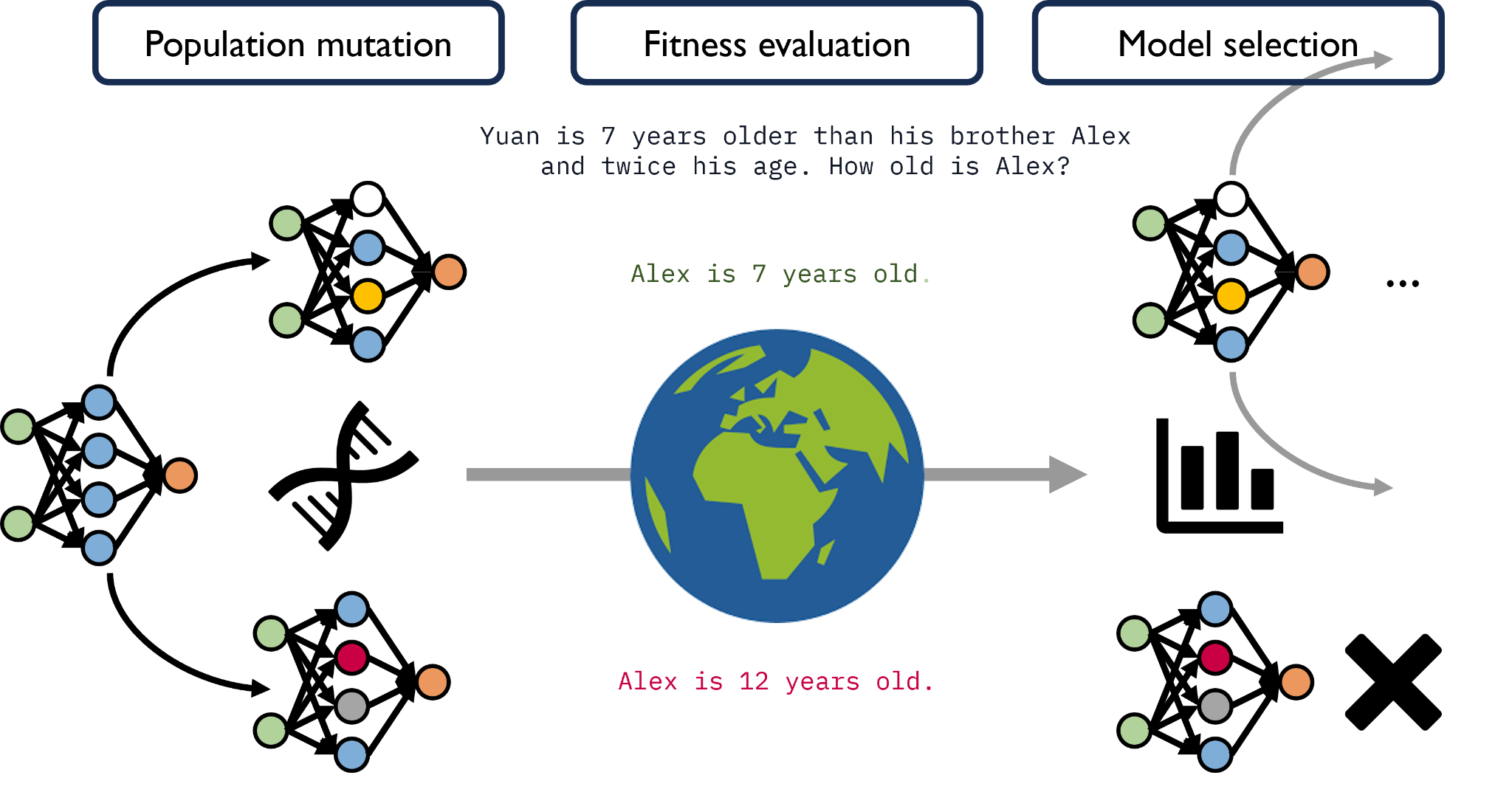

ปัญหาใหญ่ของการฝึกโมเดล NAMM คือมันใช้เลือกลืมหรือจำเท่านั้น ทีมงานพบว่าการใช้งานแบบนี้ไม่เหมาะกับการฝึกแบบ gradient-based ที่ค่อยๆ ปรับค่าพารามิเตอร์ไปเรื่อยๆ แต่ต้องการแนวทาง Evolution ที่โมเดลพารามิเตอร์ต่างๆ จะแข่งผลทดสอบกันว่าใครทำผลได้ดีกว่ากัน และผสมกันไปมาเพื่อให้ได้ผลดีที่สุด

ทีมงานทดสอบ NAMM กับ Llama 3 8B โดยทดสอบกับชุดทดสอบพรอมพ์ขนาดยาว พบว่าผลดีขึ้นมาก เทียบกับเทคนิคการประหยัดแรมอื่นๆ ที่มักทำให้ประสิทธิภาพโมเดลแย่ลง แถม NAMM ยังสามารถเลือกข้อมูลแบบ multimodal เช่น วิดีโอได้ด้วย โดยได้ผลใกล้เคียงโมเดลเดิมหรือดีขึ้น แม้จะใช้หน่วยความจำน้อยลง

ทีมงานดูแนวทางการเลือกจำและลืมของ NAMM พบว่ามันสามารถเลือกลืมข้อความที่ไม่สำคัญนัก เช่นหากข้อมูลเป็นโค้ดก็จะลืมคอมเมนต์, โค้ดโครง boilerplate ต่างๆ, หรือช่องว่าง ขณะที่หากเป็นภาษา ก็จะลืมข้อความซ้ำซ้อนออกไป

งานวิจัยนี้ได้ทุนจากกระทรวงพาณิชย์และอุตสาหกรรมของญี่ปุ่น ภายใต้โครงการ Generative AI Accelerator Challenge (GENIAC)

ที่มา - Sakana.AI