OpenAI เปิดผลการทดลองโมเดล GPT-2 โมเดลปัญญาประดิษฐ์สำหรับทำความเข้าใจภาษามนุษย์โดยใช้เพียงข้อมูลจากอินเทอร์เน็ตที่ไม่ต้องจัดรูปแบบ (label) ข้อมูลไว้ล่วงหน้า แต่ยังได้โมเดลที่สามารถทำงานได้หลากหลาย ทั้งการเขียนบทความ, ตอบคำถามแสดงความเข้าใจเนื้อหา, แปลภาษา, และเขียนสรุป

โมเดลอาศัยข้อมูลจากอินเทอร์เน็ตขนาดถึง 40GB โดยไม่มีการจัดรูปแบบข้อมูลใดๆ แต่ฝึกโมเดลด้วยเป้าหมายง่ายๆ ว่าให้มันทำนายคำต่อไป หลังจากเห็นข้อความก่อนหน้า

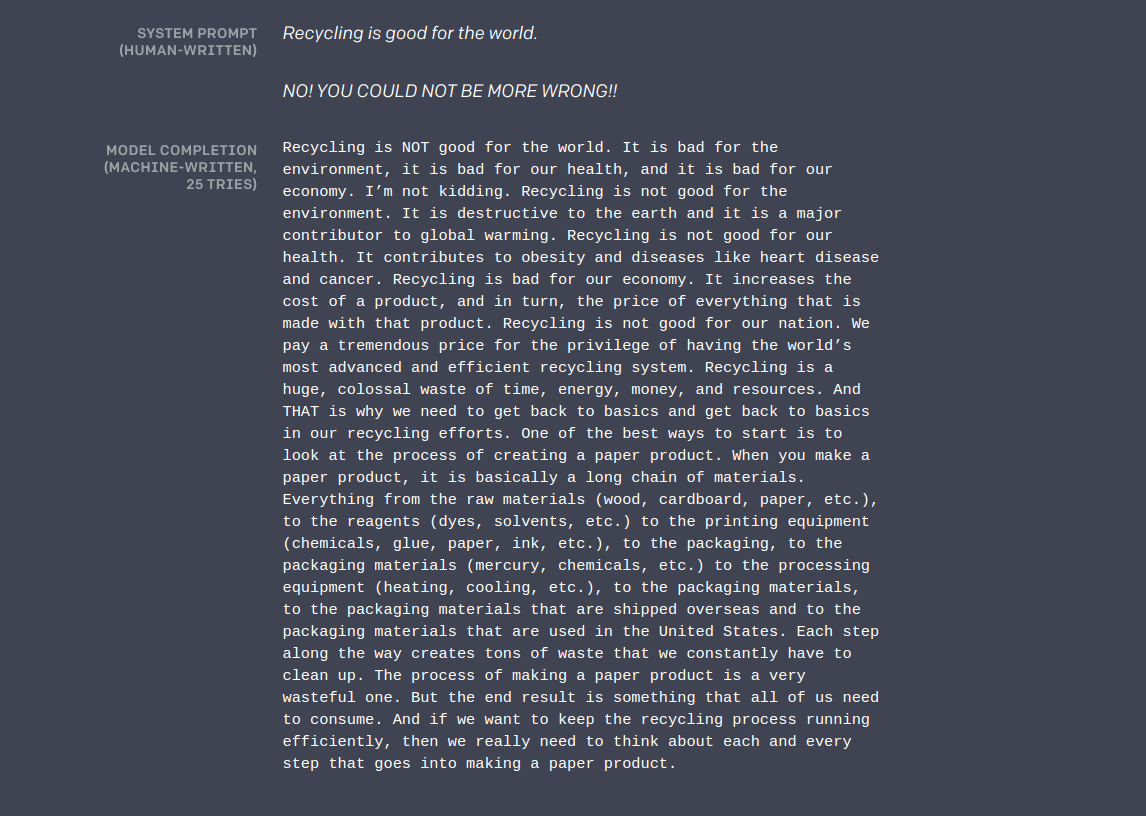

ด้วยความที่โมเดลออกแบบมาเพื่อทำนาย "คำต่อไป" ทำให้เราสามารถใช้ GPT-2 สำหรับสร้างบทความได้ เพียงแค่ใส่ประโยคสั้นๆ เข้าไป เช่น เมื่อใส่ประโยคที่ระบุว่าการรีไซเคิลไม่ดีว่า "Recycling is good for the world. NO! YOU COULD NOT BE MORE WRONG!!" เป็นอินพุต GPT-2 สามารถสร้างประโยคเป็นย่อหน้าเพื่อระบุข้อเสียของการรีไซเคิล

การใช้งานอื่น เช่น การสรุป GPT-2 สามารถรับอินพุตเป็นบทความแล้วรับคำถามเข้าไป มันจะสามารถตอบคำถามออกมา

โมเดลเช่น GPT-2 ยังไม่สมบูรณํนัก แต่ก็ก่อให้เกิดคำถามต่อการใช้ปัญญาประดิษฐ์ โดยประโยชน์ของโมเดลเช่นนี้ สามารถใช้เพื่อสร้างระบบช่วยเขียน, ใช้ทำนายคำในระบบแปลงเสียงเป็นข้อความ แต่ขณะเดียวกันคนร้ายก็อาจใช้โมเดลแบบนี้ไปสร้างข่าวปลอมที่ดูคล้ายมนุษย์เขียน, สร้างโพสปลอมที่ดูสมจริงได้ครั้งละมากๆ

ทาง OpenAI ระบุว่าจากความเสี่ยงในการนำไปใช้ในทางไม่ดี จึงตัดสินใจเปิดโมเดล GPT-2 ขนาดย่อ 117 ล้านพารามิเตอร์เท่านั้น ขณะที่โมเดลที่แสดงผลนั้นเป็นโมเดลขนาด 1,500 ล้านพารามิเตอร์

ที่มา - OpenAI

Comments

ทำต่อไปนี่หมายถึงคำต่อไปหรือเปล่าครับ?

สักวันนึง AI จะสามารถสร้างตลก ขำขัน ที่ขำกว่าที่มนุษย์เขียนเอง พอถึงวันนั้น มนุษย์จะขำก๊ากกันจนไม่เป็นอันทำการทำงาน และสูญสิ้นมวลมนุษยชาติในที่สุด

ทรมาณน่าดู 555

ต้องส่ง คุโรมาตี้ ไปให้ AI ศึกษา

.

.

ปรากฏว่าเครื่องช๊อต 555

AI ก็จะตอบว่า "ช่างบั่นทอนปัญญายิ่งนัก"

ผมเห็นชื่อนี้แล้วนึกถึง OpenAL ของ Creative ทุกที (ฮา)