XDA Developers ทำการทดสอบฟีเจอร์การแปลสดที่ Google ยังไม่เปิดตัว ในมือถือซีรีส์ Google Pixel 6 ต่อยอดจากฟีเจอร์ Live Caption โดยเป็นการใช้ชิป Tensor แปลภาษาทันทีจากแหล่งต่างๆ ทั้งแอป Message, Live Caption และกล้องถ่ายภาพ

XDA Developers เห็นฟีเจอร์นี้จากแหล่งข่าวไม่เปิดเผยตัวตน ผู้ได้ลองใช้ Pixel 6 Pro ก่อนวางจำหน่าย พบว่าภายในโทรศัพท์มีแอป Android System Intelligence ที่รวมฟีเจอร์ใหม่ไว้

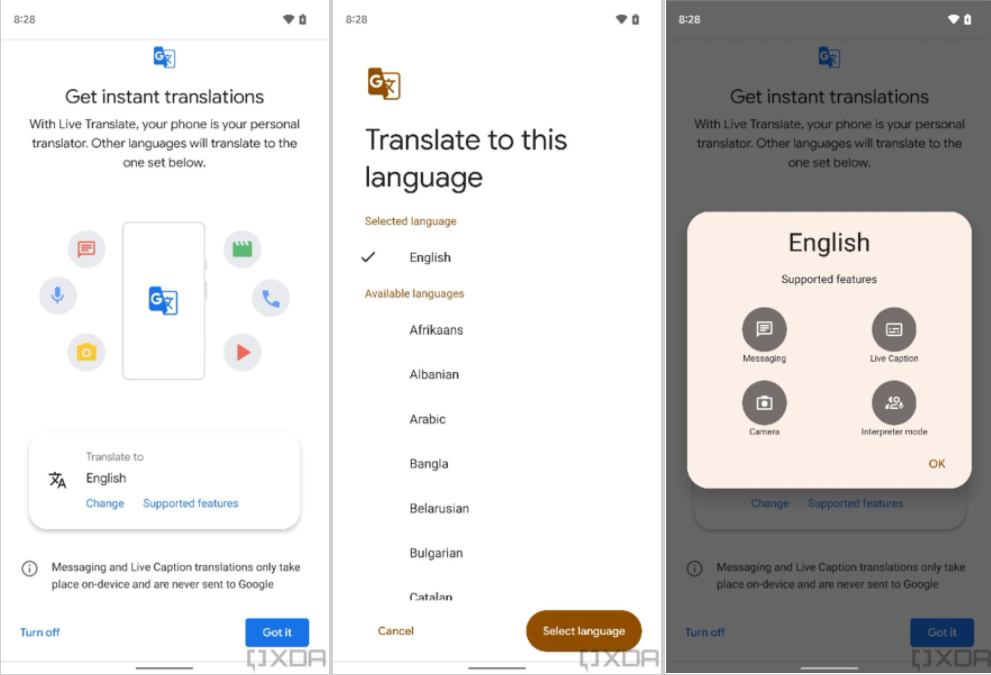

XDA Developers ยังพบว่านอกจากแปลแคปชั่นสดแล้ว Live Translate จะสามารถแปลข้อความในแอป Messaging แปลภาพจากกล้องในสไตล์ Google Lens (แต่ยังไม่แน่ชัดว่าจะเพิ่มมาในแอป Camera เลยหรือเปล่า) และแปลภาษาพูดแบบใน Google Pixel Buds ได้อีกด้วย โดยผู้ใช้อาจต้องโหลดแพ็กเกจภาษาต่างๆ เพิ่ม ก่อนใช้งานได้แบบออฟไลน์

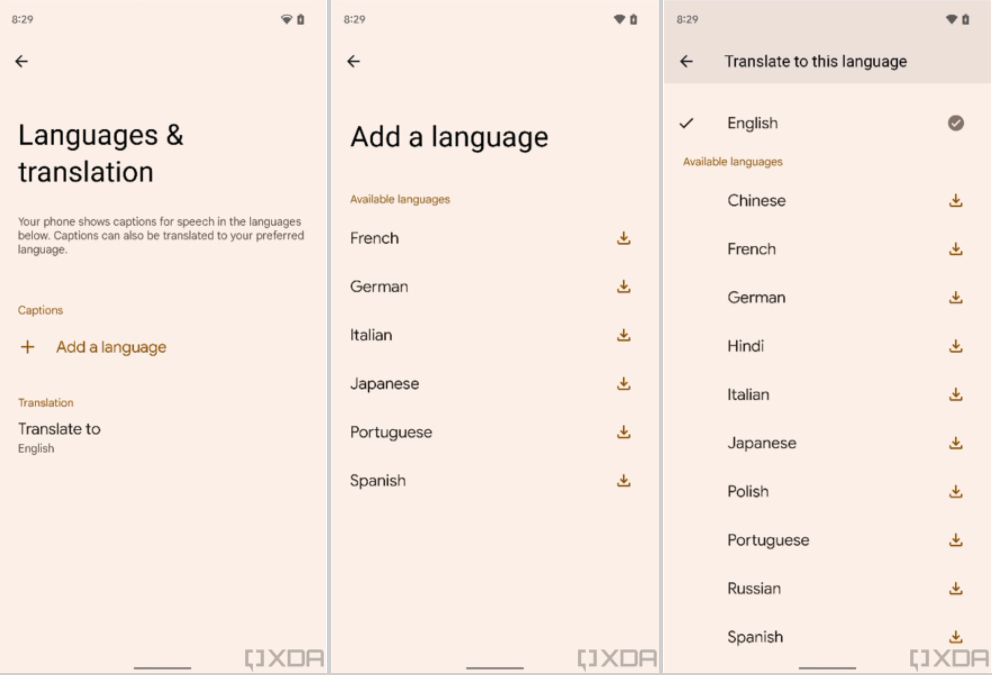

ส่วนการแปลแคปชั่นแบบสด ผู้ใช้จะต้องเปิดใช้งาน Live Caption ก่อน ซึ่งใน Android 12 บน Pixel 6 Pro จะแยกไปอยู่ในหมวดตั้งค่า “Languages & translation” และหากดูจากการตั้งค่าแบบใหม่แล้ว Live Caption น่าจะรองรับภาษาเพิ่มเติม เช่น ฝรั่งเศส, เยอรมัน, อิตาลี, ญี่ปุ่น, โปรตุเกส, และสเปน

Live Translate น่าจะเป็นอีกฟีเจอร์ที่โชว์พลังการทำงานของชิป Tensor ในด้านการประมวลผลแมชชีนเลิร์นนิ่งในเครื่องได้แบบทันที ส่วนประสิทธิภาพเมื่อใช้งานจริงจะเป็นอย่างไร คงต้องติดตามหลัง Google Pixle 6 เปิดตัว ช่วงฤดูใบไม้ร่วง หรือเดือนกันยายน-พฤศจิกายนนี้

ที่มา - XDA Developers

Comments

ทำไมกูเกิลพยายามผลักดัน AI ตัวแปลภาษาจังเลยนะ เข้าใจว่ามีประโยชน์แต่รู้สึกค่อนข้างไกลตัว น่าจะมีประโยชน์ตอนไปเที่ยวต่างประเทศนะ แต่ในชีวิตประจำวันต้องแปลกันขนาดนั้นเลยหรอหว่า

คนที่อยู่ในต่างประเทศได้ใช้เยอะครับ อย่างในยุโรป 1 เมืองอาจเจอคนพูดอยู่ 5 ภาษาก็ได้

คนอื่นไม่รู้นะ แต่ส่วนตัวผมจะเอาไว้อ่าน/ฟัง content ภาษาญี่ปุ่น อิๆ

ปลายทางแล้วคือ Google จะได้เข้าใจว่า "คุณต้องการอะไร"

ไม่ว่าจะพูดด้วยภาษาอะไรหรือพิมพ์หรือคิด

ทาง Google จะได้นำเสนอโฆษณาให้ตรงกับความต้องการของลูกค้ามากที่สุด

+1

+1

Google mindreader when

ผมโดนหลายรอบละครับ เคยอ่านข่าวภาษา Rust ใน bn แค่คิดเฉยๆว่า helloworld in ASM เขียนยังไง ไม่กี่นาทีหลังจากนั้นผมเข้า youtube มันก็โผล่มาเลย เทพจริง

ขอ api ผ่าน neuralink