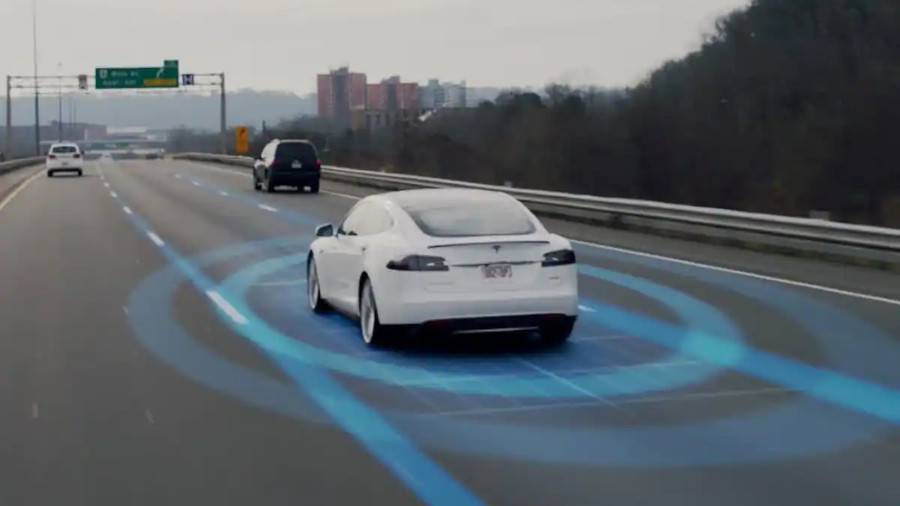

The Washington Post มีบทความวิเคราะห์ปัญหา Full Self-Driving (FSD) ของ Tesla ที่เกิดอุบัติเหตุบ่อยครั้ง จนถูกหน่วยงานความปลอดภัยทางหลวงของสหรัฐ NHTSA สั่งให้เรียกคืน (recall) เพื่ออัพเดตซอฟต์แวร์

แหล่งข่าวของ The Washington Post มาจากการสัมภาษณ์อดีตพนักงานและผู้เกี่ยวข้องหลายราย ซึ่งพูดตรงกันว่าสาเหตุหลักมาจากการที่ Elon Musk ตัดสินใจเลิกใช้ระบบเรดาร์เพื่อลดต้นทุน เปลี่ยนมาใช้กล้องอย่างเดียว ทำให้ระบบ FSD ไม่สามารถตรวจจับวัตถุรอบรถได้ดีพอ

ข้อดีของเรดาร์คือสามารถตรวจจับวัตถุใหญ่ๆ อย่างรถไฟหรือรถบรรทุกได้เสมอ แม้ไม่รู้ว่ามันคืออะไรก็ตาม แต่กล้องที่เป็นการวัดแสงเหมือนที่ตามองเห็น (vision) ต้องนำภาพไปตีความโดยหน่วยประมวลผลก่อนเสมอ ทำให้การตรวจจับผิดพลาดบ่อยครั้ง (เช่น กรณีวิ่งไปชนรถฉุกเฉินที่จอดอยู่ตรงไหล่ทาง) และเกิดอาการที่เรียกว่า "เบรกทิพย์" (phantom braking) จู่ๆ รถยนต์ก็ลดความเร็วลงเองแม้ไม่มีวัตถุใดๆ อยู่รอบรถเลย

หากดูจากสถิติ Tesla ถูกร้องเรียนเรื่องอุบัติเหตุของ FSD รวมถึง "เบรกทิพย์" เพิ่มขึ้นมากหลังออกอัพเดต FSD ที่เปลี่ยนมาใช้กล้องอย่างเดียว ผู้เชี่ยวชาญของ NHTSA ให้ความเห็นว่าสาเหตุมาจากการตัดเรดาร์ออกเป็นหลัก เพราะเรดาร์จะสามารถตรวจจับวัตถุที่อยู่ในระยะไกลได้ดีกว่า ถือเป็นตัวช่วยตรวจสอบความแม่นยำของกล้องอีกชั้น

We have to solve a huge part of AI just to make cars drive themselves. In retrospect, it was inevitable. The road system is designed for cameras (eyes) & neural nets (brains).

— Elon Musk (@elonmusk) February 5, 2022

นอกจากเรื่องการตัดเรดาร์เพื่อลดต้นทุนแล้ว กระบวนการพัฒนาของ Tesla ก็ยังมีปัญหาด้วย เพราะแนวทางการนำงานของ Elon Musk คือเร่งพัฒนาเทคโนโลยี แล้วนำไปให้ผู้คนลองใช้งานก่อนเทคโนโลยีมีความพร้อม ในอีกด้าน Elon ก็ขยันโพสต์โฆษณาว่าเกือบทำสำเร็จแล้ว ทั้งที่จริงๆ งานยังไม่คืบหน้าไปจากเดิมสักเท่าไร แถมวัฒนธรรมองค์กรที่ "Elon เป็นใหญ่" ทำให้พนักงานที่กล้าเถียงมักโดนไล่ออก

John Bernal อดีตพนักงานทดสอบ FSD ที่ถูกไล่ออกในปี 2022 ให้ความเห็นว่า เดิมที Elon ก็ทำงานแบบนี้มานานแล้ว แต่ไปเล่าใครก็ไม่มีใครเชื่อ จนกระทั่ง Elon มาบริหาร Twitter คนถึงได้รู้ว่าเขาเป็นอย่างไร และผลงานของ Elon ที่ Twitter เป็นเพียงยอดภูเขาน้ำแข็งของที่ Tesla เท่านั้น ในบทความยังพูดถึงบริษัท Tesla ติดตั้งซอฟต์แวร์มอนิเตอร์การทำงานของพนักงานแปะป้ายให้ภาพ (image labeling) เพื่อเตรียมข้อมูลก่อนเทรนโมเดล หากพนักงานไม่ขยับเมาส์ตามระยะเวลาที่กำหนดจะถือว่าอู้งาน และมีบทลงโทษตามมา

FSD Beta has now been expanded to ~2000 owners & we’ve also revoked beta where drivers did not pay sufficient attention to the road. No accidents to date.Next significant release will be in April. Going with pure vision — not even using radar. This is the way to real-world AI.

— Elon Musk (@elonmusk) March 12, 2021

แนวทางการทำงานของ Elon ยังพยายามรวมทีมวิศวกรซูเปอร์สตาร์เข้าด้วยกัน ให้ทำงานหนัก และเขาเป็นผู้ทดสอบซอฟต์แวร์เวอร์ชันล่าสุดด้วยตัวเอง แล้วทำ "รายการแก้ไข" (fix-it requests) ส่งกลับไปยังทีมวิศวกร แนวทางนี้อาจช่วยให้ระบบดูคืบหน้า แต่เอาจริงเป็นการปะผุ อุดรอยรั่วโดยไม่มีแผนยุทธศาสตร์ภาพใหญ่ ต่างจากแนวทางของคู่แข่งอย่าง Waymo ที่มีโปรโตคอลการทดสอบความปลอดภัยอย่างเข้มงวดกว่า ยังไม่รวมถึงเทคโนโลยีเซ็นเซอร์ที่ใช้ทั้ง radar/lidar คู่ไปกับกล้องด้วย

ตัวอย่างหนึ่งของการปะผุของ Tesla คือในปี 2021 มียูทูบเบอร์ช่อง Tesla Raj ลองนำรถไปขับบนถนนซิกแซก Lombard Street ที่โด่งดังของเมืองซานฟรานซิสโก ปรากฎว่ารถยนต์ Tesla มีปัญหา เหตุการณ์จากคลิปนี้ทำให้วิศวกรของ Tesla "ออกแพตช์แก้" สร้างบาเรียที่มองไม่เห็นมาป้องกันไม่ให้รถไปชนขอบถนน Lombard Street

อดีตผู้บริหาร Tesla รายหนึ่งให้สัมภาษณ์ว่าการแก้บั๊กตามคำสั่งของ Elon เปรียบเสมือนโดนเสือวิ่งไล่ ซึ่งคนที่โดนเสือวิ่งไล่ไม่มีทางนำเสนอทางแก้ดีๆ ในระยะยาวได้หรอก

การที่ Elon หันไปสนใจเรื่อง Twitter ยังทำให้เขาให้ความสำคัญกับ Tesla น้อยลงตามไปด้วย วิศวกรของ Tesla จำนวนมากถูกโยกไปทำงานให้ Twitter แทน ผลคือกระบวนการพัฒนาช้าลง อัพเดตที่เคยออกทุกสองสัปดาห์ ยืดเวลากลายมาเป็นหลักเดือนแทน พนักงานบางคนเลือกลาออกไปอยู่กับ Waymo เพราะ "อย่างน้อยก็ไม่ต้องเป็นห่วงว่ารถหยุดที่ป้ายหยุดจริงๆ หรือเปล่า"

ลูกค้าที่จ่ายเงินซื้อระบบ FSD ในราคาแพง 15,000 ดอลลาร์ ก็ไม่พอใจที่ Tesla ไม่สามารถทำได้อย่างที่ Elon เคยสัญญาไว้ ลูกค้ารายหนึ่งที่เป็นเจ้าของ Model Y บอกว่าคนซื้อ FSD คาดหวังว่าตอนนี้รถยนต์ของตัวเองควรขับได้เองเป็น robotaxi ได้แล้ว แต่ความจริงมันก็ไม่ใช่แบบนั้น

ที่มา - The Washington Post

Comments

เห็นด้วยตามข่าวแหละครับ ดูจากแนวทางการบริหาร twitter แล้ว

ปล...แสดงว่าแกคิดว่ามันเวิคที่เทสล่า เลยจะเอามาใช้ที่ twitter ด้วย

งั้นที่ SpaceX รอดนี่หรือว่าช่วงนั้น Elon ใช้เวลาส่วนใหญ่มาโฟกัสที่ Tesla

มองว่ามันเทียบกันไม่ค่อยได้อะครับ

ระหว่างจรวด กับรถ

กับจรวดไม่น่าจะงานรีบมากเท่านะครับเพราะรีบมากไม่ได้ลูกค้าไม่ใช่คนปกคิแต่เป็นองค์กรความเชื่อมั่นสำคัญที่สุด

ผมรู้สึกว่าเค้าไม่ cut-the-corner กับ SpaceX เพราะบริษัทเป็นคนต้องรับผิดชอบกับความเสียหายที่จะเกิด แต่กับรถยนต์ Tesla เค้าลดต้นทุนกับฟีเจอร์ที่ "คุยโม้" ไว้เยอะ ซึ่งความเสียหายที่เกิดจากการที่ผู้ใช้ไว้วางใจฟีเจอร์ที่ "โม้" ไว้เยอะ โดยที่ Tesla ไม่ต้องรับผิดชอบไง

มี NASA คอยคุมอยู่ครับ จะโม้อะไรเค้าไม่สนใจ มี checklist อยู่แล้วว่าต้องตรวจอะไรบ้าง

เออจะว่าไปพวกแว่น VR ไม่ใช้ sensor ตรวจจับคลื่นกับเขาบ้าง

มัวแต่ใช้ Image Processing อยู่ ช้า, error เยอะ, เปลือง resource อีก

ตามหาแฟนบอยที่ชอบคอมเม้นต์ว่ากล้องดีกว่าเซ็นเซอร์ครับ แถวๆนี้แหละ😒

555 ผมก็ไม่เห็นด้วยที่ว่ากล้องดีกว่า lidar ในบาง case นะ เช่น การวัดระยะยังไม่แม่นเลย

ระบบควรมีมากกว่า 1 ในการช่วยตัดสินใจในสถานการณ์ต่างๆ ด้วยจะดีกว่า

มือใหม่!! ใหม่จริงๆนะ

Musk + อัจฉริยะ = Muskฉริยะ

โห ล้ำแฮะ คิดได้เนอะ

Muskฉริยะ = ตระหนี่

รถใหม่ๆก้เอาเรดาห์ออกไปแล้วนิครับ

subaru eye sight4 ก็ไม่มีนะ แม่นเวอร์ๆ

เห็นค่ายรถเอาออกกันหมดละใช้กล้อง ADAS กันหมด ผมนึกว่าเรดาห์มันมีความแม่นยำต่ำซะอีก

เวลาเขานำเสนอไม่มีใครเอา Worst case มานำเสนอหรอกครับ ลองอ่านบทความนี้ดีๆ คุณก็จะเห็นว่า Lidar มันจำเป็นเมื่อระบบที่ใช้กล้องไม่สามารถทำงานได้ทัน โดยเฉพาะสภาพแสงน้อยมาก รวมถึงสภาวะที่วัตถุเข้ามาในแนวเฉียงกระทันหัน ซึ่งตัววัตถุยังไม่แสดงพื้นที่ตรวจจับชัดเจน ซึ่งตรงนี้เป็นจุดอ่อนของระบบกล้องทุกตัว ระบบกล้องมันมีจุดอ่อนเยอะครับ ถ้าจะเอาแบบปลอดภัยในระดับ Auto Pilot ยังไงก็ต้องมี Lidar เข้าช่วย ระบบตามนุษย์มันมองเป็น 3 มิตินะครับ แต่กล้องมันมองเป็น 2 มิติ ถึงจะมี 2 กล้องช่วยในการวัดระยะ แต่คุณมั่นใจได้ยังไงว่า processor มันจะประมวลผลทันในสภาวะแวดล้อมเลวร้าย นี่ยังไม่รวมกรณีที่พบวัตถุไม่มีระบุในฐานข้อมูลในการสร้าง Model ตรวจจับ ทำให้ต้องตัดเข้าเคสเหยียบเบรคกระทันหันทั้งที่ไม่พบวัตถุอันตราย เหมือนคุณเขียน else everything exception นั่นแหล่ะ

กล้อง2ตัวขึ้นไป ก็มองเป็น3Dได้นะครับ ติดมากกว่า2 ก็ดีกว่าตาคนแล้ว

ปัญหาหลักๆ น่ามาจาก object detection มากกว่า

จริงหรือครับที่กล้องมันทำงานดีกว่าตามนุษย์ ? ลองยกตัวอย่างกล้องที่สามารถประมวลผลวัตถุภายใต้แสงเทียนภายในเวลาเสี้ยววินาทีให้ผมซักตัวสิครับ เอาแบบไม่ต้องเปิดหน้ากล้องนานๆ นะครับ มีกล้องแบบไหนไหมครับที่สามารถรับภาพชัดโดยมีมุมมองกว้างโดยไม่มีปัญหาทางขอบภาพ มีกล้องตัวไหนไหมครับที่สามารถติดตามวัตถุแบบ real-time โดยไม่ต้องประมวลผลทั้งภาพได้บ้าง มีกล้องแบบ 2 ตัวแบบไหนบ้างที่สามารถจับพื้นผิวถนนที่ไม่มีเส้นอ้างอิง หรือสามารถจับเส้นทางในป่าที่ไม่มีแนวเส้นชัดเจนได้่บ้าง ? เป็นคำถามปลายเปิดนะครับ ไม่จำเป็นต้องตอบก็ได้ ถ้าจะตอบก็เอาเฉพาะประโยชน์ใช้สอยเกี่ยวกับ Computer Vision เป็นหลักนะครับ จะได้เป็นวิทยาทานกับผมด้วย

เรื่องที่คุณยกมาส่วนใหญ่ มันเป็นเรื่องของการประมวลผลมากกว่าข้อจำกัดทางกายภาพของกล้องนะครับ

ถ้าพูดถึงในเชิงกายภาพ ผมมองว่ากล้องมันทำงานได้ดีกว่าตาคน (หมายถึงมันสามารถรับข้อมูลได้มากกว่าตาคน) ไม่ว่าจะแสงน้อยหรือมุมกว้างก็ตาม (พูดถึงเทคโนโลยีกล้องโดยรวมนะครับ ไม่ได้หมายถึงกล้องของรถยนต์) ยิ่งถ้าเพิ่มจำนวนกล้องก็ยิ่งทำได้ดีกว่าตาคนยิ่งขึ้นไปอีกครับ

ทว่า สิ่งที่มันด้อยกว่าคนคือการประมวลผลหลังจากนั้น (หรือก็คือการจัดการกับข้อมูล) ซึ่งสมองคนเราทำได้ดีกว่าเยอะ ตามที่คุณว่ามานั่นแหละครับ

มีกล้อง digital ตัวไหนไม่ต้อง process ข้อมูลด้วย chip ด้วยหรือครับ หรือว่ามันรับแสงเฉยๆ แล้วเอามาใช้ได้เลย ? ไม่ได้แกล้งโง่ แต่กำลังงงที่คุณกำลังอธิบาย ผมอาจจะเข้าใจอะไรยากสักหน่อยนะครับ บอกเอาไว้ก่อน เดี๋ยวจะหาว่าไปกวนอวัยวะเบื้องล่าง

เรากำลังคุยเรื่อง "ตาของมนุษย์" อยู่ครับ

ซึ่งตานั้น ทำหน้าที่แค่แปลงคลื่นแสงเป็นสัญญาณ และส่งไปยังสมองแค่นั้น

ถ้าให้เปรียบกับกล้อง มันก็แค่เลนส์กับเซนเซอร์เท่านั้นครับ (ซึ่งผมต้องการจะสื่อว่าสองอย่างนี้มันเหนือกว่าตาเราแล้ว)

ส่วน chip หรือ software เพื่อ process รูปใดๆ ถ้าให้เปรียบกับร่างกายมนุษย์ มันคือสมองครับ (ซึ่งเราทุกคนเห็นตรงกันว่ามันยังสู้มนุษย์ไม่ได้)

Subaru ก็มีเบรกผีบ่อยครับ แล้วถ้าทัศนวิสัยแย่มันก็ตัดระบบทิ้งให้ขับเองครับเช่นฝนตกหนัก ๆ แล้วก็ไม่ได้เครมว่าเป็นระบบขับขี่อัตโนมัติ แต่เป็น ACC ครับ

เจ้าใหญ่อย่าง Toyota กับ Honda

ก็ยังใช้อยู่ที่ใช้กล้องอย่างเดียว

ผมก็เห็นแค่ Subaru ที่โปรโมท

และเหตุผลก็ยอมรับมาตรง ๆ

เลยว่าเป็นเรื่องของการลดต้นทุน

เจ้าอื่นไม่มีใคร promote ว่าเป็น FSD นะครับ ส่วนมากบอกว่าเป็น feature ช่วยสนับสนุนการขับขี่เท่านั้น

That is the way things are.

ถ้าพูดถึงความแม่นยำ... ส่วนตัวผมมองว่า Active Sensor (ยิงคลื่นออกไปก่อน) อย่างเรดาร์ มันมีโอกาสที่จะโดนรบกวนหรือคลาดเคลื่อนและทำงานผิดพลาดได้ ต่างจาก Passive Sensor ที่รับคลื่นอย่างเดียวอย่างกล้องครับ เพราะงั้นถ้าต้องเลือกตัวใดตัวหนึ่งเท่านั้น ส่วนตัวผมก็เลือก Passive นะครับ

แต่มันก็ไม่มีอะไรเพอร์เฟคหรอกครับ ทุกอย่างสามารถทำงานผิดพลาดได้ทั้งนั้น เพราะงั้นผมมองว่าเราไม่ควรพึ่งพาเพียงระบบเดียวเท่านั้น แต่ควรใช้หลายๆระบบให้มันทำงานร่วมกัน จะได้ลดข้อผิดพลาดให้เหลือน้อยที่สุดนั่นแหละครับ

radar น่าจะใช้การประมวลผลน้อยว่า Image processing เป็นล้านเท่าครับ

ดูสงครามสมัยก่อนไม่มี processor แรงๆ เหมือนปัจจุบัน radar ก็ยังใช้ได้เลย

เอาจริงๆผมมองว่ากล้องจับภาพโดยรวมก็ดีกว่าเรดาร์นั่นแหละ

จุดสำคัญคือถ้ามีทั้งคู่มันก็ช่วยกลบจุดบอดของอีกอันนึงได้

แต่มันเปลืองงบเค้าเลยต้องตัดออกอันนึง

ซึ่งแน่นอนเค้าก็ต้องตัดสิ่งที่จำเป็นน้อยกว่าออกไป

ตรงนี้ผมว่าถ้าคิดว่ามันเปลืองงบนักก็เพิ่มเป็นoptionเสริม

ให้คนสามารถเลือกติดเพิ่มเองไปเลยได้มั้ยละ

คนที่ต้องการความปลอดภัยมากขึ้นเค้าก็ยอมจ่ายแหละ

ผู้บริหารไอดอลของใครหลายๆคน สภาพแบบแรงงานนรกจัด

ใครชอบๆก็ขอให้ได้ทำงานในบริษัทที่มีบอสแบบนี้นะ

อย่าให้รู้ว่าเจอแล้วลาออกไปหางานใหม่