เก็บตกของใหม่จากงาน Microsoft Build 2023 ที่สำคัญต่อการรันโมเดล AI บนพีซีวินโดวส์ โดยไมโครซอฟท์ประกาศรองรับ ONNX Runtime บนวินโดวส์ และเปิดให้แอพตัวอื่นๆ ใช้งาน

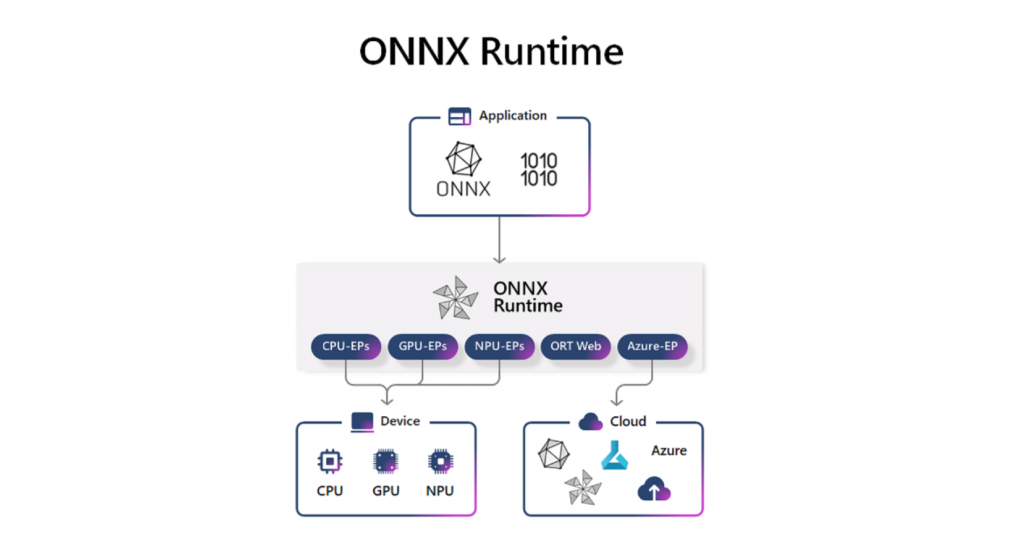

Open Neural Network Exchange (ONNX) เป็นโครงการฟอร์แมตกลางของโมเดล AI ที่ไมโครซอฟท์กับเฟซบุ๊กร่วมกันทำในปี 2017 และมีสมาชิกเข้าร่วมมากขึ้นเรื่อยๆ แม้แต่แอปเปิลยังเข้าร่วม (แต่กูเกิลไม่เข้า เพราะ ONNX อิงกับ PyTorch เป็นหลัก) ส่วน ONNX Runtime คือซอฟต์แวร์ที่ช่วยให้รันโมเดลในฟอร์แมต ONNX บนแพลตฟอร์มต่างๆ ได้

ที่ผ่านมาไมโครซอฟท์เน้นการรันโมเดล AI ที่ฝั่งเซิร์ฟเวอร์คือเครื่องของ Azure เป็นหลัก ข่าวนี้คือฝั่งไคลเอนต์วินโดวส์รองรับการรันโมเดล ONNX ผ่าน ONNX Runtime แล้ว, ออกเครื่องมือชื่อ Olive คอยบีบอัดโมเดลมารันบนพีซี และแอพค่ายอื่นที่ไม่ใช่ไมโครซอฟท์สามารถสั่งรันโมเดล AI ภายในเครื่องพีซี (on-device) ได้ด้วย โดยใช้ API ตัวเดียวกับฝั่งเซิร์ฟเวอร์เลย

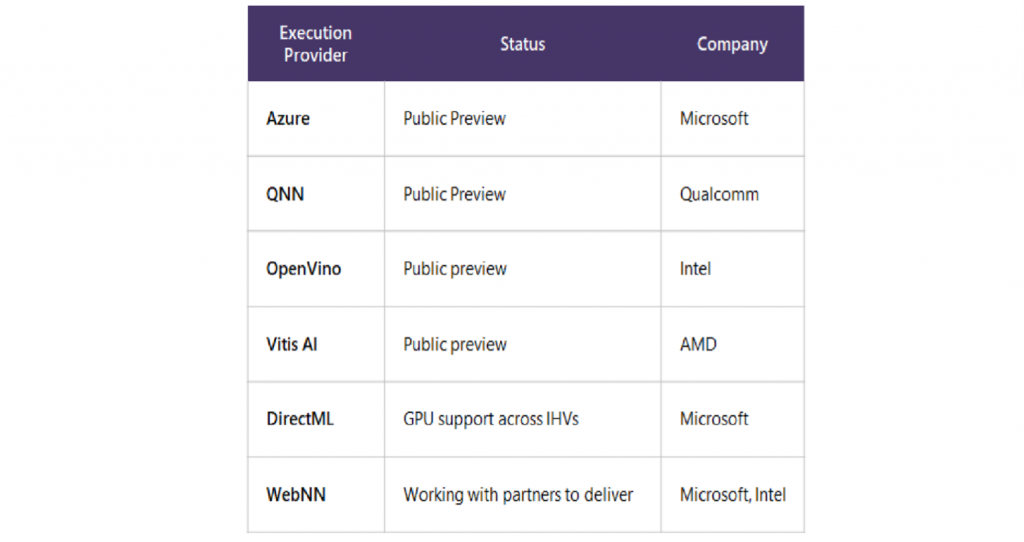

การรันโมเดลบนวินโดวส์ ยังสามารถใช้ประโยชน์จากฟีเจอร์เร่งการประมวลผล AI ในซีพียู จีพียู หรือ NPU ได้ด้วย ซึ่งไมโครซอฟท์ก็ประกาศความร่วมมือกับผู้ผลิตฮาร์ดแวร์ 3 รายคือ AMD (ซีพียู Ryzen บางรุ่น), NVIDIA (Tensor Core ในการ์ด RTX), Qualcomm (NPU ใน Snapdragon 8cx Gen 3) ให้รองรับฟีเจอร์นี้แล้ว

กรณีของ Qualcomm โชว์การรันโมเดลสร้างภาพ Stable Diffusion ขนาด 1 พันล้านพารามิเตอร์บน Snapdragon ล้วนๆ ได้แล้ว และบอกว่าจะสามารถรันโมเดลขนาด 10 พันล้านพารามิเตอร์ได้ด้วยเช่นกัน

ไมโครซอฟท์ยังบอกว่าแอพดังๆ อย่าง WhatsApp, Luminar Neo, Camo เริ่มใช้งานฟีเจอร์ ONNX Runtime เพื่อรันโมเดลในแอพของตัวเองแล้ว และจะมีแอพอื่นๆ ตามมาในภายหลัง

ที่มา - Microsoft (1), Microsoft (2)