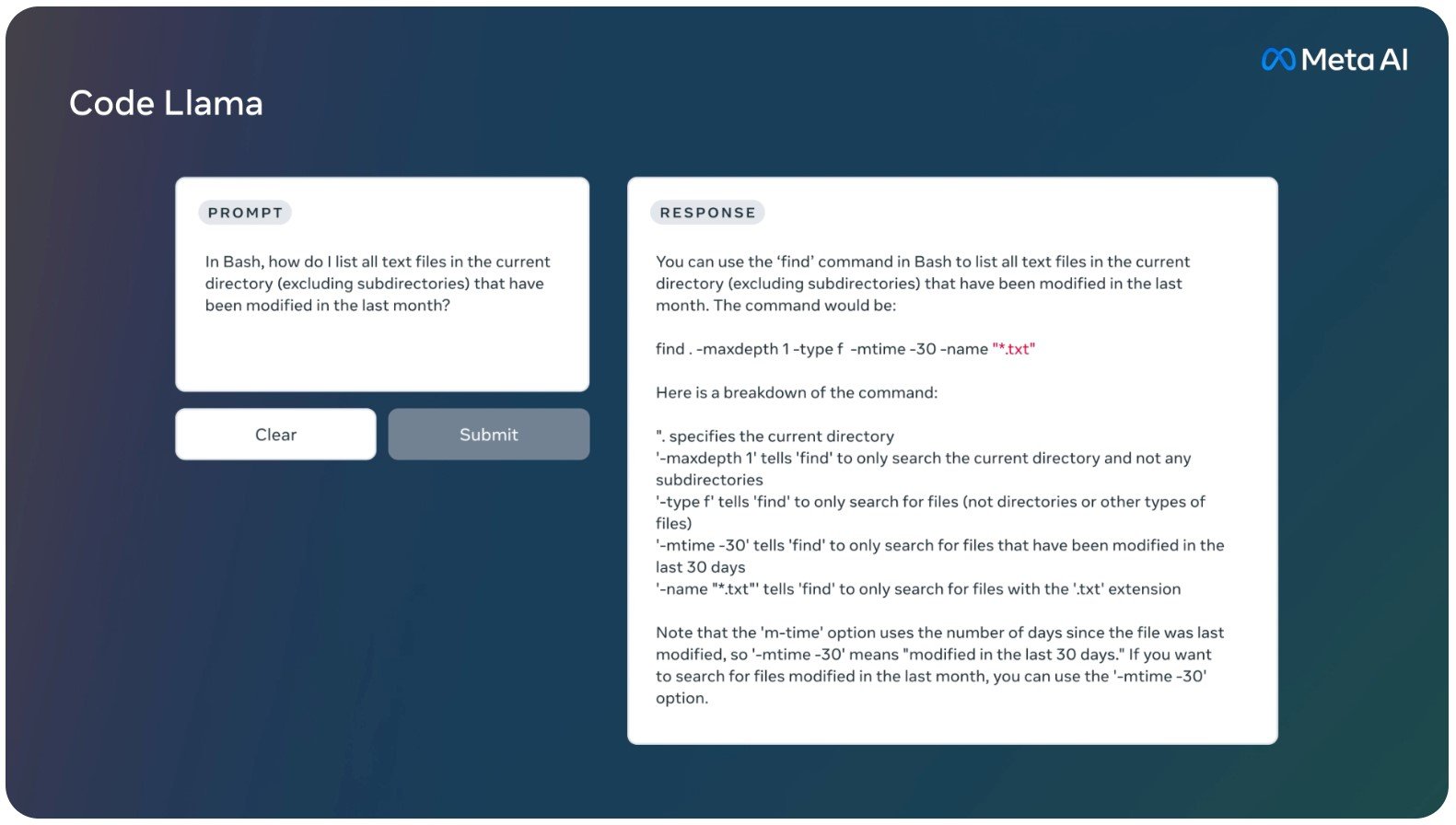

Meta ปล่อยโมเดล Code Llama ขนาด 70B หลังจากปีที่แล้วปล่อยรุ่นใหญ่สุดอยู่ที่ 34B เท่านั้น โดยตอนนี้ยังไม่บอกรายละเอียดนัก นอกจากระบุว่าคะแนนทดสอบ HumanEval อยู่ที่ 67.8 แซงหน้า GPT-4 (67.0) และ Gemini Pro (67.7) โดยระบบอื่นๆ ที่ได้คะแนนสูงกว่านี้มักใช้ GPT-4/GPT-3.5 ร่วมกับเทคนิคอื่นๆ เพื่อให้ทำคะแนนได้สูงขึ้น

โมเดลที่ปล่อยออกมามี 3 รุ่นย่อย ได้แก่ รุ่นพื้นฐานสำหรับใช้งานทั่วไป, รุ่นภาษาไพธอนโดยเฉพาะ, และรุ่น Instruct สำหรับรับคำสั่งเพื่อเขียนโปรแกรมตาม รุ่นที่รายงานคะแนน HumanEval นั้นคือรุ่น Instruct

โมเดลเหล่านี้ใช้งานได้ฟรีแบบมีข้อจำกัด โดยห้ามใช้งานกับองค์กรที่มีผู้ใช้เกิน 700 ล้านคนต่อเดือน

ที่มา - AI at Meta, Hugging Face

Get latest news from Blognone

Follow @twitterapi

Comments

องค์กรที่มีผู้ใช้เกิน 700 ล้านคนต่อเดือนนี่ต้องเป็นองค์กรระดับไหนนะ

ตอนแรกก็อ่านแล้วสงสัยว่าทำไมต้องไม่เกิน 700 ล้านคนต่อเดือน

จงใจ Block Apple / Google / Microsoft นี่เอง

def check_term_condition():

if active_users_per_month > 700 or org_name.lower() in ['apple', 'google', 'microsoft', 'amazon']:

return False

return True

..: เรื่อยไป

Microsoft คงไม่มีปัญหานะครับ https://www.blognone.com/node/134904 ได้ยินว่าเริ่มเอา LLaMa ไปใช้คู่กับ openai แล้วด้วย ที่มีปัญหาน่าจะอเมซอนมากกว่า รายนี้เงียบกว่า apple อีก ส่วน apple คงไม่สนใจอยู่แล้ว ทำเอง

บล็อก: wannaphong.com และ Python 3

AWS มีโมเดลธุรกิจต่างกับเจ้าอื่นนิดหน่อยครับ มี Titan ของตัวเองแต่ก็ไม่ได้เน้นว่าเก่งกว่าของคนอื่น ลูกค้าอยากใช้ model ไหนก็ได้ตราบใดที่ใช้ infrastructure ของ AWS ในการ run

เอาเข้าจริงอะไรก็ไม่มีปัญหาครับ แค่ไปคุยก่อน แบ่งผลประโยชน์กันสักหน่อย

ส่วนรายเล็กๆ ต่อให้จ่ายก็ไม่กี่ตังค์ Meta ก็ปล่อยเลย

lewcpe.com, @wasonliw

ตอนแรกอ่านเป็น 70 Bytes

เล็กจัง