DeepMind ร่วมมือกับมหาวิทยาลัยออกซ์ฟอร์ดพัฒนาปัญญาประดิษฐ์อ่านปากอัตโนมัติ LipNet สามารถอ่านปากด้วยความแม่นยำถึง 93.4% ขณะที่ผู้เชี่ยวชาญสามารถอ่านปากได้แม่นยำเพียง 52.3% และระบบที่แม่นยำที่สุดก่อนหน้านี้ก็อ่านได้แม่นเพียง 79.6%

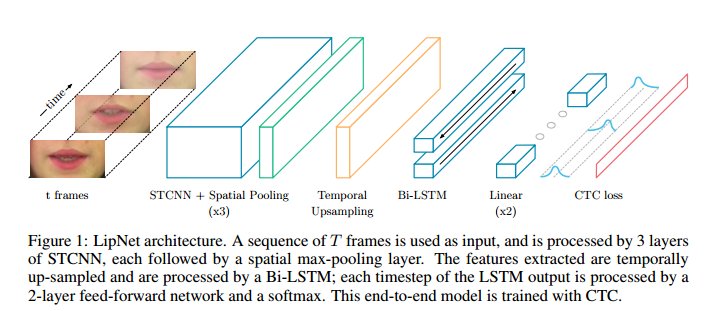

LipNet จับภาพปากของผู้พูดแล้วพยายามแยกเสียงเพื่อหาตัวอักษร โดยการทดสอบแรกใช้ชุดข้อมูล GRID ที่มีคำไม่มากนัก (51 คำ)

การทดสอบชุดล่าสุดด้วยข้อมูลวิดีโอจาก BBC ที่มีความยาวกว่า 5,000 ชั่วโมง และวิดีโอมีปัญหาเสียงไม่ตรงกับภาพในบางกรณี ปัญญาประดิษฐ์สามารถเรียนรู้จากวิดีโอเหล่านั้น และปรับแก้เสียงที่ไม่ตรงกับภาพได้เอง

ทีมงานใช้ข้อมูลรายการตั้งแต่ปี 2010 เป็นต้นมา และใช้ข้อมูล 6 เดือนล่าสุดเป็นข้อมูลทดสอบ พบว่าระบบยังคงทำนายคำพูดได้ถูกต้องถึง 46.8% ขณะที่ผู้เชี่ยวชาญการอ่านปากสามารถอ่านได้ถูกต้องเพียง 12.4% เท่านั้น

งานวิจัยเช่นนี้มีแนวทางนำไปใช้งานได้หลากหลายในอนาคต คอมพิวเตอร์จะสามารถสื่อสารกับมนุษย์ได้โดยที่เราไม่ต้องออกเสียงจริงๆ หรือการสื่อสารกับผู้ใช้ในพื้นที่ที่เสียงดัง

ที่มา - New Scientist, Technology Review

Comments

ดูปากนัดชานะ "เจ๋งมาก"

+1

"ว่าโต๊ะเธอ~"

เอิ่มม ประโยคนี้มันนน... (ยังเด็กอยู่ :)

เด็กสมัยที่ทันประโยคนี้สินะครับ :)

เหมือน Hans ใน Space odessy เลย น่าทึ่งจริงๆครับ

ถ้าอ่านได้หลายๆปากพร้อมกันได้ น่าเอามาใส่ในกล้องวงจรปิดนะ

น่าจะทำให้อ่านหลายปากๆได้ไม่ยาก แต่เท่าที่ตามไปดูตัวอย่างไฟล์ที่ใช้จะเป็น input ที่มุมกล้องชัดเจน แบบคลิปสัมภาษณ์

สรุปว่า ตอนนี้พัฒนาแบบปากเดียวไปก่อนเอาให้ความแม่นยำสูงกว่านี้

ในอนาคตจะเอาไปประยุกต์ เช่น ใส่กล้องวงจรปิด,ระบบSubtitleอัตโนมัติ อะไรก็ว่าไป

ถ้าได้ปากแรก ปากอื่นๆก็ไม่ยากแล้วครับ

แค่ให้ face recognition แยกหน้าคน

แล้วส่งปากแต่ละคนเข้าไป

เอามาใส่ใน Wearable Glasses