กูเกิลเคยเปิดเผยว่าระบบปัญญาประดิษฐ์ของตัวเองนั้นแม้จะรันด้วย TensorFlow ที่เป็นซอฟต์แวร์โอเพนซอร์ส แต่เบื้องหลังนั้นใข้ชิป Tensor Processing Unit (TPU) โดยระบุว่าการทำชิปด้วยตัวเองคุ้มค่ากว่า แต่ไม่มีรายละเอียดใดเพิ่มเติม ตอนนี้กูเกิลก็ปล่อยรายงานการศึกษาว่าการใช้ TPU นั้นคุ้มค่ากว่าจริงๆ

ภายใน TPU นั้นมีส่วนประกอบหลักคือบัฟเฟอร์กินพื้นที่ 29% ของตัวชิป และวงจรคูณแมทริกซ์กินพื้นที่ 24% ของตัวชิป สามารถคูณแมทริกซ์ได้ขนาด 256x256 นอกจากนี้ยังมีวงจรเฉพาะสำหรับการประมวลผลที่เกี่ยวข้อง เช่น Activation, Normalize/Pool ส่วนที่เหลือคือวงจรเชื่อมต่อภายนอกเช่น PCIe 3.0 x16, วงจรควบคุม DDR3 และวงจรควบคุมการทำงาน

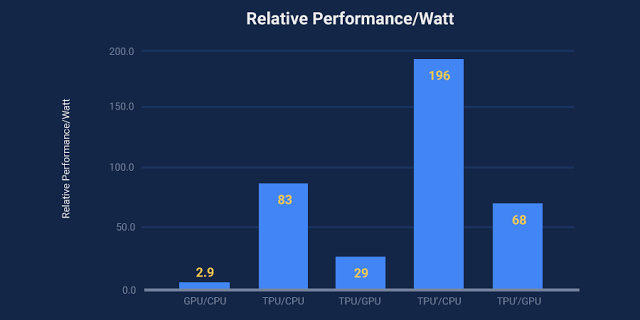

กูเกิลระบุเหตุผลที่ต้องใช้ชิปเฉพาะสำหรับการประมวล ว่าเป็นเพราะการใช้พลังงานโดยรวมมีประสิทธิภาพดีกว่า โดยแซงหน้าชิปกราฟิกไปตั้งแต่ 29-68 เท่าตัว เมื่อเทียบกับซีพียูแล้วประสิทธิภาพการประมวลผลต่อพลังงานดีกว่าซีพียู Haswell ตั้งแต่ 83-196 เท่าตัวเลยทีเดียว ขณะที่ความเร็วโดยรวมก็เร็วกว่าชิปกราฟิกถึง 15 เท่าตัว

ตัวการ์ด TPU นั้นติดตั้งในช่องฮาร์ดดิสก์ 2.5 นิ้ว แต่ตัวอินเทอร์เฟซใช้ PCIe 3.0 x16

ที่มา - Google Cloud Platform

Comments

Google เอามาปล่อยขายหน่อยเถอะ น่าจะแรงน่าดู

มันอาจจะได้ประสิทธิภาพแบบเต็มที่แค่งานเฉพาะของมันครับ (Deep Learning Algorithm)

Shut up and ヽ༼ຈل͜ຈ༽ノ raise your dongers ヽ༼ຈل͜ຈ༽ノ

ไม่ทำออกมาขายเลย อยากลองใช้

สร้างความได้เปรียบทางการค้าครับ ขาย API ใน Google Cloud คิดค่าใช้ต่อครั้งรวยกว่า

lewcpe.com, @wasonliw

คือต้องเปิดรัน 24/7 ถึงจะคุ้มค่าไฟที่สุด และมันเด็ดตรง matrix multiply chip

white paper:

https://drive.google.com/file/d/0Bx4hafXDDq2EMzRNcy1vSUxtcEk/view

ชิปเฉพาะด้านแบบนี้เอาไปปล่อยให้เช่าใน GCP เถอะ คุ้มกว่า

เห็นภาพแล้ว นึกถึงชิป ที่อยู่ในหัว T-800 ใน Terminator 2 เลย