กูเกิลประกาศเริ่มใช้งานโมเดลประมวลภาษาธรรมชาติ (natural language processing - NLP) แบบ deep learning ที่บริษัทโอเพนซอร์สออกมาเมื่อปีที่แล้วที่ชื่อว่า BERT ในการทำความเข้าใจคำค้นใน Google Search เพื่อให้เข้าใจความหมายของวลีที่ผู้ใช้กำลังค้นหาได้ดีขึ้น

ก่อนหน้านี้ผู้ใช้มักพยายามเพิ่มคำสำคัญที่ถูกต้อง เพราะเว็บค้นหามักใช้คำเหล่านี้ค้นฐานข้อมูล โดยไม่ได้ใช้คำขยายหรือคำบุพบทมาเป็นส่วนสำคัญ แต่การประมวลผลแบบ NLP ทำให้กูเกิลเข้าใจคำค้นได้ตรงความต้องการแม้จะค้นเหมือนพูดคุยกับคนอยู่ก็ตาม

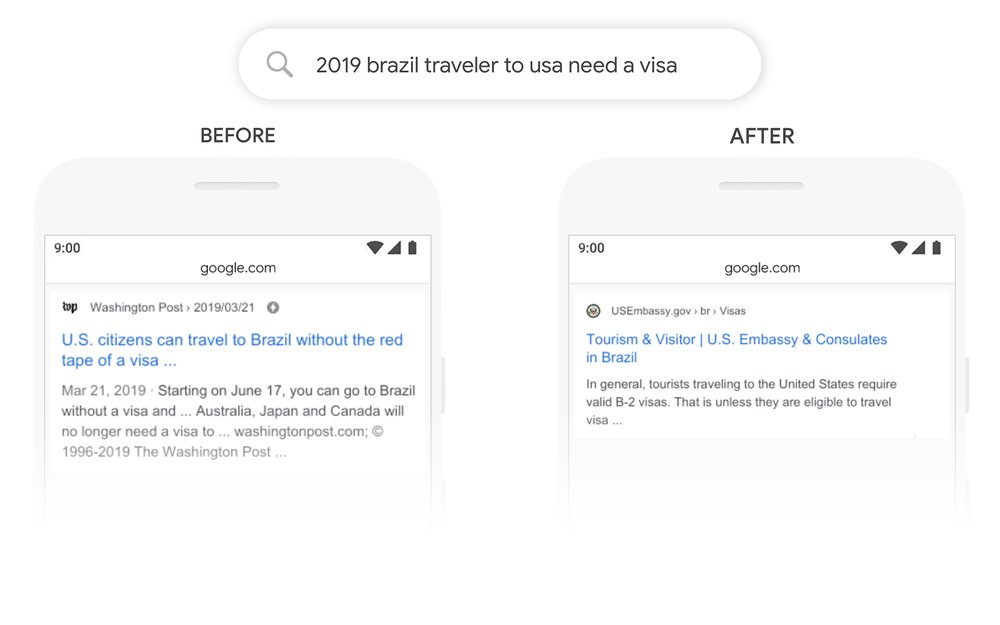

ตัวอย่างคำค้นที่กูเกิลยกตัวอย่าง เช่น "นักเดินทางชาวบราซิลไปสหรัฐฯ ต้องการหนังสือเดินทาง" ด้วยโมเดล NLP กูเกิลจะเข้าใจว่านักเดินทางนี้กำลังเดินทางไปจากบราซิล และต้องหาเว็บที่ให้ข้อมูลคนบราซิลเดินทางเข้าสหรัฐฯ

การใช้ NLP กับเว็บค้นหายังมีข้อจำกัดอยู่บ้าง คำค้นที่เป็นคำถามที่คนพูดกันปกติอย่าง และไม่มีคำสำคัญเกี่ยวข้องกันเลยก็มักจะให้ผลที่ผิดพลาดอยู่ โดยกูเกิลยกตัวอย่าง "รัฐอะไรที่อยู่ทางใต้ของรัฐเนบราสก้า" ผลที่ได้จะเป็นเมือง "เนบราสก้าใต้" อยู่ดี แม้มนุษย์ที่ไปดูแผนที่จะรู้ว่าเป็นรัฐแคนซัสก็ตาม

นอกจากการค้นหาแล้ว กูเกิลยังใช้ BERT สำหรับการประมวลผลเพื่อเลือกข้อความสำคัญมาแสดงผลในหน้าค้นหาส่วน featured snippets ในอีก 24 ภาษา

การรันโมเดล BERT ใช้บริการ Cloud TPU แบบเดียวกับที่ให้บริการ Google Cloud

ที่มา - Google Blog